В сети «Интернет» некоторое время назад возникло новое явление — т.н. дипфейки (deepfake), поддельный контент с наложением лиц и голосов известных людей на видеоматериалы различного содержания с применением технологий искусственного интеллекта. Мы расскажем о том, что такое Deepfake, чем он опасен и как подобные технологии могут использоваться киберпреступниками.

- Что такое дипфейк?

- Чем опасна технология Deepfake?

- Deepfake как ИБ-угроза для бизнеса

- Как бороться с дипфейками

- Бесплатные дипфейк-приложения и инструменты

- 5.1. DeepFaceLab

- 5.2. Doublicat

- 5.3. Zao

- Выводы

Что такое дипфейк?

Deepfake (от англ. deep learning — «глубокое обучение» и fake — «фальшивый») — реалистичная манипуляция аудио- и видеоматериалами с помощью искусственного интеллекта. Эта технология заставляет человека говорить то, чего он не произносил, и делать то, чего он никогда не совершал.

Технология Deepfake уходит корнями в далёкие девяностые. В то время подобными инструментами обладали лишь эксперты по спецэффектам в киноиндустрии. Впоследствии технология была доработана в интернет-сообществе, и программное обеспечение для создания дипфейков появилось в открытом доступе. В последнее время технология Deepfake привлекает большое внимание из-за её использования в финансовых махинациях, розыгрышах и фальшивых новостях (fake news).

Deepfake применяет возможности искусственного интеллекта для синтеза человеческого изображения: объединяет несколько снимков, на которых человек запечатлён с разных ракурсов и с разным выражением лица, и делает из них видеопоток. Анализируя фотографии, специальный алгоритм обучается тому, как выглядит и может двигаться человек. При этом работают две нейросети. Первая из них генерирует изображения, а вторая отвечает за поиск отличий между ними и настоящими образцами. В случае если вторая нейросеть обнаруживает подделку, изображение отправляется обратно первой для усовершенствования.

Deepfake работает при помощи открытых алгоритмов машинного обучения и библиотек, что позволяет достичь высшего качества контента. Нейросеть получает изображения из библиотеки и обучается при помощи роликов на видеохостингах. Искусственный интеллект тем временем сопоставляет фрагменты исходных портретов с тем, что есть на видео, и в итоге получается правдоподобный материал.

Чем опасна технология Deepfake?

В 2018 году появилась первая публичная программа для подмены лиц под названием FakeApp, которая открыла дипфейк-инструменты простому обывателю. Наборы для создания такого контента находятся с тех пор в свободном доступе и легки в освоении. Любой человек, который имеет доступ к интернету, свободное время, цели и мотивацию, может в режиме реального времени создавать фальшивый контент и наполнять им каналы социальных сетей.

Первые поддельные видеоролики стали появляться ещё в 2017 году. Поначалу большинство дипфейк-контента выглядело просто забавно: это были в основном любительские видеофайлы, созданные с использованием бесплатных инструментов и содержавшие лица знаменитостей, наложенные на порнографические записи. Однако за несколько лет технология развилась настолько, что создаваемые с её помощью материалы стали пугающе убедительными. Широкую известность она получила после того, как один из пользователей сайта Reddit с никнеймом Deepfakes разместил у себя на странице видео, где лицо актрисы из порнофильма удачно заменили на лицо актрисы Галь Гадот.

Дипфейки представляют собой серьёзную угрозу, так как подобного рода контент является, по сути, информационной атакой. IT-аналитики заявляют, что технология Deepfake может стать самой опасной в цифровой сфере за последние десятилетия. С распространением дипфейков появились случаи дискредитации известных людей, чьих фотографий много в сети «Интернет». В мире политики технология Deepfake может быть использована как оружие против отдельных деятелей и целых партий, чтобы манипулировать общественным восприятием, влиять на выборы или даже на фондовый рынок.

В качестве примера громкого дипфейка можно привести опубликованное в 2018 году фальшивое видео с экс-президентом США Бараком Обамой, где он якобы оскорбляет нынешнего главу американского государства. Видеоролик был сделан при помощи программ FakeApp и Adobe After Effects.

В середине 2019 года в Сети появилось сфабрикованное видео с Марком Цукербергом, который будто бы откровенно обрисовал текущее положение дел с персональными данными людей. В том же году в интернете опубликовали дипфейк-видео со спикером палаты представителей конгресса США Нэнси Пелоси. Автор ролика с помощью технологий искусственного интеллекта изменил речь Пелоси так, что она плохо выговаривала слова, и пользователи, посмотревшие видео, посчитали, что политик находится в состоянии алкогольного опьянения. Всё это переросло в большой скандал, и лишь спустя некоторое время было доказано, что речь Пелоси была сгенерирована компьютером.

В июне 2019 года пользователи увидели алгоритм DeepNude, который научился раздевать девушек на фотографиях. Если до этого подобные программы просто подменяли лица, то новый алгоритм самостоятельно перерисовывает тело героини снимка. Достаточно было загрузить изображение в программу и несколько секунд подождать.

Описанные события заставили правительство и промышленность Соединённых Штатов выявлять и ограничивать незаконное использование дипфейков. В октябре 2019 года губернатор Калифорнии Гэвин Ньюсом подписал документ AB 730, известный как «антидипфейк-законопроект», в котором говорится о запрете распространения дипфейк-видео во время предвыборной кампании в 2020 году.

В дополнение ко всему перечисленному существуют и технологии подделки голосов. Голосовые дипфейки также используются киберпреступниками — в частности, для того, чтобы убедить сотрудников какой-либо компании осуществить несанкционированные действия. Далее в статье мы расскажем об этом подробнее.

Deepfake как угроза для информационной безопасности бизнеса

Помимо политических информационных войн Deepfake создаёт и риски в области информационной безопасности корпоративного сектора. Дипфейки оказались неплохим инструментом в руках мошенников.

Например, целевой фишинг (англ. spearphishing) направлен на то, чтобы обмануть конкретных сотрудников определённой компании и заставить их выполнить вручную какую-нибудь операцию — оплату поддельного платёжного поручения, отправку документов, ручной сброс учётных данных пользователя для киберпреступника. Такие действия, как правило, труднее обнаружить технически (с точки зрения средств защиты информации), так как электронное письмо не содержит никаких подозрительных ссылок или вложений и обычно используется в сочетании с атакой Business E-mail Compromise (BEC), когда хакеры получают контроль над корпоративной учётной записью электронной почты и могут отправлять письма с легитимных адресов. По данным ФБР, за последние три года атаки типа BEC обошлись компаниям по всему миру более чем в 26 млрд долларов США.

Дипфейки имеют возможность «перегружать» подобные операции. Например, сотрудник компании получает электронное письмо от генерального директора с просьбой принять некоторые финансовые меры, затем ему приходит текстовое послание с мобильного номера того же топ-менеджера, а потом — и аудиосообщение, где голос генерального директора называет работника по имени и ссылается на предыдущие разговоры с ним. Скорее всего, сотрудник не задумается о том, дипфейк это или нет.

В качестве примера такой атаки можно привести инцидент, который произошёл в августе 2019 года в одной компании, которая работает в сфере энергетики. Было установлено, что киберпреступник использовал технологию создания дипфейков для осуществления мошеннических действий на сумму в 220 000 евро. Злоумышленник вышел на связь с финансовым отделом как управляющий из Германии. Он смоделированным голосом попросил срочно перевести деньги на счёт в Венгрии, и у бизнес-партнеров не было ни единого повода не верить звонящему.

Как бороться с дипфейками

Проблема дипфейков кажется весьма сложной. Поскольку они создаются с помощью искусственного интеллекта, для борьбы с ними нужно использовать нечто аналогичное.

В настоящее время рынок ИБ не предлагает специальных технологий и решений для защиты от дипфейков. Тем не менее, определённые шаги в данном направлении совершаются. Например, Facebook, Microsoft и исследователи из американских университетов начали разработку инструментов для обнаружения подобных подделок, а также в сотрудничестве с Amazon решили провести конкурс Deepfake Detection Challenge на лучший способ определения дипфейк-видео.

Управление перспективных исследовательских проектов Министерства обороны США (DARPA) запустило алгоритм выявления поддельных видеоматериалов. В статье «In Ictu Oculi: Exposing AI Generated Fake Face Videos by Detecting Eye Blinking» рассказывается о том, как анализ частоты моргания может помочь обнаружить дипфейк. Идея такова: обычно в открытом доступе трудно найти фотографии человека в момент моргания, так что нейронной сети просто не на чем учиться генерировать подобные кадры. Кроме того, у оригинала и подделки могут различаться некоторые примечательные части лица (подбородок, брови, скулы, усы и борода, веснушки и родимые пятна); любое несоответствие – свидетельство дипфейка. В качестве примера можно это увидеть на видео «Билл Хейдер пародирует Тома Круза с помощью нейросети».

Для того чтобы минимизировать риски целевых фишинговых атак при помощи дипфейков в корпоративной среде, необходимо информировать пользователей о новых типах вредоносной активности и быть начеку в ситуациях, когда поведение собеседника в телефонном разговоре или голосовом сообщении кажется необычным. Кроме того, рекомендуется:

- использовать многофакторную аутентификацию сотрудников, электронную подпись для защиты сообщений электронной почты,

- отслеживать факты наличия программ для создания дипфейков на компьютерах пользователей и попытки поиска таких приложений в сети «Интернет», обращать особое внимание на подобных работников и проводить в их отношении внутренние проверки,

- минимизировать число каналов коммуникаций компании,

- обеспечить согласованное распространение информации,

- ограничить фото- и видеоконтент с участием руководящих лиц предприятия,

- разработать план реагирования на дезинформацию (по аналогии с инцидентами безопасности),

- организовать централизованный мониторинг каналов и отчётность,

- внутри компании и для связи с контрагентами применять практику введения устных паролей, кодовых слов или контрольных вопросов, ответ на которые известен только двум сторонам,

- следить за новыми способами обнаружения дипфейков и методами борьбы с ними.

Чтобы показать, насколько доступным стало создание дипфейков, рассмотрим несколько примеров бесплатных программ для генерации подобного контента.

Примеры бесплатных дипфейк-приложений и инструментов

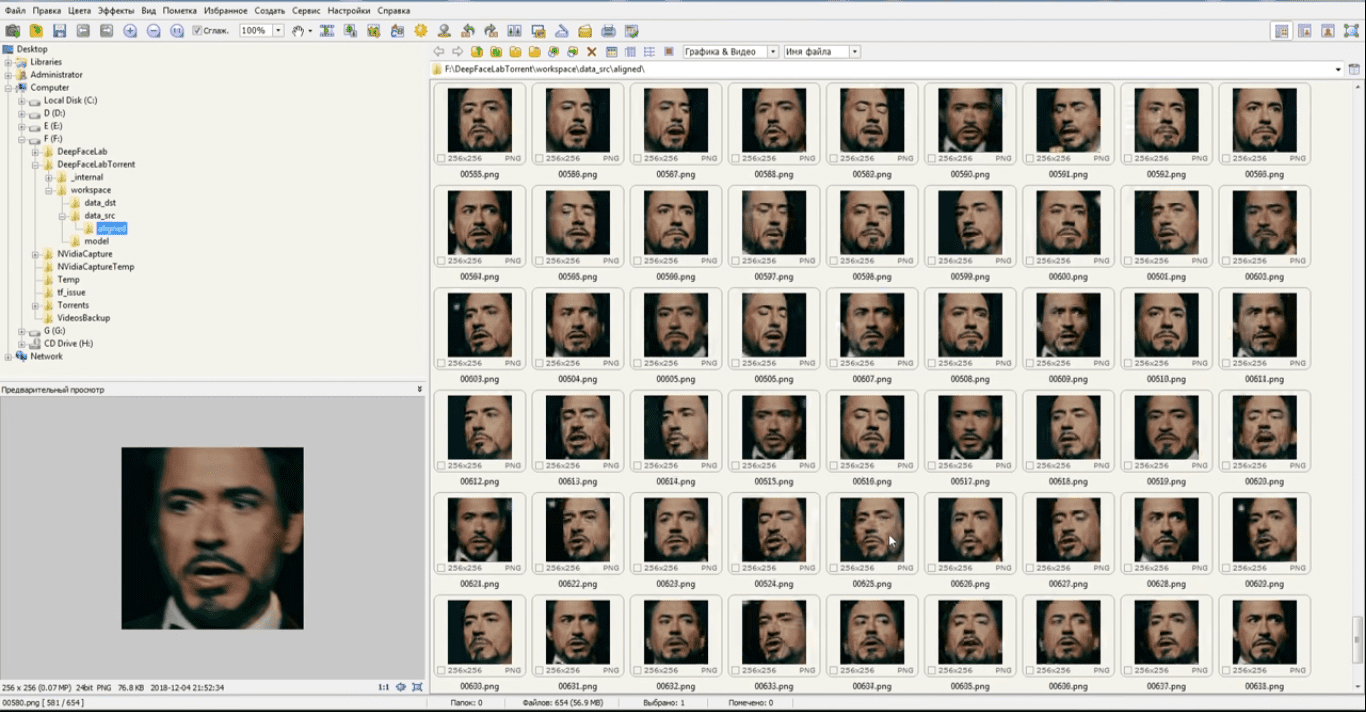

DeepFaceLab

Бесплатное ПО DeepFaceLab является одним из наиболее популярных приложений для создания дипфейков и использует новые нейронные сети для замены лиц в видео. Программа размещена на GitHub, исходный код выложен пользователем iperov. По словам разработчика, более 95% глубоких подделок видео создаётся с помощью DeepFaceLab.

Рисунок 1. Обработка изображения для создания дипфейка в ПО DeepFaceLab

DeepFaceLab распространяется в виде набора пакетных файлов для ОС Windows. Минимальные системные требования — 2 ГБ ОЗУ и место для файла подкачки, а также OpenCL-совместимая видеокарта с объёмом ОЗУ не менее 256 МБ.

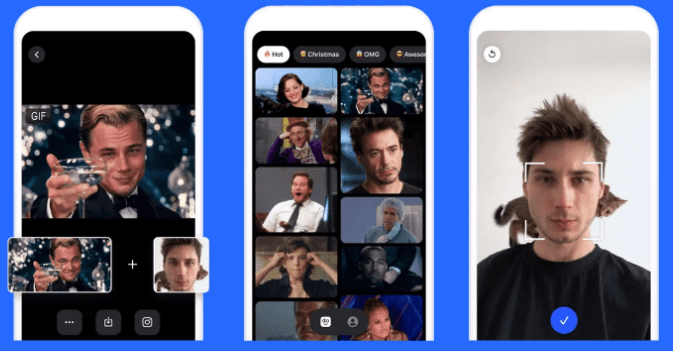

Doublicat

Разработчики сервиса Reflect в декабре 2019 года представили бесплатное приложение Doublicat для Android и iOS. Программа позволяет реалистично менять лица на двух фотографиях.

Рисунок 2. Обработка изображения для создания GIF-дипфейка в Doublicat

Для создания изображения нужно сделать селфи, а затем выбрать какой-либо из знаменитых GIF-мемов и вставить туда своё лицо.

В начале января приложение Doublicat стало вирусным. О нём написали десятки западных изданий.

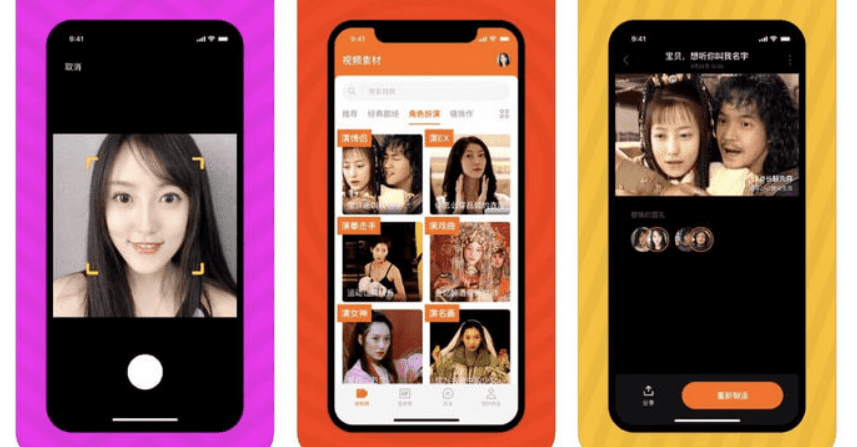

Zao

Бесплатное китайское дипфейк-приложение Zao для Android и iOS может заменить лицо известного героя или актёра на лицо пользователя в любом отрывке популярного фильма, сериала, шоу или клипа, и при этом не понадобится вдаваться в тонкости и нюансы монтажа и обработки видео. Zao позволяет модулировать голоса знаменитостей и накладывать своё лицо на тело актёра в сцене. Приложение предоставляет множество видеоклипов и нарядов, а также обширные возможности для изучения. В большинстве случаев результат выглядят не идеальным, но забавным.

Рисунок 3. Обработка изображения для создания видео-дипфейка в Zao

Многие пользователи сочли, что приложение может оказаться небезопасным, поскольку в политике конфиденциальности указано, что компания-разработчик Momo вправе применять сгенерированные видеоролики в собственных целях (т.е. ей принадлежит весь созданный программой контент).

Выводы

С распространением технологии Deepfake появилась опасность дискредитации любого пользователя, чей снимок или голос есть в общем доступе. Технологии создания дипфейков постоянно совершенствуются, и уже через несколько лет можно ожидать появления настолько естественно выглядящих или звучащих подделок, что выявить их можно будет только после тщательного анализа с использованием искусственного интеллекта.

При этом наиболее перспективные направления использования дипфейков — политические войны и мошенничество. Кроме того, с учётом постоянного совершенствования технологий дипфейки могут также навредить и судебной практике — в части доверия к аудио- и видеоматериалам доказательной базы (диктофонным записям, файлам видеорегистраторов и т.п.).

В настоящее время рынок ИБ не предлагает специализированных решений для защиты от дипфейков. Развитие инструментов, способных распознать поддельный контент, пока находится в зачаточном состоянии. Единственное решение, которое существует в настоящее время, заключается в том, чтобы информировать пользователей о новых типах атак и быть настороже относительно любого поведения, которое кажется необычным.