Разработанная исследователями методика, полагающаяся на ИИ, позволяет с высокой точностью установить наличие фишингового сайта между сервисом-мишенью и его пользователями. Такие угрозы обычно плохо детектятся и редко попадают в блоклисты.

Для начала сборная команда из Университета штата Нью-Йорк в Стоуни-Брук и Palo Alto Networks изучила (PDF) 13 ходовых фишинг-паков MitM. Спрос на такой продвинутый инструментарий, упакованный в ZIP-файл, последнее время растет: в отличие от обычных тулкитов для фишинга он позволяет воровать учетные данные на лету, из запросов пользователя к целевому сервису.

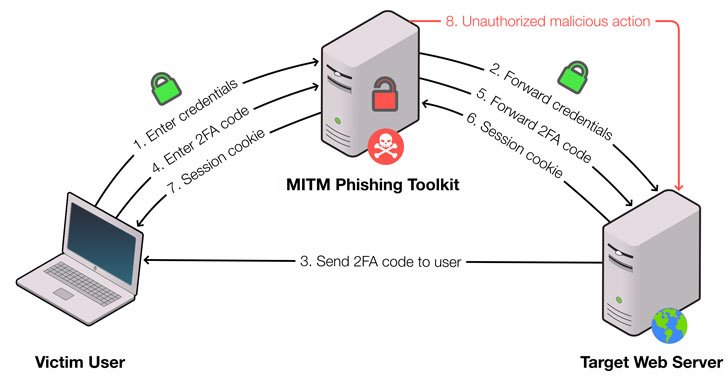

При MitM-сценарии атаки поддельный сайт-зеркало размещается между точками обмена и ведет перехват трафика, извлекая нужную информацию из сетевых пакетов. В итоге злоумышленник сможет получить не только логины-пароли, но и куки сессий, а также обойти двухфакторную аутентификацию (2FA).

Достоверность фишинговых страниц при использовании такого прокси не столь уж важна: иллюзию для жертвы поддерживает возможность просмотра других страниц сайта-ловушки после аутентификации. Сервис-оригинал при этом тоже вряд ли заметит подмену.

Как оказалось, подобные фейки живут дольше: исследование показало, что в блоклисты попадает лишь 43,7% доменов и 18,9% IP-адресов, ассоциированных с MitM-фишингом. Предложенный метод, по словам авторов, позволяет избавиться от слепой зоны и повысить точность детектирования до 99,9%.

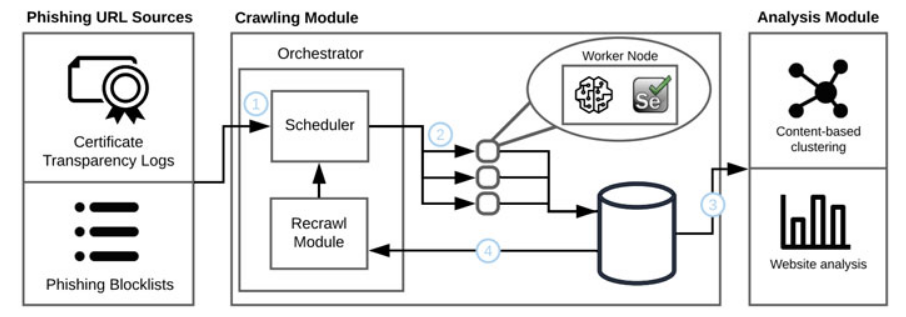

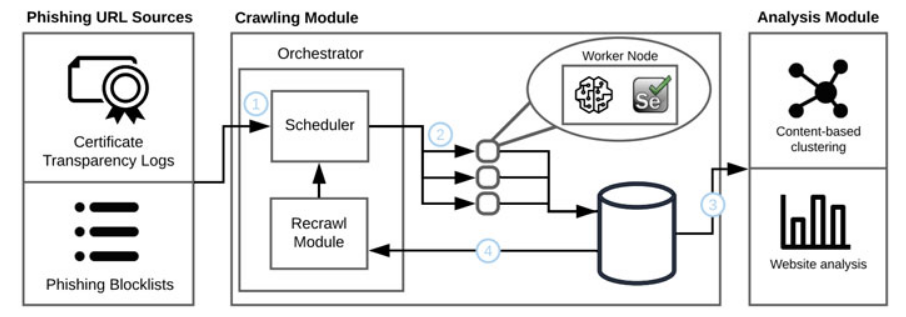

Для выявления умело спрятанных фальшивок исследователи создали самообучаемый классификатор, работающий с сетевыми данными — TLS-отпечатками, временем передачи и приема запросов. Сбор образцов для анализа проводился автоматизированными средствами — с помощью инструмента PHOCA собственной разработки, который выискивал нужную информацию в доступных базах по фишингу, таких как OpenPhish и PhishTank.

В качестве основного критерия были выбраны задержки: использование прокси-сервера (в данном случае с фиш-паком MitM) замедляет процедуру передачи и подтверждения запросов. При перехвате TLS-запросов отклонение от нормы становится еще более заметным.

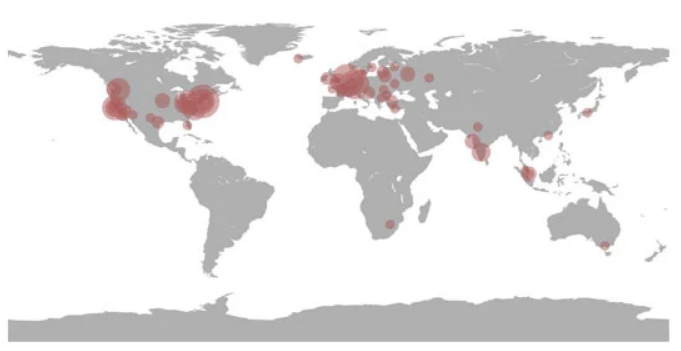

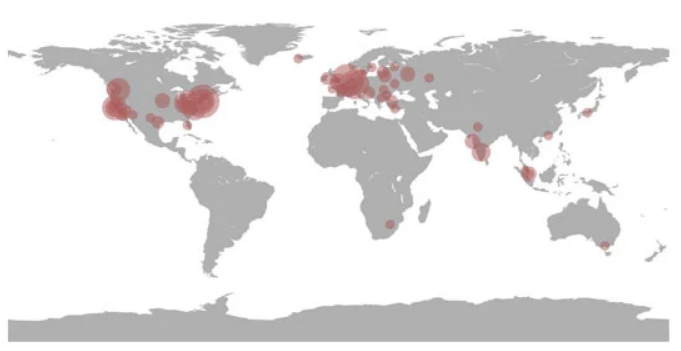

За год экспериментаторам удалось выявить 1220 сайтов, созданных для MitM-фишинга, — в основном в США и Европе, с хостингом у Amazon, DigitalOcean, Microsoft либо Google. Фальшивки чаще всего имитировали Instagram, Google, Facebook, Microsoft Outlook, PayPal, Apple, Twitter, Coinbase, Yahoo и LinkedIn. Изучение 260 таких ловушек показало, что за полгода они получили 6403 запроса от пользователей.

Фреймворк PHOCA, по словам исследователей, легко встраивается в существующую инфраструктуру. Он может, к примеру, расширить возможности веб-сервиса блоклистов или оградить популярный сайт от вредоносных запросов, генерируемых с помощью фишингового MitM-пака. Тестирование показало, что пробная методика позволяет обойти средства маскировки из арсенала таких тулкитов и эффективно выявить прежде скрытый фишинговый контент.