Злоумышленники придумали новый способ залезть в Android-смартфоны россиян, на этот раз под видом «полезного фитнес-приложения» для подсчёта калорий. Эксперты «Лаборатории Касперского» описывают схему так: в Telegram появляются чаты, которые маскируются под официальные каналы сети спортивных клубов, раздавая apk-файл с сюрпризом.

Фишка в том, что атакующие не просто кидают ссылку где попало, а стараются выглядеть «своими».

Они приглашают людей прямо из аудитории настоящего канала и с помощью ботов стирают системные сообщения о вступлении новых участников, чтобы у чата было меньше признаков «левого» происхождения и он походил на официальный.

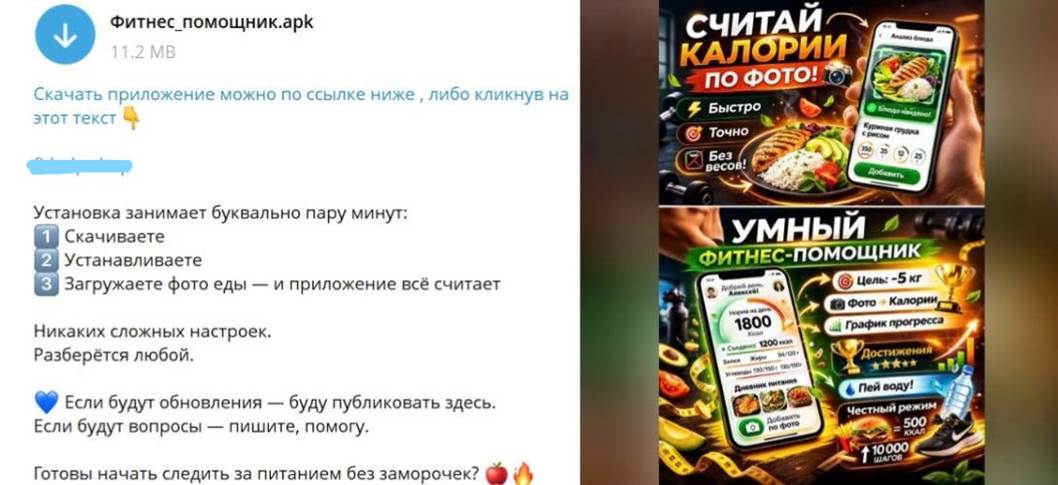

Дальше всё построено на эмоциях и выгоде: в чат отправляют сообщение якобы от имени клуба: мол, держите бесплатно приложение, которое умеет считать калории по фото, распознавать блюда, автоматически рассчитывать БЖУ, подбирать норму калорий под цель и рисовать график веса. Внутри — apk-файл (установщик Android-приложений) и ссылка на скачивание.

А вот дальше начинается самое неприятное. Скачанное «приложение» открывает поддельное окно якобы официального магазина и предлагает установить фитнес-помощник. Однако вместо него на устройство попадает дроппер — программа-загрузчик, чья задача незаметно подтянуть следующий этап атаки. В этом случае речь идёт о трояне для удалённого доступа BTMOB RAT (известен как минимум с 2024 года). Цель — кража денег и пользовательских данных.

Чтобы приманка не терялась в переписке, сообщение с «подарком» то исчезает, то появляется снова. Вероятно, его специально удаляют и публикуют заново, так оно регулярно оказывается наверху ленты и чаще попадается на глаза.

Эксперт по кибербезопасности «Лаборатории Касперского» Дмитрий Калинин подчёркивает: рассылка apk-файлов в мессенджерах — классическая тактика, а здесь дополнительно сыграли на сезонности: перед тёплым временем года бесплатный «фитнес-помощник» выглядит особенно заманчиво. Его рекомендация простая: проверять, от кого пришло предложение, и не ставить apk «по акции», если не уверены в источнике.