Специалистам CyberArk Labs удалось обнаружить уязвимость класса Local File Inclusion (LFI) в плагине Kibana для Elasticsearch. Бреши LFI позволяют атакующим получить данные из локального файла или выполнить его, это довольно распространенный способ взлома веб-приложений.

Обычно такого рода уязвимости используются для раскрытия конфиденциальной информации. Однако в некоторых случаях — например, в этом — этот вектор позволяет злоумышленникам выполнить код на сервере.

Обнаруженная CyberArk Labs уязвимость получила идентификатор CVE-2018-17246. В процессе ее поиска команда экспертов использовала инструмент Burp Suite от PortSwigger для прощупывания потенциальной поверхности атаки.

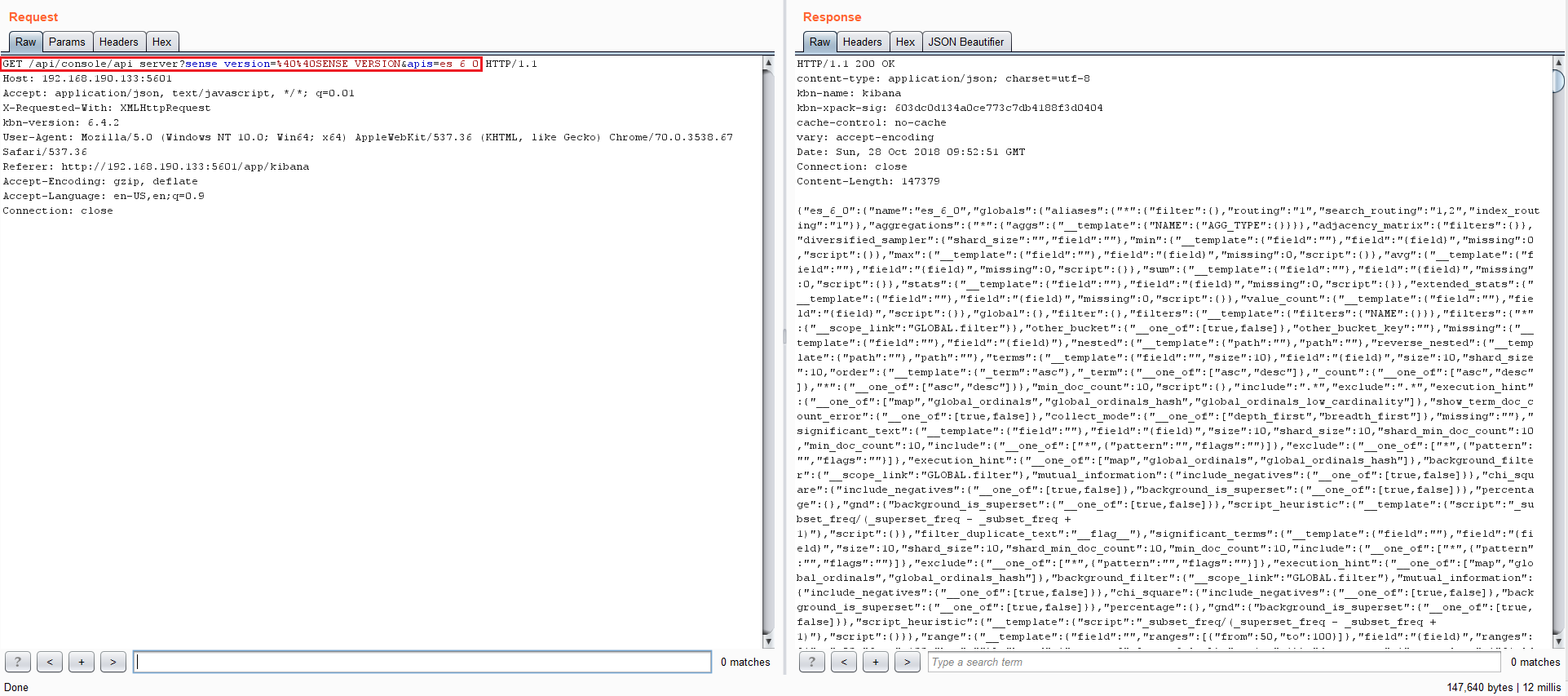

Среди горы информации эксперты обнаружили один HTTP-запрос, который привлек их внимание:

Запрос этот был интересен тем, что в нем содержалась отсылка к API консоли сервера. Исследователи поняли, что некоторыми функциями API можно манипулировать, или даже создать собственные функции.

Также специалистов заинтересовал кусок «es_6_0» — что это? Возможно, версия какого-либо программного обеспечения, которую можно пробить эксплойтом. Чтобы узнать это, эксперты начали слать множество запросов и смотреть, что они получают в ответ.

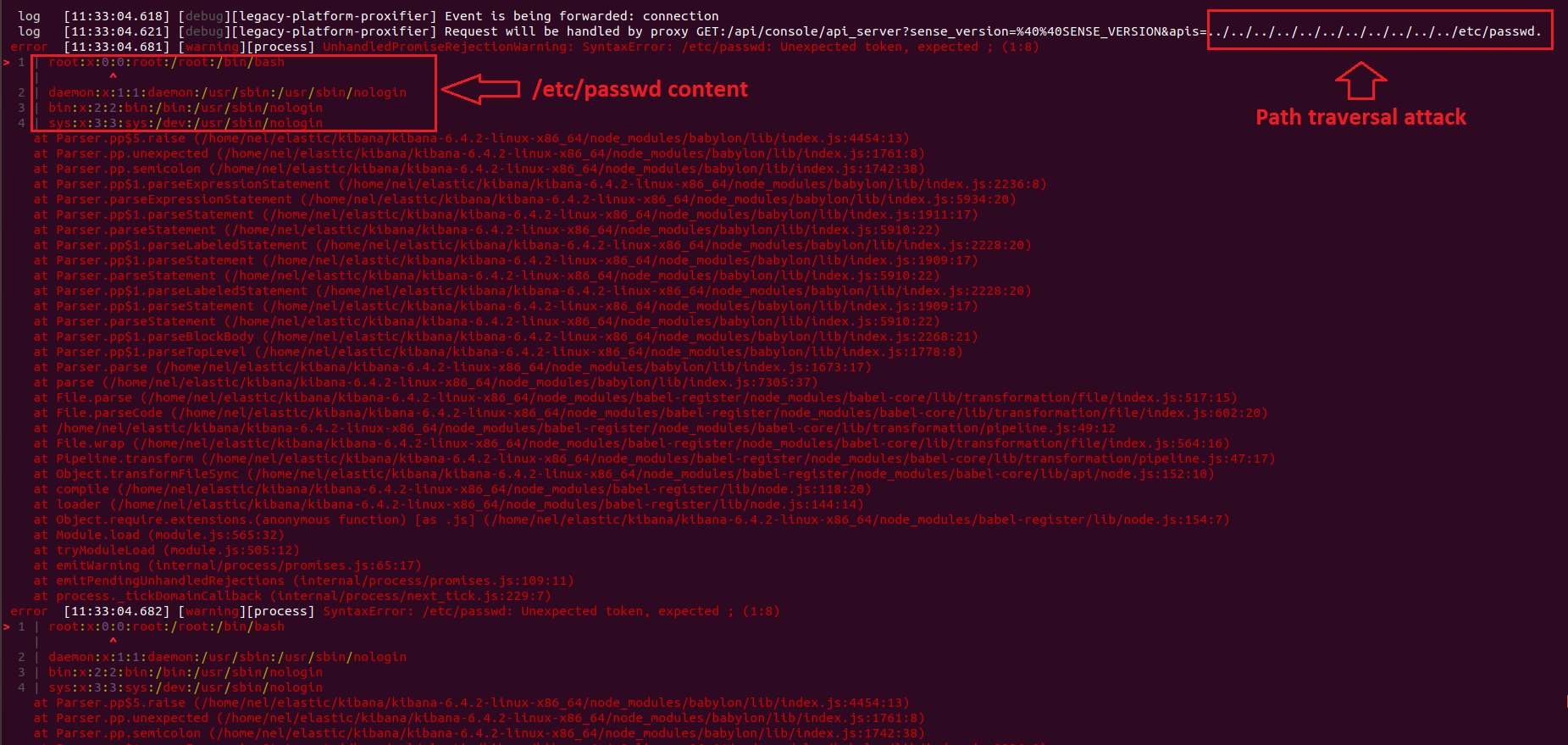

И тут один из запросов насторожил CyberArk Labs:

Так специалисты пришли к выводу, что они могут использовать атаку вида path traversal, чтобы получить доступ к некоторым локальным файлам системы.

CyberArk Labs передала разработчикам сведения об этой уязвимости, что позволило им быстро принять меры и выпустить патч.

С полным разбором этого бага можно ознакомиться в отчете CyberArk Labs по этой ссылке.