Искусственный интеллект — технология, которая стала популярным инструментом. Однако одно дело использовать AI/ML в качестве менеджера продаж или голосовых помощников, и совсем другое — внедрять модели в ИБ. Эффективность искусственного интеллекта в кибербезопасности остаётся под вопросом.

- Введение

- Искусственный интеллект на российском рынке

- Информационная безопасность и искусственный интеллект

- 3.1. Как злоумышленники применяют AI/ML для атак

- 3.1.1. Фишинговые атаки и дипфейки

- 3.1.2. DDoS-атаки

- 3.1.3. Обучение моделей

- 3.1.4. Генерация вредоносного кода

- 3.2. Искусственный интеллект для защиты от угроз

- 3.2.1. Технологии, применяемые в ИБ

- 3.3. Эффективность больших языковых моделей (LLM)

- 3.3.1. Как и где применяется LLM?

- 3.4. Проблемы ИИ в информационной безопасности

- 3.4.1. Решение проблем

- 3.1. Как злоумышленники применяют AI/ML для атак

- Выводы

Введение

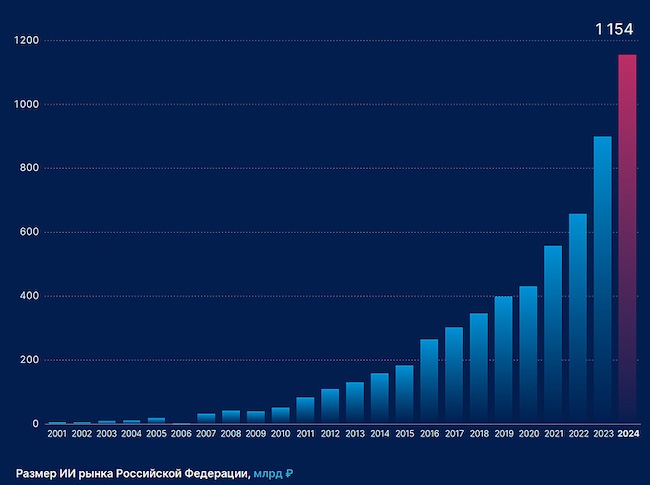

Среди многих людей возникают дискуссии о пользе или вреде ИИ-инструментов. И не удивительно, по данным РБК, в 2024 году объём отечественного рынка ИИ вырос на 38 % относительно показателей предыдущего года. А на 2025 год ожидается ещё больший рост.

Конечно, основная часть растущей популярности — это «хайп». Но всё больше искусственный интеллект находит реальное применение. ИИ используют в медицине, обучении и в быту. На российском рынке в 2024 году продажи «умных колонок» выросли примерно на 20 % в количественном выражении. И сегодня это не банальные музыкальные инструменты: их подключают к «умному дому», делая быт комфортным. В каждом смартфоне есть голосовой помощник, который может включить таймер, напомнить о важном событии и подсказать погоду.

Модели машинного обучения применяют в банковской сфере, для автоматизации бизнеса, для защиты от киберугроз, и даже для осуществления этих угроз. Применение искусственного интеллекта в ИБ может приносить как пользу, так и вред. И стоит разобраться, где заканчиваются реальные возможности технологий, а где начинаются раздутые ожидания.

Искусственный интеллект на российском рынке

Развитие ИИ началось с середины двадцатого века. Начиная с 2007 года рынок моделей машинного обучения в России стал стремительно расти. За последний год этот рост составил 28 %, и по всем прогнозам экспертов продолжит расти.

Рисунок 1. Размер рынка ИИ-технологий в России (источник: Tadviser)

Интересно, что в различных сферах ИИ развивается неравномерно. Самыми популярными ИИ-инструментами являются языковые модели и модели анализа данных. Используются они зачастую в маркетинге и продажах.

Рисунок 2. Области применения ИИ-технологий в процентах (источник: Tadviser)

Последние годы технология стала всё чаще применяться в ИБ. Это связано с тем, что ИИ позволяет легко автоматизировать трудоёмкие задачи и рутинные операции.

Информационная безопасность и искусственный интеллект

Использование искусственного интеллекта в кибербезопасности многогранно, его применяют как специалисты ИБ, так и злоумышленники.

Как злоумышленники применяют AI/ML для атак

Вокруг искусственного интеллекта много разговоров, не все готовы смириться с такой популярностью. И не зря, нейросети могут приносить не только пользу: их облюбовала киберпреступность. Мошенники применяют генеративные модели для создания реалистичного фейкового контента и используют уязвимости самих моделей. Популярные чат-боты, в которых сняты ограничения на выдачу ответов, подходят для написания вредоносного кода. Так что споры насчёт ИИ связаны с реальными рисками.

Фишинговые атаки и дипфейки

Одной из самых больших угроз современного интернета является фишинг. И для проведения такого рода атак злоумышленники активно используют различные генеративные модели.

Рисунок 3. Пример фейкового изображения, созданного нейросетью (источник: Securitylab)

Мошенники используют сгенерированные видео, фото и голос. С текущим уровнем технологий обычному пользователю затруднительно отличить такой контент от реального, поэтому всё больше людей попадают в эту ловушку.

DDoS-атаки

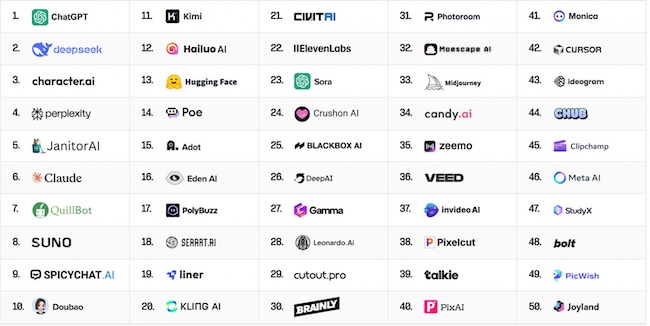

В некоторых современных моделях ИИ злоумышленники используют бреши. Так, можно использовать веб-краулер (поисковый бот) OpenAI для проведения DDoS-атак на произвольные сайты. Это одна из последних обнаруженных уязвимостей современной модели. Вдобавок к этому развиваются альтернативные решения. Появляется всё больше различных аналогов, например, популярный сейчас DeepSeek.

Рисунок 4. Популярные ИИ-продукты (источник: Habr)

Создателям нейросетей стоит всерьёз задуматься о безопасности своих платформ.

Обучение моделей

Потеря данных может произойти во время обучения различных генеративных моделей. Поскольку для обучения используются большие объёмы данных, это делает такие утечки особенно опасными. Злоумышленники могут использовать атаки с уклонением для получения конфиденциальной информации, которая могла использоваться при обучении.

Существует и другая проблема при обучении, которая заключается в качестве самих данных: они могут быть нерелевантными, ложными. Также существует возможность дообучения моделей в преступных целях. Поэтому важно ответственно подходить к отбору и фильтрации обучающих материалов.

Генерация вредоносного кода

Количество чат-ботов растёт, это становится проблемой ещё и потому, что существуют модели, в которых нет ограничений по выдаче ответов. А значит, они способны помогать злоумышленникам в создании кода. Обычно это локальные ИИ-боты, которые мошенники разворачивают самостоятельно.

Но если не генерировать весь код, а только отдельные его части, можно использовать и популярные, проверенные решения. Так, стало известно о вредоносной программе, которая обращается к GPT-4 от OpenAI. Проблема в том, что она делает это прямо во время проведения атаки, которая проходит непредсказуемо, что сильно усложняет процесс обнаружения и защиты.

Искусственный интеллект для защиты от угроз

Машинное обучение в ИБ применяется уже давно, однако такого же «бума», как и в других сферах, не случилось. Искусственный интеллект зачастую принимает форму чат-ботов, которыми пользуются специалисты. Медленное развитие относительно других областей связано в первую очередь со спецификой. Сотрудники ИБ осторожно подходят к внедрению ИИ из-за большой ответственности, малого объёма данных для обучения моделей и несовершенства технологий.

На форуме GIS DAYS 2025 обсуждалось, как развитие искусственного интеллекта меняет подходы в информационной безопасности.

Рисунок 5. Форум GIS DAYS 2025 (источник: GIS DAYS 2025)

Спикеры обсуждали тот факт, что в ИБ используются большие языковые модели (LLM) для анализа кода и защиты баз данных. AI/ML находят широкое применение в защите от кибератак.

Технологии, применяемые в ИБ

Особенно полезными ИИ являются в тех случаях, когда нужен анализ больших данных, поэтому в ИБ используются следующие инструменты:

- Анализ сетевого трафика (IDS / IPS) и сетевое детектирование и реагирование (NTA / NDR): позволяют выявить злоумышленников, которые уже преодолели защиту.

- Машинное обучение для обнаружения вредоносных программ: готовится большой набор скриптов, и на их основе обучается нейронная сеть.

- Автоматизация рутинных процессов в ИБ позволяет узконаправленным специалистам сосредоточиться на более сложных и важных задачах.

Специалисты информационной защиты активно развивают инструменты искусственного интеллекта. Используют нейросети не только в качестве отдельных инструментов для решения конкретных задач, но и встраивают различные модели в сервисы ИБ.

Эффективность больших языковых моделей (LLM)

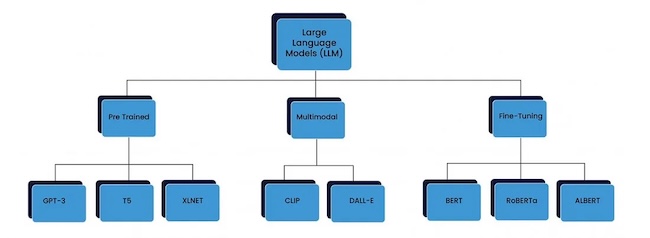

LLM представляет собой большую генеративную модель, которая способна обрабатывать и генерировать данные.

Рисунок 6. Классификация LLM по трём категориям (источник: Habr)

LLM делятся на языковые модели, которые обучались на огромных текстовых массивах, и мультимодальные модели, способные генерировать и читать изображения.

В последнее время в научной литературе наблюдается повышенный интерес к применению LLM для киберзащиты. Научные работы подтверждают эффективность использования искусственного интеллекта за счёт того, что он способен обучаться на текстах по кибербезопасности.

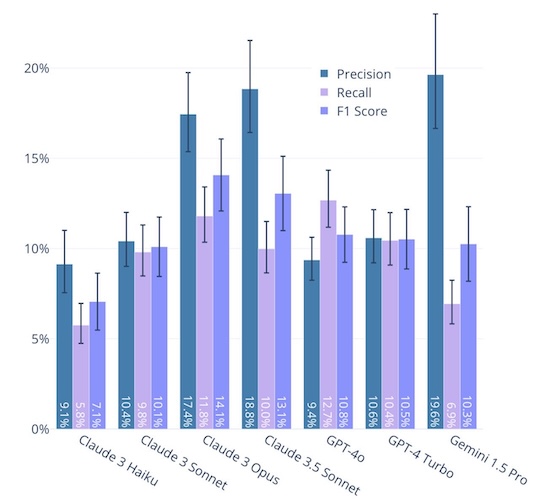

Искусственный интеллект вызывает не только научный интерес, но и практический. Генеративные сети применяются для обработки данных и активно используются специалистами. Однако использовать их стоит всё же с осторожностью. Исследования Дениса Макрушина показывают, что лучше использовать ИИ в качестве ассистента и контролировать работу чат-ботов.

Рисунок 7. Точность, полнота и F1-мера моделей на наборе данных eyeballvul (источник: Makrushin)

Искусственный интеллект действительно является эффективным инструментом. Однако он не способен самостоятельно заниматься поиском уязвимостей. Пока в столь важных областях без человека не обойтись.

Как и где применяется LLM?

Для того чтобы понимать эффективность больших генеративных моделей, нужно разобраться, как же всё-таки они используются в ИБ. И вот несколько реальных кейсов:

- Компания по стратегическому управлению цифровыми рисками BI.ZONE внедрила в свои программы ИИ-ассистента, который помогает оперативно выявлять инциденты. ИИ-агент, который называется Cubi, ускоряет первичный анализ и обработку данных, автоматизируя рутинные задачи.

- LLM применяется в SLFHunter для выявления внедрений команд в приложения на базе Linux. Технология позволяет выявлять уязвимости с точностью 95 %.

- Kaspersky Threat Lookup, который позволяет выполнять поиск с использованием искусственного интеллекта. «Лаборатория Касперского» сделала автоматизированную программу для поиска данных из открытых источников (Open source intelligence, OSINT), её могут использовать специалисты по кибербезопасности для проведения исследований и быстрого поиска нужной информации.

Очевидно, что генеративные модели нашли своё применение в области защиты от киберугроз. Возможно, масштабы использования ещё невелики, однако с развитием технологий будет увеличиваться и их роль в кибербезопасности.

Проблемы ИИ в информационной безопасности

Безусловно, использование ИИ в киберпреступности является существенной проблемой, при этом не налажено применение искусственного интеллекта для защиты от атак. Как упоминалось ранее, в ИБ искусственный интеллект используется реже, чем в других областях. Это связано с угрозами, которые могут возникать при применении ИИ:

- Объём профессиональной литературы для обучения моделей недостаточен, чтобы хорошо обучить ИИ. Нехватка материально-технической базы является проблемой не только для изучения искусственного интеллекта, но и для подготовки новых кадров.

- Галлюцинации — одна из опаснейших проблем, связанных с использованием ИИ. Не стоит сильно доверять искусственному интеллекту, поскольку он способен выдавать ложные факты за действительность. Это вызвано недостаточностью данных при обучении, вследствие чего модели «додумывают» ответы.

Именно на этапе обучения возникают сложности, которые затем приводят к снижению эффективности технологии применимо к ИБ.

Решение проблем

Если говорить глобально, то самая важная задача — уделить усиленное внимание обучению моделей. Однако это длительный и сложный процесс, уйдут годы, прежде чем накопится достаточное количество материалов. Но ИИ можно использовать в текущей ситуации — и его используют.

Важно уделить внимание тому, как применяется искусственный интеллект в ИБ, и выстроить систему правил:

- Использовать ИИ для автоматизации рутинных задач без права принятия решений.

- Специалисты должны перепроверять ответы.

- Применять проверенные модели.

Это простые, но важные правила, которые стоит соблюдать. К сожалению, сегодня искусственный интеллект в информационной безопасности применим только в качестве человеко-машинного интерфейса. Использовать инструмент по максимуму возможно только в случае осознанного подхода.

Выводы

Несмотря на то что существует множество рисков, связанных с использованием AI/ML, не стоит демонизировать их. Большие маркетинговые кампании по продвижению ИИ и различные обсуждения технологий говорят о возрастающей популярности решения.

Использовать нейросети в ИБ можно и нужно, но стоит аккуратно подходить к этому вопросу. ИИ можно применять и в вопросах киберзащиты. Успешные кейсы будут зависеть от умения специалистов адаптироваться под новую реальность. Современные модели не могут заменить профессионала, но могут стать «цифровым ассистентом», который облегчает и ускоряет работу. Важно не забывать об ограничениях и рисках, и тогда не будет сомнений в эффективности ИИ.