Искусственный интеллект тоже нуждается в защите. Практике обеспечения безопасности ИИ дали название MLSecOps. Она объединяет машинное обучение, борьбу с угрозами и автоматизацию (DevOps) для создания надёжных систем. Эксперты AM Live обсудили, как оградить ИИ-модели от кибератак и скрытых ошибок.

- Введение

- Что такое MLSecOps?

- Что нужно защищать в рамках MLSecOps?

- Машинное обучение и большие языковые модели: разница с точки зрения ИБ

- Какие модели угроз принесло машинное обучение?

- Когда внедряется защита моделей машинного обучения?

- На каком этапе включается MLSecOps при внедрении ML в организации?

- Улучшат ли ситуацию регуляторные требования?

- Что может помочь в освоении MLSecOps?

- Выводы

Введение

Машинное обучение давно перестало быть лабораторным экспериментом и стало краеугольным камнем современных цифровых продуктов — от беспилотных автомобилей и систем диагностики до кредитного скоринга и чат-ботов. Но вместе с мощью пришла и уязвимость. Что, если вашу модель можно обмануть, заставив её увидеть несуществующие объекты? Или «отравить» данные из обучающей выборки так, что она начнёт дискриминировать определённые группы пользователей или выдавать конфиденциальную информацию?

Кибератаки сегодня нацелены не только на серверы и базы данных, но и на саму интеллектуальную основу бизнеса — алгоритмы. MLSecOps — это ответ на эти вызовы: новая дисциплина, которая объединяет машинное обучение, безопасность и практики DevOps, чтобы создавать и развёртывать ИИ-системы, которым можно доверять.

Рисунок 1. Эксперты в студии AM Live

Участники эфира:

- Денис Турдаков, руководитель исследовательского центра доверенного искусственного интеллекта, ИСП РАН.

- Антон Конопак, руководитель отдела DevSecOps, «Инфосистемы Джет».

- Александр Лысенко, ведущий эксперт по безопасной разработке, «К2 Кибербезопасность».

- Светлана Газизова, директор по построению процессов DevSecOps и безопасности ИИ, Positive Technologies.

- Антон Башарин, старший управляющий директор, AppSec Solutions.

- Игорь Бирюков, генеральный директор InfEra Security.

Ведущий и модератор эфира — Алексей Лукацкий, бизнес-амбассадор (Chief Evangelist Officer) Positive Technologies.

Что такое MLSecOps?

Денис Турдаков объяснил, что создание систем, которые используют машинное обучение (ML), — это в любом случае разработка программного обеспечения. Методология DevSecOps никуда не уходит, все инструменты разработки безопасного ПО должны применяться. Специфика заключается в понимании машинного обучения. Это альтернативный подход, который позволяет решать задачи по аналогии. Есть много задач, решение которых сложно описать алгоритмически, но легко сделать много примеров решения. Как из множества существующих алгоритмов выбрать тот, который будет хорошо решать эту задачу? Этим занимается ML. Есть принципиальная разница и из-за неё возникают новые угрозы безопасности. Подход ML — про данные, а не про код.

Александр Лысенко добавил, что ML-модели не существуют в вакууме, они работают в составе какого-то приложения, информационной системы. DevSecOps по-прежнему актуален, просто появились новые практики, дополнительные направления, которые нужно покрывать.

Александр Лысенко, ведущий эксперт по безопасной разработке, «К2 Кибербезопасность»

Антон Конопак считает, что MLSecOps — это дополнительная надстройка к DevSecOps. При этом появляются очень специфичные требования к специалистам — человек, который защищает ML, должен быть немного математиком, лингвистом, понимать, как устроена обвязка вокруг модели. Всё это должно быть в одном человеке, который устанавливает или настраивает эти инструменты.

Антон Башарин:

«Самое важное, что появляется в MLSecOps — это защита данных (Data Security). По обучению и подготовке алгоритмики, работе с финальной моделью это напоминает DevSecOps, но Data Security — то, что выделяет и наделяет его новыми процессами. Это особенность, которой не было в DevSecOps».

Светлана Газизова рассказала, что сейчас в компаниях пытаются определить место безопасности ИИ внутри направления DevSecOps, безопасности приложений (Application Security) или продуктовой безопасности. Скорее всего, это неправильный подход. Безопасность ИИ связана с математикой, разработкой модели. Человеку, который работает с кодом или с техническим обеспечением, будет тяжело работать в наступательном (offensive) режиме для моделей.

Пока нет возможности дообогатить знаниями классический мир кибербезопасности так быстро и насыщенно, чтобы приблизить знания AppSec-специалиста или пентестера до чёткого понимания, как устроена архитектура модели, как происходит её инференция и т. д.

Светлана Газизова, директор по построению процессов DevSecOps и безопасности ИИ, Positive Technologies

Игорь Бирюков уверен, что MLSecOps — это развитие направления DevSecOps, которое автоматизируется — безопасность, написание кода, сборки. То, что развитие идёт в сторону применения ИИ — это естественный ход событий. У заказчиков ещё не сформировалась зона ответственности за ML. В разных организациях за это отвечает директор по ИБ (CISO), директор по информатизации, а где-то уже созданы подразделения. Скорее всего, всё упирается в бюджеты и кадровый голод на рынке. Это направление сейчас только ищет своё место.

Что нужно защищать в рамках MLSecOps?

Александр Лысенко уточнил, что в информационной безопасности всегда защищают данные и процессы. Нужно исходить из того, какие риски и проблемы могут привести к атаке на приложение с ML, именно на те процессы и данные, которые есть в конкретной компании. Сама безопасность должна идти сквозной нитью, начиная со сбора датасета, Data Security и заканчивая рантаймом, где нужно вести мониторинг событий или агентов. Стоит учитывать, что при выстраивании безопасности нужно исходить от формата модели и того, что она делает. Отсюда будет понятно, какие есть киберугрозы.

Игорь Бирюков напомнил, что ИБ — сформированная отрасль с регуляторикой, правилами, концепциями. Работа ведётся с теми же данными, исходя из накопленного опыта. В любом случае заимствуются практики из информационной безопасности. Пока нет точного законодательства и требований по ИИ, но есть незначительное количество документов, на которые можно ссылаться — ГОСТ Р 56939-2024 по безопасной разработке (рекомендательный) и несколько зарубежных документов, которые описывают уязвимости. Сейчас ничего не остаётся, как применять практики из классического ИБ, сформированные до появления ИИ. Пока нет тех инструментов, которые полностью защитят весь цикл.

Игорь Бирюков, генеральный директор InfEra Security

Машинное обучение и большие языковые модели: разница с точки зрения ИБ

Алексей Лукацкий поинтересовался, нужно ли разделять эти понятия с точки зрения кибербезопасности. По идее, это разные вещи: ML делаем у себя, обучаем модели, находим датасеты — свои или внешние. С большими языковыми моделями (LLM) проще — отправил запрос, получил ответ, не нужно никого обучать, развивать модели. В организации должно быть два разных процесса или это один процесс с отдельными нюансами?

Денис Турдаков объяснил, что LLM — это просто более специфичный случай ML. Все задачи, которые есть в MLSecOps, относятся и к LLM, но есть дополнительные особенности больших языковых моделей, которые выходят за рамки классических подходов. Появляются новые способы применения LLM, новые приложения, в их отношении возникают дополнительные вопросы безопасности. Американская компания MITRE ежегодно составляет матрицу угроз, в которой появились около десяти новых записей, и все они связаны с LLM.

Денис Турдаков, руководитель исследовательского центра доверенного искусственного интеллекта, ИСП РАН

Игорь Бирюков добавил, что LLM — это некий подвид ML, угрозы у них абсолютно разные, так как различается функциональность.

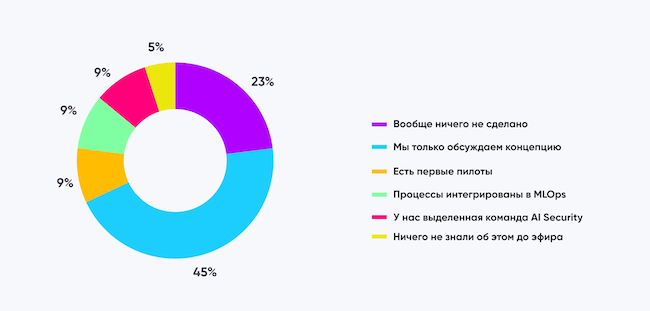

В первом опросе зрители поделились, как они оценивают зрелость MLSecOps в своей компании: только обсуждают концепцию — 45%, вообще ничего не сделано — 23%, есть первые «пилоты» — 9%, процессы интегрированы в MLOps — 9%, есть выделенная команда — 9%, ничего не знали об этом до эфира — 5%.

Рисунок 2. Как вы оцениваете зрелость MLSecOps в своей компании?

Какие модели угроз принесло машинное обучение?

Антон Башарин считает, что отравление данных — самая очевидная угроза, при которой злоумышленник намеренно компрометирует обучающий набор данных, используемых моделью. Другие популярные угрозы — промпт-инъекции (взлом ИИ через специально составленный запрос для перехвата управления), джейлбрейк (снятие программных ограничений для получения полного доступа к ОС) — угрозы, относящиеся к большим языковым моделям.

Антон Башарин, старший управляющий директор, AppSec Solutions

Александр Лысенко заметил, что появилась большая связанность между данными и поведением. Отравление данных влияет на бизнес-процессы более явно и сильно. Раньше можно было работать с постоянными ответами и величинами. Сейчас есть неопределённости, которые не покрывают классические инструменты. Новые классы угроз — дрейф (устаревание модели и данных), отсутствие гарантии срабатывания системы безопасности. При использовании агентов, где модели могут сами выполнять какие-то действия, всегда есть доля неопределённости.

Светлана Газизова привела пример: в компании выстраивали мультиагентную систему, чтобы люди внутри могли быстро обмениваться документами, искать информацию. Изначально агент обладал правами администратора. Любой человек, несмотря на свои ограничения доступа к бухгалтерским документам, финансовой отчётности, мог получить всю информацию через агента. Защита ML — вопрос интересов компании и модели использования чат-бота, и определяется тем, насколько важны репутационные риски.

Денис Турдаков предупредил, что угроз много, их можно классифицировать по жизненному циклу разработки модели — уровень датасета, обучения, применения. Есть несколько примеров: компания хотела использовать ML для системы анализа трафика. Взяли открытые данные из интернета, обучили. При работе обнаружили много ошибок, для их исправления назначили условный признак, обозначили им моменты, когда нет вторжения и обучили на этом модель. Злоумышленник может убрать признак и спокойно попасть в систему. Есть физические атаки с использованием патчей для машинного зрения.

Антон Конопак назвал ещё одну важную угрозу — утечка самой модели, когда много ресурсов затрачивается на обучение модели, а потом её просто крадут. В итоге конкурент появляется на пустом месте. Если чат-бот обучен по информации с сайта компании, скорее всего, его не нужно защищать. Но если он имеет доступ к персональным и конфиденциальным данным, могут быть проблемы с утечками.

Антон Конопак, руководитель отдела DevSecOps, «Инфосистемы Джет»

Когда внедряется защита моделей машинного обучения?

Светлана Газизова уверена, что в любой точке найдётся то, что можно проверить. Но на практике даже в максимально адекватном варианте всё будет упираться в отсутствие нормальных инструментов защиты и проверки. Даже если рассматривать лучшие зарубежные практики, там нет хороших инструментов, которые позволяют проверить атаки уклонения, создать суррогат модели. Нет возможности сделать хороший тестовый датасет, нет бенчмарков. Нельзя проверить, что какой-то инструмент работает лучше, чем другой в аналогичном классе.

Александр Лысенко успокоил, что это только начало пути, поэтому инструментов мало. Они будут появляться, но нужно понимать, что не все практики можно покрыть накладными средствами. Есть ряд практик, концепций безопасности, которые должны применяться в процессе обучения, сбора. Например, состязательное обучение (Adversarial Training) — его нужно делать в процессе обучения встраиваемыми инструментами.

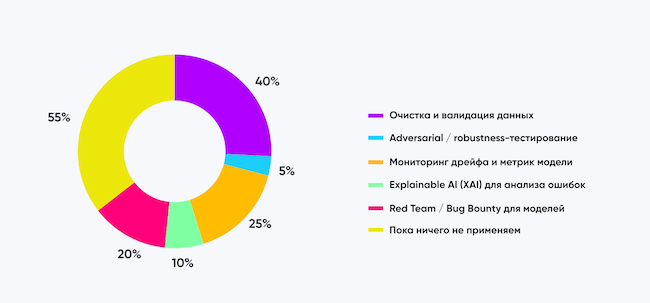

Второй опрос показал, какие практики защиты ML-систем уже применяются в компаниях (мультивыбор):

- Очистка и валидация данных — 40%.

- Мониторинг дрейфа и метрик модели — 25%.

- Red Teaming / Bug Bounty для моделей — 20%.

- Интерпретация ИИ (XAI) для анализа ошибок — 10%.

- Состязательное тестирование и проверки надёжности — 5%.

Пока ничего не применяют 55% зрителей.

Рисунок 3. Какие практики защиты ML-систем уже применяются в вашей компании? (мультивыбор)

На каком этапе включается MLSecOps при внедрении ML в организации?

Антон Конопак считает, что MLSecOps должен проникать в самом начале, когда есть описанный процесс, как и откуда собирать данные, какие задачи нужно выполнять при классификации данных, как они должны быть описаны. Необходимо проверять качество этих данных, их происхождение нужно контролировать с самого начала.

Светлана Газизова не видит возможности обеспечить проверку всех данных из-за динамичности. Можно выстраивать процесс, приблизительно понимая, какие и откуда данные попадают, и делать разовые выборки для проверки выдачи модели. Необходимо отслеживать аномалии в том, что выдаёт модель, чтобы понимать, были ли в первичном датасете внесены изменения. В целом этот процесс тяжело контролировать со стороны ИБ-специалиста, поэтому проще выполнять функцию модерации с помощью выборочных проверок.

Алексей Лукацкий предупредил, что нет однозначных рецептов для решения задач MLSecOps, так как отрасль находится в самом начале пути. Есть огромное количество сложностей при его внедрении.

Алексей Лукацкий, бизнес-амбассадор (Chief Evangelist Officer) Positive Technologies

Антон Башарин считает, что нужно начинать с модели угроз — на начальном этапе определить, от чего защищаемся. Александр Лысенко упомянул старую практику из ИБ, когда доступ к данным должен авторизовывать владелец данных в месте их обработки.

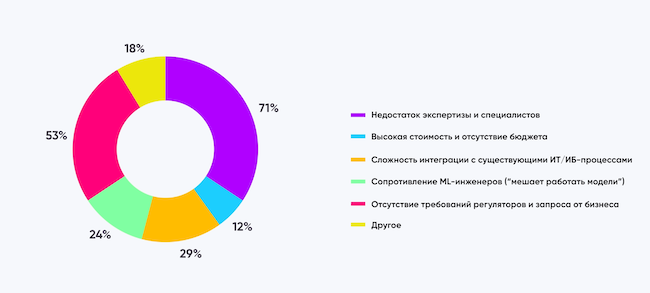

В третьем опросе выяснилось, что мешает внедрению MLSecOps в организациях (мультивыбор):

- Недостаток экспертизы и специалистов — 71%.

- Отсутствие требований регуляторов и запроса от бизнеса — 53%.

- Сложность интеграции с существующими процессами ИТ / ИБ — 29%.

- Сопротивление ML-инженеров — 24%.

- Высокая стоимость и отсутствие бюджета — 12%.

- Другое — 18%.

Рисунок 4. Что мешает внедрению MLSecOps в вашей организации? (мультивыбор)

Улучшат ли ситуацию регуляторные требования?

Игорь Бирюков:

«Первой будет финансовая отрасль. ЦБ уже пишет требования к моделям. Разрабатывается ГОСТ по ИИ».

Антон Башарин:

«Без нормативных требований было бы тяжело, они необходимы. Это как некий чек-лист, по которому можно понять, что продукт удовлетворяет заказчика».

Светлана Газизова:

«Нам не хватает глоссария. Не хватает базовой терминологии, чем мы оперируем в рамках выстраивания процесса безопасной разработки, тестирования, проверки. Нужно начать с определения терминов».

Александр Лысенко:

«Раньше регуляторике предшествовали коммерческие фреймворки, но сейчас мы в той стадии, когда их ещё нет. Выпущенные сейчас не готовы для работы, они сводятся к перечню угроз. В первую очередь ждём коммерческие фреймворки, которые дадут глоссарий хотя бы внутри индустрии. Хотелось бы, чтобы регуляторы учитывали это в работе при составлении регламентов. Опираться нужно на то, что пришло из коммерческой индустрии».

Антон Конопак:

«Регуляторика заставляет всех двигаться вперёд, но первые шаги — это всегда боль, так как документы имеют весьма абстрактные формулировки».

Что может помочь в освоении MLSecOps?

Денис Турдаков:

«MITRE ATLAS, OWASP, документы NIST. Из российских — документы “Сбера”, “Яндекса”. Начинают появляться курсы про доверенный ИИ».

Антон Конопак:

«Доклад Дмитрия Полторака на CyberCamp, который недавно опубликовали. Там вся база про MLSecOps».

Александр Лысенко:

«Guardrails Hub (посмотреть что уже есть и можно использовать), ознакомиться с инструментами Adversarial Robustness Toolbox (ART), фреймворки по XAI (попробовать интерпретировать результаты XAI и встраивать их в обучение). Можно попробовать на тестовом стенде сделать ETL (Extract, Transform, Load) и посмотреть, где может быть утечка данных».

Светлана Газизова:

«Онлайн-практикумы, учебники по машинному обучению. Невозможно заниматься безопасностью ИИ без опыта работы с ним. Сейчас есть много опенсорсных лабораторий, где можно попробовать промпт-инъекцию».

Антон Башарин:

«Берите любую угрозу, изучайте как её эксплуатировать, как можно применить, на что влияет, попробовать в лаборатории, потом на большой модели».

Игорь Бирюков:

«Стоит почитать OWASP Top 10 для понимания угроз. После использования всего перечисленного можно приходить к интегратору или вендору за консультацией».

Финальный опрос показал, как изменилось мнение зрителей о MLSecOps после эфира: убедились, что это необходимый инструмент — 37%, пока сомневаются в эффективности — 36%, планируют начать «пилот» / тестирование — 9%, считают интересным, но избыточным для себя — 9%.

Рисунок 5. Как изменилось ваше мнение о MLSecOps после эфира?

Выводы

MLSecOps — это не временный тренд, а закономерный и необходимый этап эволюции безопасной разработки в эпоху ИИ. Несмотря на то, что это направление только формируется, уже очевидно: защита ML-моделей требует принципиально нового подхода, где безопасность данных и математической составляющей модели становится критически важной. Главным вызовом сегодня является острая нехватка специалистов, способных работать на стыке машинного обучения и безопасности, а также отсутствие зрелых стандартов и инструментов.

Проблемы, которые предстоит решить в этом новом направлении, носят как технический, так и организационный характер. Ключевой сложностью остаётся «цифровой разрыв» между специалистами по машинному обучению и экспертами по безопасности: первым часто не хватает глубинного понимания моделей угроз, а вторым — математической базы для анализа архитектуры и поведения моделей. Отсутствие единого глоссария и зрелых регуляторных требований пока оставляет компании один на один с необходимостью самостоятельно выстраивать процессы и оценивать риски.

Кроме того, сама динамичная природа ИИ, где модель постоянно эволюционирует и взаимодействует с данными, требует создания принципиально новых инструментов для мониторинга, которые могли бы в реальном времени обнаруживать такие угрозы, как дрейф данных или сложные состязательные атаки, остающиеся невидимыми для классических систем защиты.

Тем не менее, стартовать можно уже сейчас, опираясь на адаптированные практики классической ИБ, существующие фреймворки вроде MITRE ATLAS и OWASP, а также наращивая собственную экспертизу через эксперименты в лабораторных условиях. Успех внедрения MLSecOps зависит от понимания, что безопасность должна быть вплетена в жизненный цикл модели с самого начала, а не добавляться постфактум. Несмотря на сомнения части аудитории, итог дискуссии очевиден: игнорирование этого направления создаёт неприемлемые риски для бизнеса, которые будут только расти вместе с распространением ИИ-технологий.

Телепроект AM Live еженедельно приглашает экспертов отрасли в студию, чтобы обсудить актуальные темы российского рынка ИБ и ИТ. Будьте в курсе трендов и важных событий. Для этого подпишитесь на наш YouTube-канал. До новых встреч!