Исследователи в области кибербезопасности выяснили, что восемь из десяти веб-сайтов, на которых присутствует строка для поиска, сливают поисковые запросы посетителей крупным рекламодателям вроде Google.

Таким образом, интересы пользователей отправляются третьей стороне, в данном случае — крупным рекламным сетям, которые впоследствии могут использовать эту информацию для отображения релевантных объявлений или даже для отслеживания действий пользователя в Сети.

К сожалению, в этом случае рядовому веб-сёрферу достаточно сложно понять, насколько его интересы «разошлись» по разным корпорациям. Более того, обратить этот процесс вспять тоже не получится.

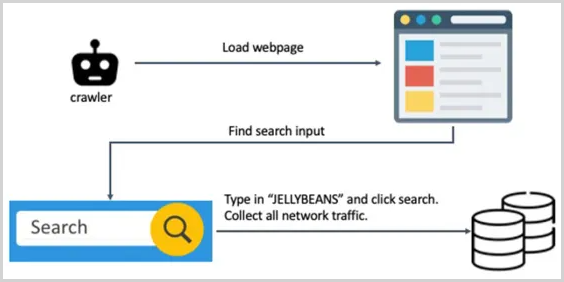

Результатами своего исследования поделились специалисты Norton Labs. Они запустили веб-краулер, способный обходить различные проверки на ботов. Задача краулера была проста — просканировать активность на миллионе самых топовых сайтов.

Бот Norton Labs находил поисковую строку и вводил туда текст “JELLYBEANS“, после чего собирал весь сетевой трафик.

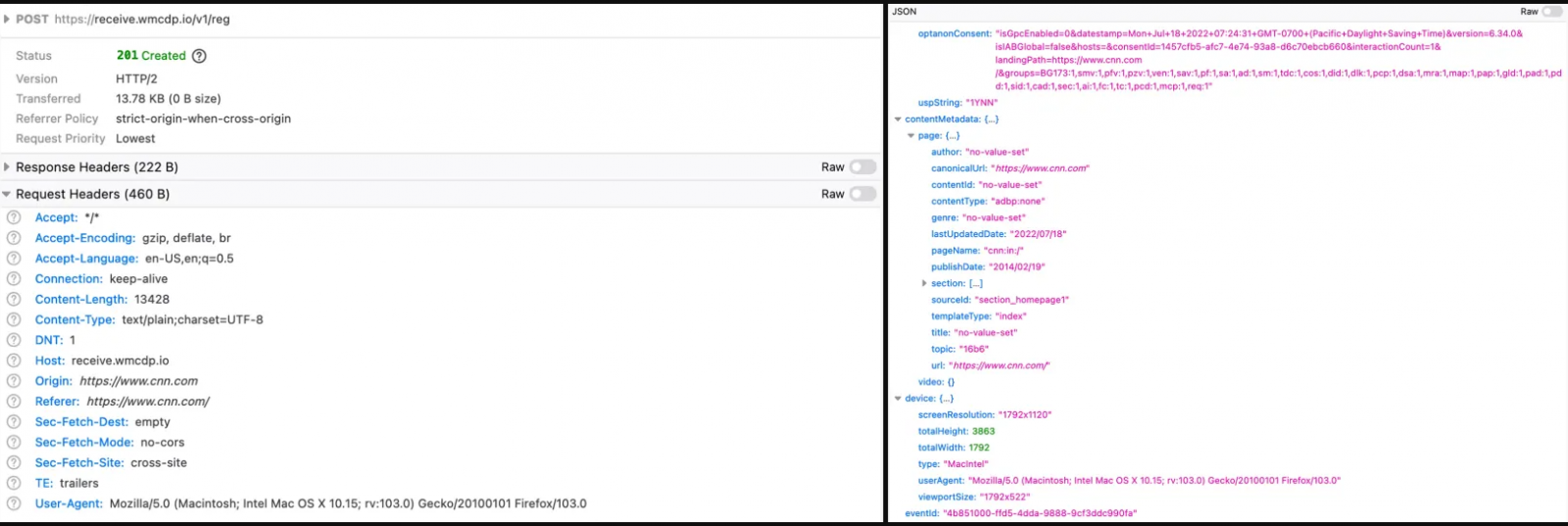

Исследователи пристально отслеживали HTTP-запрос, чтобы выяснить, не появится ли “JELLYBEANS“ в запросах каких-либо сторонних «партнёров». В итоге специалисты выяснили, что запрос передавался в 81,3% случаев.

Интересно, что подобные запросы включали URL, HTTP-заголовок и другие детали. При этом принимающий сервер получал не только запрос, но и цифровой отпечаток браузера пользователя.

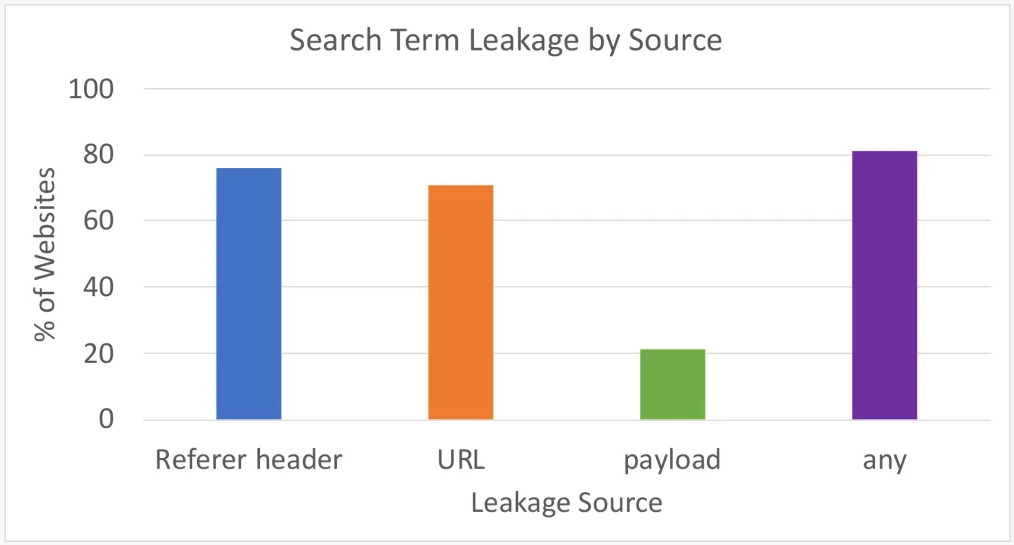

В общей сложности 81,3% из миллиона проанализированных сайтов сливали пользовательские запросы как минимум одним из способов: через заголовок (75,8%), через URL (71%) или с помощью отпечатка (21,2%).