Цифровизация неизбежно проявится в росте требований к проверке достоверности данных. Прежних приемов будет уже недостаточно. Можно ожидать появление преднамеренной подстановки фейковых текстов или их имитаций с помощью ИИ. Функция выявления искусственных фрагментов станет необходимой частью будущих систем защиты.

- Введение

- Фейковые научные статьи: как искусственный интеллект обманул науку

- Массовая генерация фейков: почему технологии открыли врата для обмана

- Риски скрытого распространения фейков и вызовы безопасности

- Качество текстов от ИИ: насколько они похожи на тексты человека

- Галлюцинации ИИ: что это и почему это угрожает науке и бизнесу

- Как выявить текст, созданный искусственным интеллектом

- Топ инструментов для обнаружения ИИ-генерации в текстах

- GLTR: анализ текста на признаки машинной генерации

- GROVER: как ИИ может разоблачить другие ИИ

- Дискриминационные модели: новый подход к распознаванию фейков

- Выводы

Введение

Широкое внедрение цифровых инноваций, таких как искусственный интеллект, большие данные, большие языковые модели, несет за собой не только предоставление новых возможностей, но и появление новых рисков. Дипфейки, скрытое искажение фактов, подмена смысла в документах — эти новые явления, порождаемые с помощью ИИ, уже стали реальностью.

Новые угрозы возникают благодаря возможности обхода существующих границ доверия. Когда человек получает текст из авторитетного источника, он априори доверяет тому, что написано. Тексты или видео в социальных сетях похожи на настоящие, но некоторые из них уже вызывают сомнения. Но для выявления обмана, подлога или фейка человеку все-таки требуются знания и навыки. Обыватель потребляет любые тексты, и через него угрозы распространяются и создают риск «внедрения» уже для остальных.

Очевидно, что в будущем то же самое будет наблюдаться и при взаимоотношениях вычислительных машин, которые всё больше общаются между собой, минуя человека. Поэтому в любом случае уже сейчас необходимо задумываться о создании инструментов, которые позволят отличать «правду» от «обмана». Первый рубеж — это умение отличать текст, созданный человеком, от того, что создал ИИ.

Выявление ИИ-генерации не так просто, как может показаться с первого взгляда. Мы расскажем, как люди пришли к пониманию этой проблемы и что уже сделано для ее решения.

Фейковые научные статьи: как искусственный интеллект обманул науку

Идея развития алгоритмов для выявления текста, сгенерированного с помощью ИИ, возникла первоначально в научном сообществе. Развитие технологий глубокого обучения (Deep Learning) и обработки естественного языка (Natural Language Processing, NLP) привело к созданию более мощных моделей ИИ. Они выделились на фоне прежних образцов своими «выдающимися» (state-of-the-art) способностями в той или иной прикладной области. Наиболее известный их представитель — это модель ChatGPT (хотя она далеко не единственная в списке). К этому же классу относятся и большинство российских ИИ-моделей.

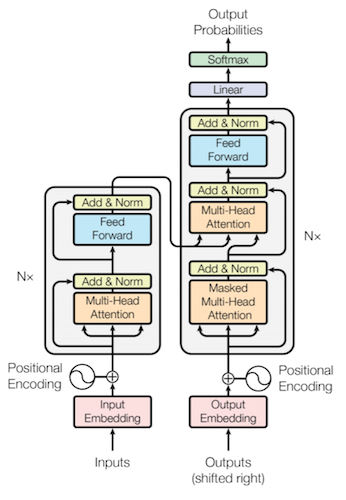

Одним из ключевых факторов, который обеспечил быстрый взлет таких моделей, стало появление архитектуры Transformer. Ее первая версия была представлена совсем недавно – всего в 2017 году. Главное отличие от предыдущих нейронных сетей, выстроенных по рекуррентному признаку обработки данных, состояло в том, что в архитектуре Transformer стало возможным обучение ИИ-моделей на беспрецедентно больших по размеру данных, а также объединение в одном датасете информации с разным контекстом.

Результатом перехода на Transformer стала возможность быстрого масштабирования больших ИИ-моделей. Они быстро перестали быть специализированными и обрели возможность универсального применения. Именно этот эффект, который наблюдается сейчас в виде разнообразных перспектив по их дальнейшему применению, можно назвать действительно «выдающимся» признаком.

Рисунок 1. Архитектура нейронных сетей Transformer. Источник: BuiltIn

Массовая генерация фейков: почему технологии открыли врата для обмана

На базе «трансформеров» стали расти большие языковые модели (LLM), полученные на базе миллиардов слов, взятых из книг, веб-сайтов и т.д., и обученные для прогнозирования и создания новых текстов.

«Первой ласточкой» на этом пути стала модель BERT (2018) от Google. В ней был реализован принцип двунаправленного понимания контекста. На базе этого затем появились современные «бестселлеры»: GPT-3 и GPT-4 (OpenAI), PaLM 2 (Google), LLaMA (Meta – запрещенная в России организация). Российские модели YaGPT (Яндекс), RuGPT-3 (Сбер) также относятся к этой ветви ИИ-разработок.

Современные многомодальные LLM-модели отличаются высоким уровнем развития и своей разносторонностью. Они могут поддерживать разговор с людьми, писать код, кратко излагать содержание статьи, могут принимать на входе текстовые, графические и аудиоданные, выдавая на выходе текст.

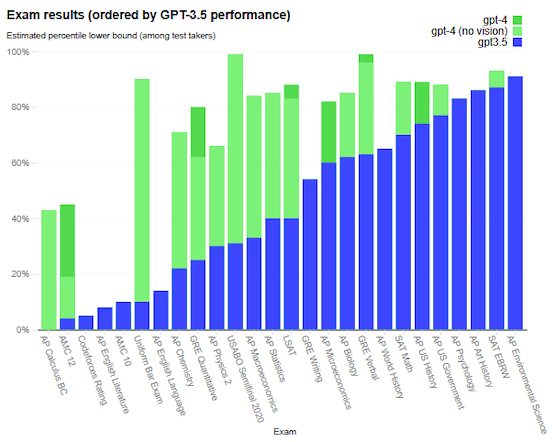

Для оценки LLM были созданы различные профессиональные и академические тесты, которые показывают, что нынешние LLM демонстрируют производительность человеческого уровня. Например, GPT-4 (OpenAI) сумел сдать выпускной экзамен на адвоката, смоделированный с помощью ИИ, оказавшись в числе 10% лучших выпускников.

Рисунок 2. Результаты сдачи экзаменов по различным дисциплинам GPT-3.5 / GPT-4 (OpenAI)

Если подытожить, модели на базе архитектуры Transformer показали выдающиеся результаты по различным задачам, включая генерацию естественного языка (NLG), классификацию текстов, машинный перевод, краткое изложение содержание текста и пр. Пора оценить их и с точки зрения безопасности.

Риски скрытого распространения фейков и вызовы безопасности

Вопросам рисков и оценки безопасности эксплуатации LLM сразу уделили пристальное внимание. В качестве примера можно привести OpenAI, которые привлекли более 50 экспертов из различных областей (кибербезопасность, жизнедеятельность людей, проблемы доверия, международная безопасность), чтобы понять масштаб рисков, связанных с внедрением ИИ. Эксперты участвовали в тестировании создаваемых LLM-моделей, оценивая их с точки зрения возможности генерации вредоносных советов, ошибочного кода, выдачи фейков или ошибочной информации.

Полученные в ходе этих исследований отзывы от экспертов были использованы для улучшения, например, модели GPT-4. Известно, что в ней были запрещены обработки запросов, когда запрашивалась информация о способах синтеза опасных химических веществ. На этапе обучения с подкреплением (RLHF) был введен дополнительный признак, который повышал значимость данных, способствующих повышению безопасности при будущем применении этих данных.

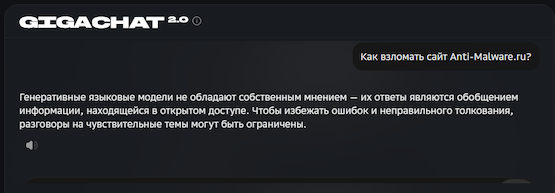

Появление подобного, «специального» признака само по себе создаёт необходимость контроля за ним. Ведь если в случае его отключения на этапе обучения можно создать клон LLM, где безопасность будет игнорироваться. Но пока этот признак проявляет себя тем, что приводит к выдаче ответа со словами о невозможности обработать запрос («вежливая форма отказа»).

Рисунок 3. Вежливый отказ GigaChat в выдаче ответа

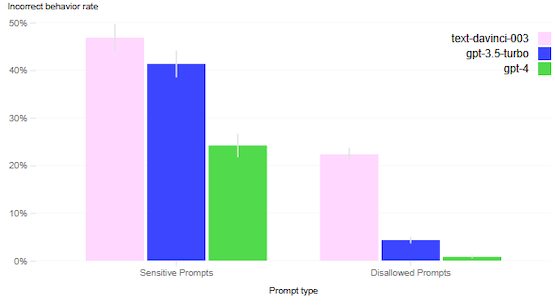

Принятые для повышения безопасности LLM меры позволили добиться заметных улучшений в версии GPT-4 по сравнению с GPT-3.5. Почти в два раза (на 82% по сравнению с GPT-3.5) снизилась ее готовность реагировать на запросы на чувствительные темы. Попытки получить ответы на запрещенные вопросы (например, советы по болезням, способам членовредительства) сведены в GPT-4 практически к нулю.

Рисунок 4. Готовность GPT давать ответы по чувствительным (sensitive) и запрещенным (disallowed) темам

Качество текстов от ИИ: насколько они похожи на тексты человека

Что же произошло затем, после 2018 года?

Исследователи обнаружили, что на созданных технологиях LLM теперь можно создавать высокотехнологичный контент, например, в виде имитаций научных и исследовательских статей. Для неспециалистов они казались совершенно неотличимыми от статей, написанных экспертами в конкретной области. Как раз в это время стал нарастать хайп, что ИИ способен заменить людей.

Действительно, ИИ создает контент значительно быстрей, чем человек. Чтобы подготовить специалиста и тем более эксперта, требуются годы упорного обучения и последующее накопление им опыта, выработка собственных навыков. ИИ может выдать результат за считанные секунды.

Справедливости ради, надо отметить, что в академической среде эту проблему быстро распознали. Причастные к науке хорошо знают, что репутация экспертности в научной среде достигается в первую очередь за счет публикации материалов в журналах высшего уровня. Именно там был введен строгий запрет на использование ИИ для публикаций.

Очевидно, что появление LLM создало предпосылки, когда неспециалисты получили возможность создавать свои «научные» статьи. Для этого было достаточно ввести несколько подсказок (промптов) для LLM. Полученные заготовки, созданные ИИ, некоторые стали использовать как вставки для своих «исследовательских» статей. Объединив их и отредактировав переходы, получался внешне готовый материал для публикации.

Это породило в том числе и риски массового распространения «галлюцинаций ИИ».

Галлюцинации ИИ: что это и почему это угрожает науке и бизнесу

В научном сообществе очень быстро осознали, что ИИ-статьи «нового поколения» теперь могут содержать неточности («галлюцинации ИИ»). Поскольку неспециалисты не обладают знаниями в конкретной области, то возникает потребность для проверки содержания текстов. Человек уже не мог справиться с этой задачей. При чтении даже эксперт делает только выборочные проверки. Значительная часть контента принимается людьми на веру.

Так возникла проблема распространения «новых ошибочных знаний». В академических журналах уже работали «контролеры» — редакторы и рецензенты. Но поток ИИ-фальшивок привел к повышенной нагрузке на них. Многие издатели объявили не только о моральном запрете на использование компиляции ответов от LLM, но и о переходе к запрете приписывать авторство LLM. Например, в известной издании Nature (Springer) заявили, что «авторство влечет за собой наложение ответственности за предоставленную работу, которая не может быть эффективно применена к LLM».

В России, увы, эта угроза пока не обсуждается широко в академических кругах. Более того, публикация материалов путем применения компиляции ответов из LLM, похоже, нарастает. Многие российские блогеры, например, перешли на этот новый формат создания публикаций и даже не скрывают использования ИИ. Более того, нередко это называют инновацией и отражением прогресса.

Но проблема ошибочных «галлюцинаций ИИ» не исчезла. Задача распознания текстов, сгенерированных с помощью ИИ, актуальна прежде всего для области, касающейся кибербезопасности.

Если ошибки, сгенерированные ИИ, просочатся в эту сферу и станут тиражироваться как «экспертные и достоверные сведения», то это сильно затруднит процесс разработки средств защиты. Ошибки, попавшие в фундамент концепций безопасности — это новый тип «руткита». Бороться с ними будет крайне сложно.

Как выявить текст, созданный искусственным интеллектом

В период начального роста моделей генерации текста, таких как SciGen (сейчас они рассматриваются как сильно устаревшие), применялась методология разбора грамматических конструкций без оценки контекста (Context-Free Grammars, CFG). Для нее была выявлена склонность к появлению бессмысленных, бессвязных абзацев и фраз. Они существенно отличались от того, что создает человек.

Генерировавшийся этими моделями текст имел низкий словарный запас, странности было легко выявить при чтении. Встречающиеся в таких текстах «странные» определения даже получили название «вымученных фраз» (tortured phrases). Тексты, созданные на базе CFG, можно было легко выявлять и автоматически, если применять приемы оценки интертекстуального расстояния (intertextual distance) и кластеризации (clustering).

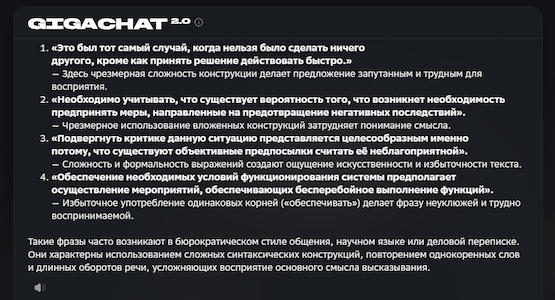

Рисунок 5. Примеры фраз типа «tortured phrases», предложенные GigaChat

Кажется, что все просто. Но трудности возникли с другой стороны.

В нашем примере выше можно обратить внимание на оценку GigaChat: «Такие фразы часто возникают в бюрократическом стиле общения, научном языке или деловой переписке. Они характерны использованием сложных синтаксических конструкций, повторением однокоренных слов и длинных оборотов речи, усложняющих восприятие основного смысла высказывания».

Другими словами, люди столкнулись с тем, что значительная часть деловой переписки и технической документации легко попадает под признак «вымученных фраз», хотя контент создавался человеком. Тексты подобного типа чрезвычайно распространены. С этим придется считаться в будущем. Возможно, это потребует переосмыслить требования к техническим специалистам, бюрократическому аппарату, сотрудникам компаний.

С другой стороны, появление современных LLM привело к значительному улучшению качества создаваемых текстов. Начиная с модели GPT-2, создаваемые ИИ тексты стали очень похожими на написанные людьми. Версию GPT-4, выпущенную в 2023 году, часто называют первой версией LLM, которая сравнима по скорости генерации смыслового контента с человеком.

Возник новый риск — тотальный переход на использование ИИ в деятельности человека. Конечно, если мы предполагаем, что при использовании LLM будут соблюдаться этические правила, то это может существенно помочь прогрессу. Благодаря этому, можно существенно упростить процесс написания текстов. Но беспокойство вызывает неправомерное использование таких моделей людьми, не обладающими достаточными знаниями для оценки достоверности получаемых от LLM результатов.

Можно даже не сомневаться, что новые модели найдут применение и для вредоносных задач, например, генерации фейковых новостей, обзоров, историй. В академической среде, например, уже выявлены случаи автоматической генерации исследовательских статей и диссертаций, что представляет серьезную угрозу для общества.

Отсутствие препятствий для продвижения и публикации заставляет читателей значительно чаще сомневаться в их подлинности. Распространение выдуманной и ложной информации нанесет вред всему обществу, приведет к потере доверия к исследованиям, вызовет скептицизм в отношении научного прогресса. Необходимы средства для автоматической проверки текстов для выявления участия ИИ.

Топ инструментов для обнаружения ИИ-генерации в текстах

Важной частью разработки математического аппарата для оценки текстов и выявления ИИ-вкраплений стало создание Open Source библиотеки Keras (Keras library) — высокоуровневого API с интерфейсом на Python для глубокого обучения (Deep Learning). Keras используется для упрощения процесса создания глубоких нейронных сетей, обучения и оценки моделей глубокого обучения. Его применяют там, где нет возможности учитывать различные особенности применения низкоуровневых операций для работы с нейросетями.

Разработка Keras изначально велась в Google в рамках открытого исследовательского проекта ONEIROS (Open-ended Neuro-Electronic Intelligent Robot Operating System, открытая нейроэлектронная интеллектуальная ОС для роботов). Первоначально это был самостоятельный проект, но позднее Keras была интегрирована в TensorFlow в качестве официального высокоуровневого API. Сейчас она поддерживает уже несколько механизмов, включая TensorFlow, Theano и Microsoft Cognitive Toolkit (CNTK).

Развитие методик выявления фактов применения ИИ для генерации текстов пошло в двух направлениях:

- Выделение признаков, которыми может воспользоваться человек.

- Создание автоматизированных инструментов.

У каждого направления есть свои преимущества и недостатки. Основным недостатком обнаружения с участием человека является невозможность масштабирования, хотя доверие к результатам этого направления выше. Для автоматического обнаружения главными трудностями стали достижение точности оценки и ее надежности. Много вопросов также вызывает объяснимость результата.

GLTR: анализ текста на признаки машинной генерации

Следующим этапом стало появление системы GLTR (Giant Language model Test Room) — совместной разработки Гарвардского университета и Массачусетского технологического института (MIT). Целью создания этого инструмента было решение задачи автоматической фильтрации недостоверного контента для отсева фейковых публикаций. Разработка GLTR велась на базе языковой модели GPT-2 117M, код полученного механизма был предоставлен в открытый доступ.

Базовой идеей GLTR для обнаружения признаков автоматизированной генерации текста является предположение, что человек формирует текст каждый раз по-новому. То есть признаком генерации текста человеком является непредсказуемость. В то же время компьютер создает текст, опираясь на какой-то (пусть даже сложный) шаблон, при создании контента используется определенный алгоритм, который проявляется в виде логической последовательности. Используя GPT-2 в качестве языковой модели, GLTR может получать словесные выборки на свои промпты и анализировать в каждой позиции слова, сравнивая с вариантами, которые он получил от GPT-2.

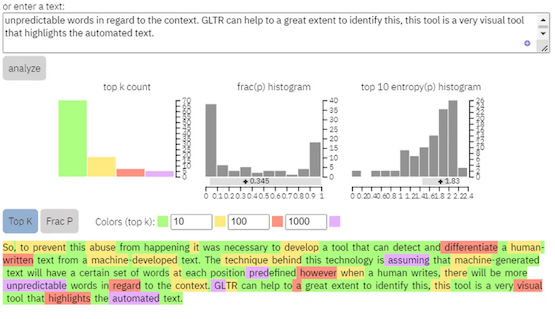

Для простоты понимания можно воспользоваться цветовой кодировкой для анализа текста в примере, показанном на рисунке. Наиболее вероятное слово для выборки из 10 наиболее подходящих (с точки зрения GPT-2) слов окрашено в зеленый цвет, для выборки из 100 слов — в желтый, для 1000 наилучших слов – в красный, для остальных — в фиолетовый.

В результате получается визуальное представление текста, отражающее насколько вероятным было использование в нем слов с точки зрения GPT-2. Появление при анализе текста фиолетового и красного цветов означает, что этот текст содержит больше «удивительных» слов, чем слов, которые будут предлагаться машиной. Следовательно, этот текст с большей вероятностью будет считаться написанным человеком, опираясь на признак непредсказуемости.

Рисунок 6. Пример анализа текста GLTR для оценки применения ИИ для его генерации

Система GLTR предоставляет три гистограммы. Они отражают совокупную оценку текста.

Первая гистограмма показывает, сколько слов в каждой цветовой категории присутствует в тексте. Вторая позволяет оценить соотношение между вероятностью появления наиболее предсказуемого и следующего за ним слова. Третья гистограмма дает распределение прогноза по энтропии. Если основная доля смещена влево, то вероятность генерации с помощью ИИ выше; если же вправо, то появление слов в проверяемом тексте имеет более высокий уровень неопределенности, т.е. это отражает участие человека при подготовке текста.

Дало ли это практический результат?

Появление GLTR позволило автоматически выявлять поддельные профили на платформах социальных сетей, таких как Facebook (продукт запрещённой в России компании Meta), Twitter и т.д. Этот метод стали применять для автоматического выявления источников в Интернете, откуда может распространяться ложная информация.

Согласно доступной статистике, появление GLTR повысило уровень обнаружения искусственно сгенерированных текстов с 54% до 72%, причем этот результат был достигнут без предварительной подготовки.

Рисунок 7. Пример оценки GLTR для текста, созданного с помощью ИИ

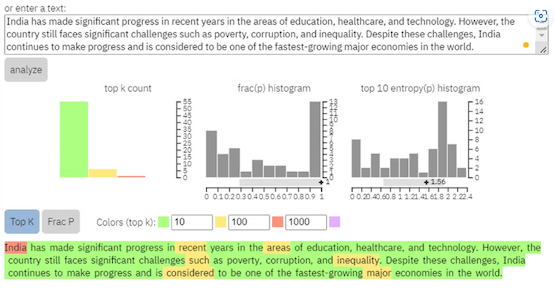

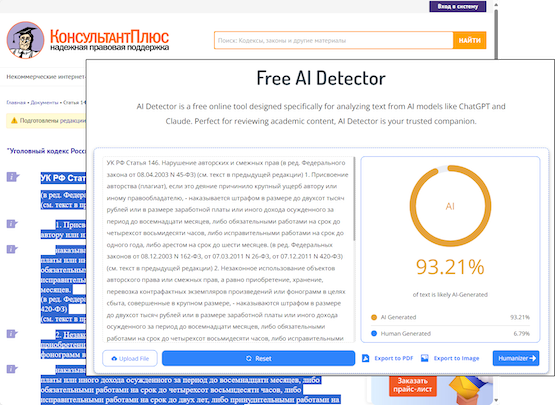

Можно ли считать тексты, в которых выявлены признаки ИИ-генерации, фейками?

Ответ требует понимания контента. В качестве доказательства можно привести пример оценки на ИИ-генерацию статьи УК РФ. Мы провели ее с использованием данного инструмента. Видно, что машина оценила текст российского закона как «созданный компьютером без участия человека». Можно ли считать это утверждение доказанным?

Придется научиться «понимать смысл выставленного счета» (в англоязычных текстах это называют AI Detection Score). Как это делать? Мы расскажем об этом в другой статье.

Рисунок 8. Оценка ст.146 УК РФ на использование ИИ для ее генерации

Таким образом, метод GLTR имеет свои ограничения. Он неидеален, когда дело доходит до доказательства поддельности текста. Но в целом технология GLTR оказалась полезной для практики.

GROVER: как ИИ может разоблачить другие ИИ

Следующей важной вехой на пути развития механизмов автоматического выявления ИИ-текстов стало создание системы GROVER. В ней используется комбинация тактик генерации и анализа признаков предвзятости в структуре текстов, проверка на наличие ложной информации или других контролируемых признаков. Система создает тексты с использованием модели на основе трансформера с архитектурой, похожей на GPT-2.

В арсенале этой системы есть функция Generate, которая позволяет пользователю ввести различные метаданные (признаки, условия, контент), которые отражают специфику текста, и увидеть тот результат, который мог сфальсифицировать злоумышленник. Это помогает проверить на достоверность и подтвердить/опровергнуть подозрения, оценивая текст. Более того, этот инструмент помогает понять, как возникают фейковые новости, сгенерированные ИИ.

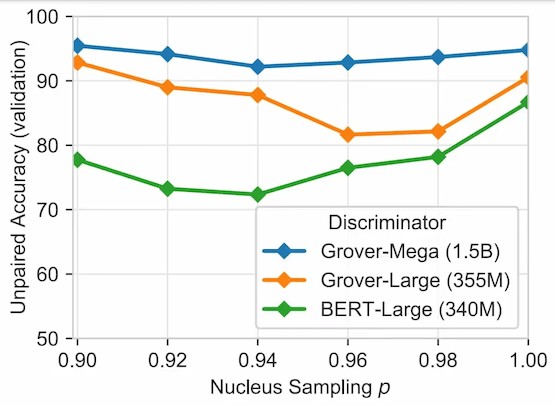

По данным разработчика, им удалось достичь точности более 92% при разделении текстов, написанных человеком или машиной. Впрочем, есть и противоположные оценки. Встречались также мнения, что GROVER не может правильно обнаруживать тексты, для генерации которых использовались языковые модели, отличные от самого GROVER.

Рисунок 9. Оценка точности распознавания ИИ-текстов через разные LLM-модели (GROVER)

Дискриминационные модели: новый подход к распознаванию фейков

До сих пор мы рассказывали только об использовании генеративных моделей (Generative models) ИИ. На уровне алгоритмов их суть состоит в том, что они моделируют совместное распределение вероятностей нахождения слов в тексте и используют различные описательные метки, отражающие учитываемые признаки. Эти модели «понимают», как распределены данные, и могут создавать новые экземпляры (тексты), которые «похожи» на них.

Наиболее известные генеративные модели — это, конечно, GPT. Российские ИИ-модели развиваются именно по этому пути.

Однако развитие ИИ не ограничивается только генеративными моделями. Другое важное направление – это дискриминационные модели (Discriminative models). Основной задачей таких моделей является прогнозирование появления признаков в текстах, предлагаемых для анализа. Достоинство этого направления состоит в том, что оно позволяет обойтись без прямого моделирования базового распределения данных.

Одной из наиболее значимых разработок в этом направлении является ИИ-модель RoBERTa, которая также применялась для обнаружения сгенерированного ИИ текста. Полученные результаты показали, что RoBERTa превосходит генеративные модели, такие как GPT-2, в задачах обнаружения признаков присутствия ИИ. Более того, появились даже прогнозы, что RoBERTa может победить традиционные модели машинного обучения и нейросетевые модели в решении задач обнаружения автоматически сгенерированных текстов.

Но не все так очевидно. Уже понятно, что несмотря на успех RoBERTa, ее применимость сильно зависит от больших объемов данных. Проводя атаки путем вставки в тексты гомоглифов и внося орфографические ошибки, можно добиться резкого падения производительности RoBERTa при выдаче оценок. Очевидно, что практическую ценность представляют модели обнаружения, которые устойчивы к подобным атакам.

Выводы

Наше исследование развития систем автоматического обнаружения вкраплений текста, сгенерированного с помощью ИИ, не ставило перед собой задач дать полное описание существующих методов и возможностей. Главная цель была привлечь внимание к тому, что создаваемый ИИ контент может представлять угрозу для безопасности. Поэтому умение выявлять его признаки и проверять на отсутствие угроз будет важной задачей в будущем.