Гонка развития искусственного интеллекта нарастает. Внедрение новых систем обещает большие изменения в жизни общества и экономический рост. Но вместе с этим могут возникнуть и новые угрозы, которые многие даже не рассматривают всерьёз.

- Введение

- «Риски от ИИ сопоставимы с угрозой применения ядерного оружия и пандемией»

- Страхи рынка в отношении развития ИИ

- Технологический скачок в разработке ИИ

- Перелом в разработке ИИ-систем

- Риски от внедрения ИИ

- Риски при подготовке ИИ-контента

- Выводы

Введение

В самом термине «искусственный интеллект» формально заложено, что компьютерный разум развивается искусственным путём, т. е. этот процесс управляем. Объявлены также цели его развития. Но предложенные разработки вызвали разные мнения со стороны рынка, в том числе об отсутствии должного управления.

Действительно, после долгого предварительного экспериментирования над большими лингвистическими моделями — фундаментами любой системы ИИ — на рынок «внезапно» обрушилась волна инноваций. Новые решения уже принесли хороший заработок тем, кто успел оказаться впереди других. Это ещё больше стимулирует развитие ИИ.

После периода неопределённости назначения ИИ сегодня сформировалась общая позиция со стороны разработчиков: будущее за созданием больших мультимодальных генеративных ИИ-сетей, которые станут создавать искусственные тексты, графику, код, объекты и многое другое.

Сегодня создаются новые ИИ-направления во всех отраслях экономики. Государства оказывают всестороннюю поддержку новым стартапам, в ИИ пришёл большой бизнес. Но так ли безопасно то, что создаётся?

«Риски от ИИ сопоставимы с угрозой применения ядерного оружия и пандемией»

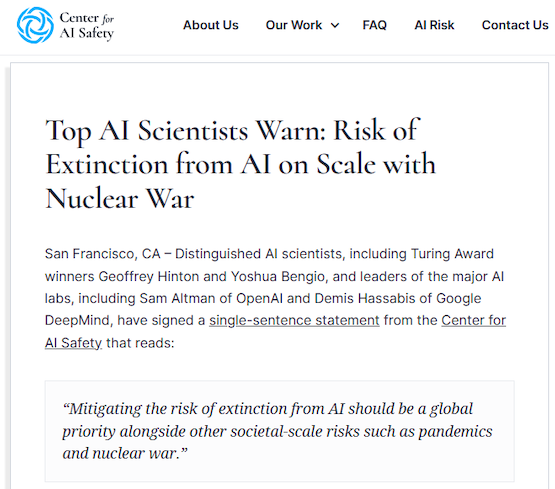

30 мая Сэм Альтман и Демис Хассабис, а также ряд иных известных учёных поставили подписи под обращением «Центра по безопасности ИИ» (Center for AI Safety). Оно состоит всего из одного предложения: «Риск вымирания по вине ИИ должен регулироваться в приоритетном для всего мира порядке наряду с другими всеобщими рисками, такими как пандемия или ядерная война».

Рисунок 1. Пресс-релиз о решении Альтмана и Хассабиса (Center for AI Safety)

Чтобы понять незаурядность события, следует уточнить, кто именно поставил свои подписи. Сэм Альтман является генеральным директором и сооснователем OpenAI, а Демис Хассабис — глава и сооснователь DeepMind. Это те самые компании, которые считаются ведущими разработчиками в области ИИ. OpenAI известна прежде всего созданием большой языковой модели (LLM) GPT, на основе которой работает получивший огромную популярность чат-бот ChatGPT. Компания DeepMind входит в состав корпорации Google и занимается разработками универсальных алгоритмов для обучения ИИ-систем.

При этом «Центр по безопасности ИИ» объединяет самых разных людей, проводящих (в том числе на этой площадке) дискуссии самого разного толка: кто-то провозглашает ИИ высшей целью развития государства, а кто-то называет его создание «гонкой вооружений нового типа» и «новым проявлением расизма и фашизма».

Рисунок 2. Илон Маск и Сэм Альтман на саммите Vanity Fair New Establishment Summit в 2015 году (Getty Images)

Страхи рынка в отношении развития ИИ

Отрицать появление ИИ и нарастание его популярности, поддержки со стороны государств и бизнеса сегодня уже невозможно. Более того, это реальность, с которой уже сталкиваются рядовые граждане.

Осознавая стремительный рост ИИ и его проникновение во все сферы жизни, издание Reuters провело в мае опрос среди своих американских подписчиков. Его целью было определить отношение к ИИ со стороны общества.

Согласно результатам, 61 % респондентов выбрали ответ «стремительный рост технологий ИИ может поставить под угрозу будущее человечества». Их оказалось в три раза больше, чем тех, кто «не наблюдает опасности со стороны ИИ» — такой ответ выбрали 22 % опрошенных. 17 % респондентов ответили, что «не уверены».

Добавим, что необходимость приоритетного развития ИИ признана российским государством как магистральное для экономики страны направление.

Технологический скачок в разработке ИИ

Чтобы не впасть в маркетинг, следует для начала понять, чем создание ИИ отличается от программирования. В чём состоит новизна подхода к тем компьютерным разработкам, которые называют искусственным интеллектом?

В основе обычной компьютерной программы лежат алгоритмы, по которым можно «понять», как работает система. Результаты работы ИИ, в свою очередь, представляют собой «чёрный ящик». Программный механизм искусственного интеллекта позволяет получить результат, который «машина» считает наиболее точно соответствующим поставленной задаче.

Если раньше разработчик мог алгоритмически управлять «точностью приближения» к поставленной им цели, то ИИ предоставляет результат качественно иной природы, зависящий от того, насколько точно был сформулирован запрос и насколько корректно были подобраны исходные данные, на которых обучалась модель. Конечно, в генерации этого результата тоже участвуют алгоритмы, но процесс его порождения непредсказуем, так что даже сам создатель не всегда может сказать, что в итоге выдаст ИИ из своего «чёрного ящика».

Соответственно, о проблемах с созданными механизмами ИИ первыми заговорили сами разработчики. Когда их просили объяснить причины, по которым получался тот или иной результат, им приходилось тратить много времени на то, чтобы восстановить последовательность «поиска» решения ИИ-системой. Понять логику обычных алгоритмических вычислений можно гораздо проще и быстрее.

Как следствие из этого возникло мнение, что в будущем порождаемые ИИ-системами ошибки будут также требовать значительно больше времени на их исправление. Более того, когда ИИ-системы широко распространятся, могут возникнуть ситуации потери управляемости. Разработчики перестанут по-настоящему понимать, почему система выдаёт именно такой, а не другой результат, а следовательно, не будут знать, что именно нужно изменить или исправить.

Перелом в разработке ИИ-систем

Описанная ситуация неопределённости возникла не так давно, в 2019 году. Но первый явный сигнал опасности прозвучал только годом позже. 11 июня 2020 г. компания OpenAI объявила о введении ограничений на доступ к прикладному программному интерфейсу (API) своей ИИ-системы GPT-3. Пользоваться им смогли только избранные разработчики из Reddit, Algolia, Quizlet, AI Dungeon и др.

OpenAI объяснила такое решение коммерческими причинами. Поскольку для запуска в работу таких больших языковых моделей требуется создать очень серьёзную ИТ-инфраструктуру, открытый API даёт преимущество крупному бизнесу. Закрывая доступ, OpenAI как бы обеспечивает равные шансы на создание инноваций для всех участников рынка. «Закрытый» API также был призван предотвратить злоупотребление ИИ.

Логика обеспечения безопасности при таком подходе прослеживается. Однако проблемы возникают с другой стороны: разработчик становится монополистом не только в развитии технологии ИИ, но и в определении того, что именно считать «злоупотреблениями».

Отметим, что хотя проект OpenAI развивается самостоятельно, по сути сейчас за ним стоит Microsoft. Она же развивает на базе GPT и собственный проект — адаптированную версию Azure OpenAI Service.

Алгоритмической частью ИИ занимается Google, которая развивает собственное ИИ-ядро для реализации поисковых функций и лучшего понимания контекста в нетекстовой информации (голос, видео). Это делается в рамках исследовательского и академического ИИ-проекта BERT (Bidirectional Encoder Representations from Transformers). Он имеет свои ответвления: проекты Microsoft MT-DNN (Multi-Task Deep Neural Network), Facebook RoBERTa (деятельность компании Meta (соцсети Facebook, Instagram) запрещена в России как экстремистская), SuperGLUE Benchmark.

В создавшейся ситуации России было оставлено право только на коммерческое использование ИИ-разработок. Очевидно, что это не могло удовлетворить российских участников ИИ-гонки.

«Сбер» сделал ответвление (форк) GPT 2.5 и стал развивать LLM-модель GPT 3 Sber собственными силами, принимая во внимание открытые источники по развитию GPT 3.0. В октябре 2020 года разработчики «Сбера» объявили о создании ruGPT-3 Large — русскоязычного аналога GPT-3. Для обучения они использовали набор текстов объёмом 600 ГБ, 90 % из которых были на русском языке. Сообщается, что в этот набор включили русскую и английскую «Википедию», корпус русской литературы, некоторые русскоязычные сайты, данные из GitHub и StackOverflow.

В июне 2022 года «Яндекс» выложил в открытый доступ исходный код собственной нейросети YaLM 100B, предназначенной для генерации и обработки текстов на русском и английском языках.

Риски от внедрения ИИ

Мы не будем перечислять преимущества, которые даёт внедрение ИИ. Разработки в этом направлении пользуются сейчас в России широкой государственной поддержкой. Создаётся впечатление, что внедрению ИИ будет сопутствовать только успех и возможны преграды лишь технического характера.

Но, похоже, не всё так гладко. Назовём преграды, которые могут встретиться на этом пути.

- Снижение качества информации. На создание нового контента с помощью ИИ требуется значительно меньше трудозатрат, чем при его подготовке вручную. Более того, ИИ позволяет получить контент практически бесплатно. Это мгновенно сделало его крайне популярным. Но на рынке ещё не создан защитный механизм, способный защищать от фейков, неточных трактовок, подтасовки фактов и пр.

Создаваемый с помощью ИИ контент выглядит привлекательным: он реалистичен, внешне содержателен, быстро порождается. Появляется возможность для быстрого и, главное, необременительного пока заработка. Возникает и риск демпинга, который ударит по «живым» авторам.

Распространению сомнительного ИИ-контента будет способствовать в значительной степени невысокая требовательность к достоверности и качеству контента со стороны массового рынка. Она и так постоянно снижалась в последние годы. - Нарушение авторских прав. Контент обладает имущественной ценностью. Продукты творческого труда охраняются законами об авторском праве и не подлежат свободному распространению. В то же время в ИИ-системах пока нет явного механизма, который бы гарантировал отсутствие нарушения авторских прав, хотя при формировании лингвистических моделей использовались материалы защищаемые авторским правом.

- Риски потери доверия к источникам информации. Генеративный ИИ порождает тексты, для формирования которых использовались различные источники. Но правильность передачи контекста определяется различными дополнительными факторами. Контент, который собран из разных фрагментов, даёт условно осреднённый результат по уровню качества данных, их достоверности.

Когда ИИ-система предоставляет недостоверный или фальшивый результат, у нас нет механизмов полноценного контроля, которые могли бы послужить фильтром. Экономия на затратах человеческого труда может обернуться потерей ценности ИИ-ресурса.

Первыми об этом заговорили сами разработчики, которым было предложено не самим писать программы, а получить сгенерированный с помощью ИИ код и только проверить его. Они столкнулись со многочисленными неявными ошибками и нестыковками в коде. Их выявление вылилось в огромные потери рабочего времени. Проверка порождала бестолковый труд по поиску скрытых или плохо видимых ошибок, которые обычно не встречаются у опытных разработчиков.

После этого появилось мнение, что широкое внедрение ИИ способно привести к дискредитации труда инженеров-программистов и самой программной инженерии. Более того, ожидается, что генерируемый с помощью ИИ код, может, и будет работать, но всегда «немного неправильно». При этом результаты не будут поддаваться проверке. - Риск массовой генерации псевдоинформации. Чтобы понять истоки этого риска, следует дать некоторые пояснения к тому, как работает языковая модель вроде ChatGPT и как удаётся создавать всегда разные ИИ-ответы.

При подборе слов для формирования ответов в ChatGPT подходящий вариант из полученной выборки подставляется не просто так, а с учётом поправки в сторону понижения уровня его релевантности. Это не только создаёт многообразие вариантов в ответах, но и создаёт «ощущение», будто результат был порождён живым человеком.

Этот принцип напоминает то, как в акустике создаётся эффект псевдостерео или псевдоквадро. Сначала он выглядит «очень натурально», но прислушавшись, многие теряют интерес. Они чувствуют «искусственность» звука на интуитивном уровне. Это не доставляет того удовольствия, которое даёт естественное разложение звука по нескольким каналам.

Если разработчики ИИ не придумают дополнительных признаков и не будут улучшать модели генерации, то существует высокая вероятность того, что интерес к «ИИ-творчеству» будет быстро утерян. Другое возможное последствие — появление больших объёмов псевдоинформации, которая просто «выдумана» искусственным интеллектом. Как бороться с этим, люди ещё не знают. - Подавление оригинальных целей. Чтобы понять этот риск, следует рассказать о случае, описанном в The Verge.

Пользователь захотел скачать браузер Chrome. Он попросил дать ему ссылку, отправив запрос через браузер Edge. Но поисковый чат-бот Bing выдал ему подборку статей о функциях поисковой системы Bing, хотя пользователь не просил об этом. Почему это произошло? ИИ не получил контекста запроса. Помимо ссылки ему требовалось дать ещё что-то. Поэтому он подставил в результат то, что оказалось в очереди по умолчанию. Неудивительно, что это были … маркетинговые материалы.

Интересны отзывы, которыми отреагировали на «инцидент» пользователи Reddit. Некоторые из них сразу заявили, что готовы отказаться от использования чат-бота Bing, потому что подобные «посторонние» ссылки отвлекают их от цели оригинального запроса. Робот предлагал им «яркий» контент, просмотр которого вызывал у пользователя эмоции, а это приводило к потере начальной задачи. Такой эффект известен в психологии и связан с переходом в т. н. «шоковое» состояние. Оказавшись в нём, человек склонен терять часть информации, которой обычно владеет свободно.

Именно поэтому, например, до появления мобильной связи людям старшего поколения и детям часто выдавали записки с номерами телефонов, по которым им следовало позвонить в непредвиденной ситуации. Как показывает практика, потерявшиеся люди иногда не могут вспомнить ни номера телефона, ни даже собственного имени, находясь под действием эмоций.

Эта реакция может показаться абсурдной, но поскольку ИИ-системы могут найти применение в самых разных отраслях и сферах жизни, этот риск также не стоит сбрасывать со счетов. - Риски изменений в эмоциях и поведении людей. Реалии таковы, что к текущему моменту произошёл явный массовый отказ от домашних библиотек и офлайн-чтения книг. Развитие ИИ может ускорить этот процесс. Появляется риск, что люди перестанут читать книги вообще, будут игнорировать этот канал получения контента.

Психологи говорят, что, как следствие, индивидуальные эмоциональные переживания людей могут стать сначала более приглушёнными, а затем прекратить существовать вовсе. Такие слова, как «веселье», «любовь» или «дружба», выйдут из употребления. Эти чувства больше не будут осознаваться и ощущаться.

Как ни странно, подтверждение этому уже имеется. Например, около 10 лет назад японская компания Yamaha выпустила специальные рояли, оборудованные телеком-системой, которая позволяла с очень высокой точностью повторять действия, производимые с аналогичным роялем, но установленным в другом месте. Предполагалось, что с помощью таких систем можно будет организовать дистанционное обучение профессиональных пианистов, привлекать педагогов мирового класса без необходимости их очного присутствия. Находясь в своей студии, например, в Москве, педагог мог слышать наяву, как играет его ученик, находящийся в Китае. Тот же слышал на своём рояле проигрыши, исполненные педагогом в Москве.

Результат внедрения оказался неожиданным: заочный контакт не обеспечивал качества, которое достигается при очном обучении. Технологиям оказалась не под силу передача эмоций на расстоянии. - Зацикливание знаний. Алгоритм генерации ответов выстраивается в ИИ-системах на базе ранее созданных текстов. Это порождает риск бесконечного повторения одной и той же информации. Такая система не может выйти на новый уровень, если он отсутствовал в ранее накопленных данных. Такое понятие, как «творческое озарение», пока недоступно для алгоритмов ИИ.

Риски при подготовке ИИ-контента

Опыт первых внедрений модели GPT показал, что обучение даже на легальных источниках информации не гарантирует отсутствия запрещённого контента. В частности, обученные модели стали выдавать контент с демонстрацией насилия, сексизма и расизма.

Поэтому начиная с версии GPT-3 весь подготовленный для обучения материал стал подвергаться цензуре. Как показало расследование, OpenAI делала это в партнёрстве с компанией Sama из Кении. Передача на аутсорсинг во многом объясняется экономией денежных средств: заработная плата «цензоров» составляла один-два доллара в час в зависимости от стажа и производительности.

Аналогичную низкооплачиваемую (1,5 долл./час) модерацию контента также проводила компания Meta (запрещена на территории РФ). Кенийская компания Sama предоставляла персонал для просмотра изображений и видео казней, изнасилований и жестокого обращения с детьми.

Таким образом, подготовка LLM-моделей связана с психологическим давлением, которому подвергаются модераторы обучающего контента для ИИ. Сейчас эта проблема решается за счёт привлечения работников из Африки. Это — серьёзные фундаментальные проблемы, иных решений для них пока нет, в том числе и у OpenAI.

Выводы

Развитие ИИ будет продолжаться, и уже сегодня в этой области достигнут огромный прогресс. Но появление программных систем нового типа может нести с собой и новые риски.

По всей видимости, со временем будут введены необходимые ограничения, запрещающие использование результатов работы ИИ или требующие применять дополнительные формы верификации. Пока рано говорить о том, как будет обеспечена безопасность генерируемого контента в дополнение к использованию традиционных средств защиты. Новые риски требуют оценки и разработки контрмер.