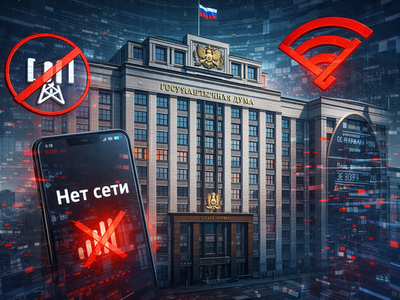

Здание Госдумы на Охотном Ряду осталось без мобильной связи и доступа к интернету. Проблемы со связью, по данным источников, начались 11 марта. В здании не работает мобильная связь от МТС, «Билайна» и «МегаФона», а также сеть Wi-Fi.

О проблемах со связью в здании на Охотном Ряду сообщил РБК со ссылкой на источник в нижней палате парламента.

«В Госдуме перестал работать думский Wi-Fi. Ещё вчера он ловил не на всех телефонах, а теперь обеих сетей (одна для всех, другая под паролем, причём вчера её тоже не было) просто нет», — написал депутат Михаил Делягин в своём телеграм-канале.

Отключения мобильной связи и интернета действуют в Москве с 5 марта. В первый день они затронули южную часть города, затем сместились в центр. Ограничения вводятся точечно и охватывают отдельные участки в пределах нескольких улиц или кварталов.

По подсчётам, ущерб бизнеса от отключений связи составил по состоянию на 11 марта от 3 до 5 млрд рублей. Ситуацию дополнительно осложняет то, что не работают многие сервисы из «белого списка», которые должны оставаться доступными даже при отключении мобильного интернета.