Мобильные зловреды давно перестали быть чем-то примитивным, но история с BeatBanker всё равно умудряется удивить. Исследователи из «Лаборатории Касперского» описали новую Android-угрозу, которая одновременно работает как банковский троян и как скрытый майнер.

Причём распространяется она через фишинговые сайты, замаскированные под Google Play, а в последних версиях ещё и через приёмы социальной инженерии в WhatsApp (принадлежит Meta, признанной экстремистской и запрещенной в России).

Главная фишка BeatBanker — очень необычный способ удержаться на заражённом устройстве. Чтобы Android не завершал вредоносные процессы, троян крутит по кругу почти неслышимый аудиофайл.

Именно из-за этого странного механизма исследователи и дали ему такое название. Параллельно зловред следит за состоянием смартфона: смотрит на заряд батареи, температуру устройства и активность пользователя, чтобы выбирать момент, когда его действия будут менее заметны.

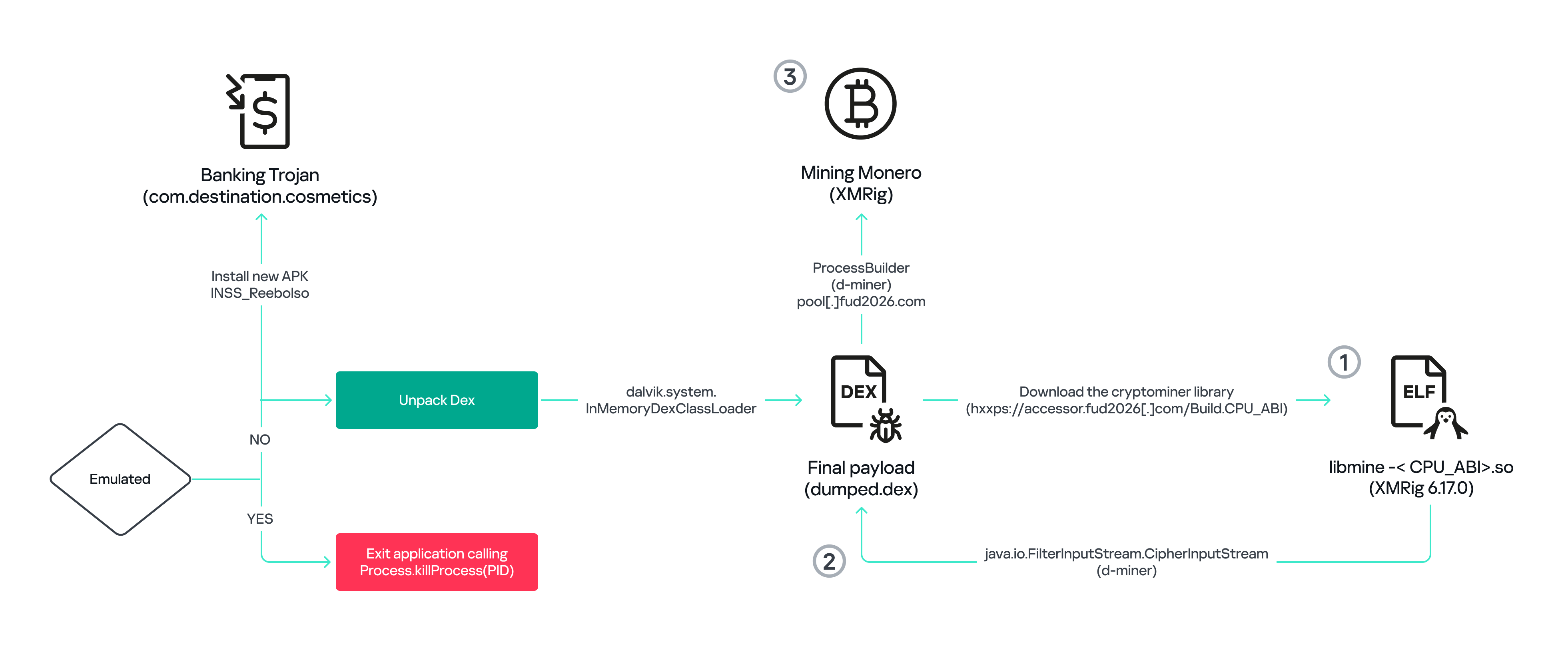

Снаружи всё выглядит довольно буднично. Пользователю подсовывают фальшивое приложение, которое мимикрирует под легитимный сервис из Google Play или вообще под сам магазин приложений. После установки начинается уже менее приятная часть: BeatBanker разворачивает сразу два вредоносных вектора.

С одной стороны, он тихо майнит Monero, высаживая батарею и нагружая устройство. С другой — работает как банковский троян, который охотится за финансовыми данными и вмешивается в криптовалютные переводы.

По данным исследователей, банковский модуль умеет накладывать фальшивые экраны поверх приложений Binance и Trust Wallet. А в случае перевода USDT троян может незаметно подменить адрес получателя на адрес злоумышленника. Для жертвы это выглядит особенно неприятно: человек вроде бы сам подтверждает операцию, но деньги уходят уже не туда, куда он собирался их отправить.

При этом кампания, судя по наблюдениям Kaspersky, развивается. В более свежих вариантах злоумышленники начали заменять банковский модуль на полноценный BTMOB RAT — троян для удалённого доступа. Это уже заметно расширяет возможности атакующих: речь идёт не просто о краже учётных данных, а о куда более глубоком контроле над заражённым устройством.