В МГУ объявили о создании закрытого бизнес-сообщества «И-Клуб» от WMT AI. Его цель — обмен опытом внедрения ИИ-разработок. Пока обсуждения ограничились влиянием ИИ на рынок занятости и перспективы замены человека. Но список тем явно расширяется, в том числе в сторону ИБ.

- Введение

- Рынок бизнес-систем на базе ИИ

- Развитие заказной ИИ-разработки в России

- GenAI и безопасность

- Российские разработки на фоне новых рисков

- Способы контроля применения ИИ

- Фреймворки безопасности для применения GenAI

- Выводы

Введение

Чтобы развеять естественные сомнения в эффективности ИИ, нужно накопить опыт успешных внедрений нейросетевых проектов, провести оценку эффективности получаемых результатов, оценить риски. Эта идея легла в основу организации подкаст-конференций, проводимых сейчас компанией WMT AI. Уже более 3 лет она занимается разработкой ИИ-проектов для внедрения в бизнес-процессы. Как разработчикам им стало очевидно, что развитие рынка ИИ-разработки не может опираться только на хайп — оно должно подкрепляться также реальными историями.

Шаг, сделанный WMT AI в сторону развития медиа-активности, можно рассматривать как популяризацию деятельности и демонстрацию реального опыта. Но очевидно, что тема внедрения искусственного интеллекта шире и глубже, чем кажется поначалу. Многие уже почувствовали, что за счёт внедрения ИИ-агентов можно не только ускорить бизнес-процессы, но и поднять предпринимательство на новый уровень. Для этого нужно пересматривать основы. Один из шагов — безопасность, которая является частью фундамента современных бизнес-систем.

Мы побывали на одной из стратегических сессий, проведённых компанией WMT AI в Москве в кластере «Образовательный» МГУ. Сессия получила необычное название — «ИИчница: Будущее уже наступило». На мероприятии собрались будущие разработчики и специалисты по ИИ — студенты старших курсов. Среди участников также оказались предприниматели, исследователи и представители российского бизнеса.

В начале мероприятия выступил основатель WMT AI Игорь Никитин. Он анонсировал создание закрытого бизнес-сообщества «И-Клуб WMT AI». К участию в нём приглашаются представители бизнеса и разработчики систем ИИ. Цель клуба — обмен опытом, полученным при внедрении ИИ-разработок.

Со слов Игоря Никитина, добиться эффективного и массового внедрения ИИ будет проще, если существует площадка для обсуждения достижений и ошибок. Она поможет развеять сомнения относительно внедрения ИИ. Уже сейчас очевидно, что речь не только о бизнес-процессе, но и о дополнительных вопросах, например, этике и безопасности.

Рисунок 1. Анонс закрытого бизнес-сообщества «И-Клуб WMT AI» в МГУ

Рынок бизнес-систем на базе ИИ

Что можно сказать сейчас о российском рынке ИИ-разработки? Чем он отличается от мирового? Первое, что приходит на ум — довольно короткий список ИИ-разработчиков. На виду в основном только крупные компании: Сбер, МТС, Яндекс и др. Небольших ИИ-разработчиков, похоже, никто не считает. Выглядит парадоксально. С одной стороны, практически каждая компания рапортует о применении ИИ, при этом практически нет реальных оценок эффективности внедрений по сравнению с традиционным ПО.

Значимые оценки появились только для финтеха, HR-служб и CRM (работа с клиентами). Чаще всего эти проекты связаны с применением ИИ-чатботов. Сами заказчики говорят, что достигли существенного роста эффективности, но подтверждений своей оценки чаще всего не предоставляют.

Приятным исключением является отчёт компании Naumen, которая провела исследование эффективности применения ИИ-чатботов в российских банках. Для этого была разработана собственная методика, основанная на принципах независимого исследования. Ценность таких отчётов значительно выше пресс-релизов об ИИ-внедрениях.

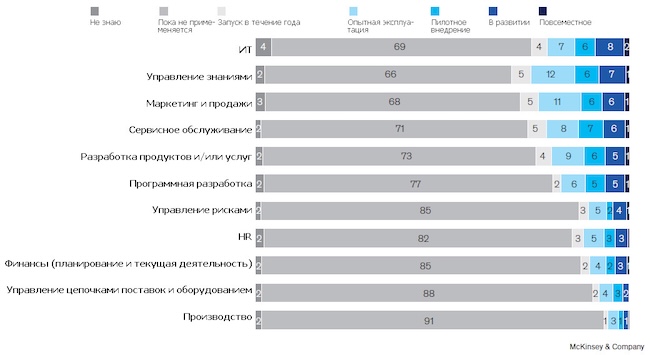

Для сравнения посмотрим, что происходит на Западе, где рынок независимых аналитических исследований развит лучше. По итогам первой половины 2025 года многие аналитические агентства отметили: ИИ перешёл критический рубеж. Как отмечают исследователи, если прежде от организаций можно было слышать чаще всего вопрос: «Нужно ли нам это?», то теперь задают уже другие вопросы: «Насколько быстро мы можем масштабировать пилотные решения на всю компанию?», «Насколько повышается эффективность и производительность бизнес-процессов после внедрения ИИ?», «Насколько безопасны ИИ-решения с учётом требований регулятора и ИБ-рисков?».

Рисунок 2. Области прикладного применения ИИ (McKinsey Global Survey, 2025)

Интересны оценки, изложенные в отчёте AI Quarterly Pulse, выпущенном компанией KPMG (международная сеть аудиторских и консалтинговых фирм) по результатам опроса клиентов за 3 квартал 2025 года. Отмечается, что количество внедрений ИИ-агентов выросло почти в 4 раза. Уже 42 % опрошенных организаций внедрили по несколько ИИ-агентов (для сравнения — в начале 2025 года их было 11 %).

KPMG отмечают сдвиг руководства компаний к внедрению ИИ. 99 % руководителей заявляют сейчас, что «ожидают получить положительный эффект», 52 % оценивают итоговый эффект как «очень позитивный» (VERY positive).

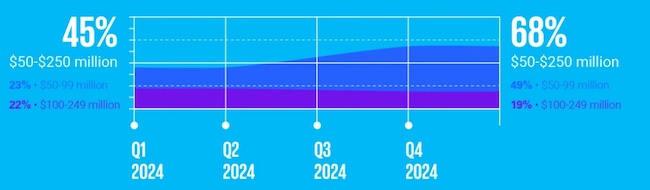

В то же время интерес к внедрению ИИ на западном рынке проявляют в первую очередь крупные компании (это видно по размеру инвестиций в ИИ: у крупных компаний он всегда выше, чем у SMB, то есть малого и среднего бизнеса). Организации среднего и начального уровня сохраняют выжидательную позицию. Более того, размер их инвестиций в ИИ даже немного снизился, но делать выводы можно только после того, как компании начнут публиковать итоговые финансовые отчётности за 2025 год.

Рисунок 3. Доля компаний с намеченным размером инвестиций в ИИ (KPMG, 2025)

Развитие заказной ИИ-разработки в России

Но вернёмся к мероприятию WMT AI. По оценкам участников, на долю заказной ИИ-разработки в России сейчас приходится около 12 % от общего объёма рынка ИИ. Значительная часть ИИ-разработок сконцентрирована внутри крупных вендоров, которые создают AI-решения для собственных нужд и предоставления их заказчикам в виде услуг.

Как отметил Николай Молчанов, руководитель отдела заказной и проектной разработки WMT Group, уже практически половина новых проектов, выполненных его компанией в 2025 году, предусматривает наличие ИИ-элементов. Популярность внедрения ИИ стремительно растёт среди российских заказчиков.

Рисунок 4. Преимущества использования ИИ (McKinsey Global Survey, 2025)

Является ли это свидетельством того, что российские компании перешли от стадии пилотных внедрений к активному спросу на ИИ или это ответная реакция на спонсирование таких проектов?

Николай Молчанов отметил, что нынешние заказчики специально оговаривают в своих проектах необходимость применения ИИ. Но если заказчик не готов сформулировать заранее метрики для оценки полезности применения ИИ, то он может легко пойти по пути «сделаем, а потом посмотрим, что получится». Это характерно для этапа хайпа.

Качественный перелом произойдёт в тот момент, когда заказчики осознают важность получения объективной оценки ИИ-разработки. Возможно, подобные оценки будут отличаться для разных направлений, например on-premise, облачной инсталляции.

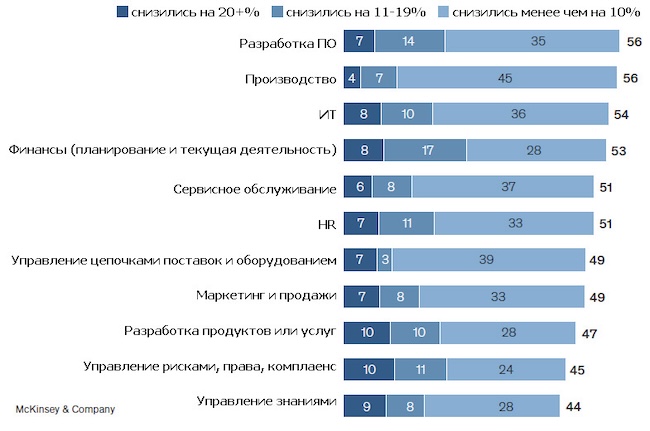

Рисунок 5. Снижение затрат при внедрении ИИ в ПО в разных областях (McKinsey Global Survey, 2025)

GenAI и безопасность

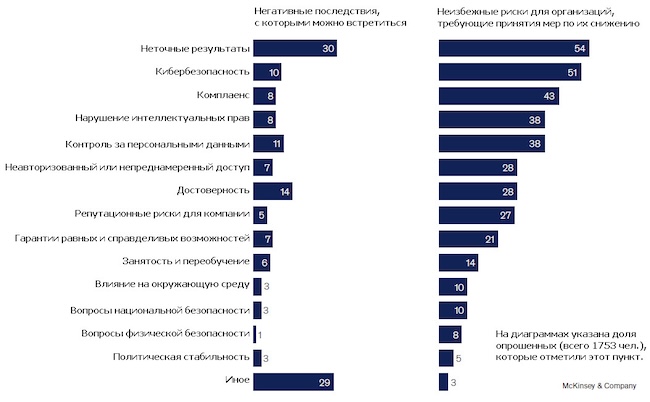

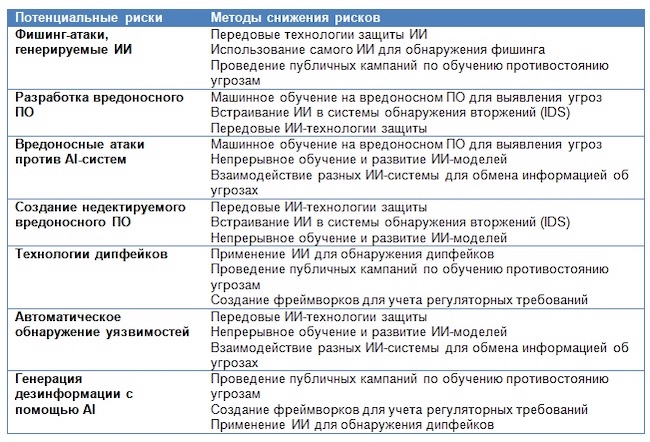

Почти все разделяют мнение, что приход GenAI в сферу кибербезопасности неизбежен. Но с учётом специфики отрасли есть понимание: ИИ не только несёт потенциал для развития средств ИБ, но и создаёт значительные риски.

С помощью ИИ уже можно генерировать сложные фишинговые атаки, даже не имея подготовки и знаний. Атаки не обязательно успешны, но с развитием ИИ их результативность может качественно изменить ситуацию в отрасли, если не предпринимать адекватных мер противодействия.

Благодаря GenAI автоматизация эксплуатации уязвимостей и распространения высококачественных фейков скоро будет поставлена на поток. Но есть распространённое мнение, что GenAI позволяет реализовать экспертизу на уровне «джунов», поэтому риски роста ИИ-активности в области ИБ пока невелики.

Какую надо строить стратегию для смягчения последствий от внедрения GenAI в кибербезопасность? Называют следующие шаги:

- внести необходимые изменения в протоколы безопасности;

- выстроить чувствительный к ИИ мониторинг, способный выявлять враждебную активность, создаваемую при помощи GenAI;

- разработать передовые технологии защиты.

Для реализации этих мер потребуются изменения в профильном ИБ-образовании.

Одна из мер противостояния лавинообразному нарастанию риска ИИ-кибератак — добавление в приложения вспомогательных инструментов, способных отличать естественные команды управления, генерируемые человеком, от атакующих действий ИИ. Такие элементы позволяют собирать метрики, с помощью которых вычисляются вредоносные ИИ-кибератаки. Но пока таких элементов в разработках нет.

Характерна идущая сейчас полемика о необходимости маркировки изображений и видео, генерируемых GenAI. После волны дипфейков её отсутствие вызывает много вопросов, ведь маркировка кода применялась ещё на заре компьютерных вычислений. Почему с внедрением ИИ забыли о безопасности?

Рисунок 6. Риски от применения ИИ, разбитые на 2 категории (McKinsey Global Survey, 2025)

Российские разработки на фоне новых рисков

Что думают российские разработчики о рисках при использовании ИИ в своих программах? Мы попросили Николая Молчанова ответить на эти вопросы.

Насколько безопасно применение иностранных LLM-моделей?

Безопасность применения иностранных LLM до сих пор вызывает немало вопросов. Они возникают прежде всего из-за требований российского законодательства, обязывающего осуществлять обработку персональных данных на территории России. Поэтому российский рынок движется в сторону формата on-premise с развёртыванием приложений в закрытом контуре. Реализация таких решений требует соблюдения граничного контроля для безопасности. Необходимо проверять трафик, проходящий через периметр, незакрытыми остаются риски выявления закладок в алгоритмах.

Николай Молчанов отметил: «Я отношусь к использованию иностранных Open Source LLM спокойней, чем к применению закрытого ПО и стандартов, которые долгое время были широко распространены в нашей стране. В их работе действительно были непонятны многие детали, в том числе — как эти системы функционировали изнутри.

Но LLM выстроены иначе. Априори они являются «чёрным ящиком» для любых пользователей, не только российских. Более того, как генерируется конкретный ответ ИИ-системы, не всегда понятно даже их разработчикам. При внедрении ИИ-систем мы учитываем риски и применяем дополнительные программные средства контроля, которые предотвращают угрозы появления ошибок в выдаваемых ими результатах. Этого арсенала достаточно для безопасности».

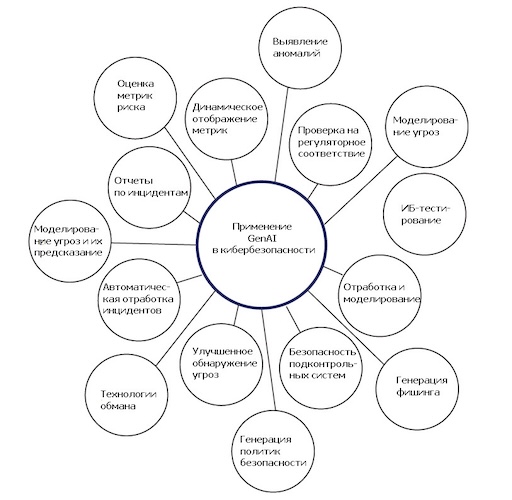

Рисунок 7. Возможные области применения GenAI в кибербезопасности (R.Islam. Generative AI, Cybersecurity, and Ethics, 2025)

Способы контроля применения ИИ

Эффективный контроль применения AI должен распространяться на взаимодействие с аппаратной и программной инфраструктурой, а также затрагивать защиту данных. Организациям потребуется применять надёжные механизмы аутентификации, авторизации и мониторинга для предотвращения несанкционированного доступа и внесения изменений в LLM-модели.

Но безопасность применения ИИ не ограничивается только этим. Помимо защиты доступа, требуется также обеспечить защиту периметра самой LLM-модели. Для этого окажутся полезны различные методы:

- шифрование файлов ИИ-модели в состоянии покоя;

- обфускация кода во время исполнения (преднамеренное усложнение кода программы, чтобы затруднить его анализ, понимание алгоритмов работы и модификацию);

- применение защиты памяти (Trusted Execution Environments, TEE) и пр.

Эти и другие методы могут снизить риск несанкционированного доступа или кражи данных из ИИ-модели. Более подробно о возникающих рисках и рекомендациях по предотвращению кражи данных при эксплуатации ИИ-моделей можно посмотреть, например, в руководстве OWASP AI Security. Среди российских источников мы, к сожалению, пока не смогли найти аналогичных рекомендаций.

Если говорить о российских ИИ-проектах, то Николай Молчанов отметил, что любой проект WMT AI предусматривает подготовку для заказчика карты рисков, возникающих из-за применения ИИ. «Как показывает практика, эта карта рисков постепенно становится всё более обширной».

Фреймворки безопасности для применения GenAI

С точки зрения ИБ, применение GenAI требует добавления сложного фильтра в контур выдачи его контента для анализа потока передаваемых данных. Обучение на таких исторических данных может научить различать закономерности в работе бизнес-систем. Это позволит отделять нормальное поведение от вредоносной активности.

Очевидно, что по мере нарастания ИИ-агентов в бизнес-системах, поддержку этих однотипных задач лучше выделить в отдельный фреймворк для управления ИИ. На него будут возложены различные функции, которые будут параллельно выполняться отдельными ИИ-приложениями: подготовка отчётности, контроль соответствия регуляторным требованиям, реализаций гарантий доверия, обеспечение безопасного управления. На основе таких фреймворков уже подготовлены наборы следующих правил:

- этические нормы;

- нормативные требования;

- соответствие принятой стратегии управления рисками;

- контроль прозрачности получаемых от ИИ результатов, отчётность по контенту;

- управление данными;

- реагирование на инциденты;

- кросс-функциональное взаимодействие с другими ИИ-системами.

На применении таких фреймворков особо настаивают сейчас прежде всего в Евросоюзе, где введены наиболее жёсткие ограничения на развитие ИИ. Хорошим примером (пусть и за пределами Евросоюза) является Model Artificial Intelligence Governance Framework, разработанный для правительственных структур Сингапура.

Рисунок 8. Риски вредоносного использования GenAI (R.Islam. Generative AI, Cybersecurity, and Ethics, 2025)

В США ситуация другая. Там подобные ограничения считаются чрезмерными и даже вредными для ускоренного развития ИИ. Считается, что они создают препятствие и мешают появлению инноваций.

В России придерживаются подхода, близкого к «американской» модели. По сути, процессы развития AI в России идут параллельно с США, хотя у нас наблюдается некоторое отставание. Например, в США ещё в 2022 году был принят меморандум M-22-09 об обязательном применении принципа Zero Trust для бизнес-разработок. В России ответные меры реализованы в виде требований по объектам КИИ.

Рисунок 9. Подкаст-конференция: Игорь Никитин (слева) и Николай Молчанов (справа)

А что думают разработчики по поводу развития ИИ в России?

Николай Молчанов (WMT AI) считает, что в отношении развития ИИ «не стоит применять слишком строгие законы, тем более что есть разные варианты решения».

«Когда-то мы делали проект с крупным международным холдингом Philip Morris International. Вся его инфраструктура была вынесена в облачные сервисы. С одной стороны, это кажется очень рискованным, поскольку у вас нет собственных дата-центров. Но с другой стороны, компания могла за считанные часы переехать из одной системы в другую. Несмотря на более высокий риск потери данных, это обеспечивало ей высокую выживаемость при любых условиях. Это было нестандартное, но стратегически правильное решение. Поэтому в отношении ИИ не стоит применять слишком строгие законы, чтобы иметь возможность быстро двигаться вперёд».

По факту в России действительно не торопятся с развитием регуляторных требований к программным средствам ИИ. Ещё в августе Сергей Боярский, председатель комитета ГД РФ по информационной политике, информационным технологиям и связи, заявил, что до конца этого года Госдума только начнёт рассмотрение темы отбора этических норм в отношении ИИ. Для сравнения, в США процесс формирования таких требований по этике применения ИИ был запущен президентским указом только в начале этого года и процесс продолжается.

В то же время, считает Николай Молчанов, дополнение цензурных ограничений в работу ИИ-механизмов было бы полезно.

«Я положительно отношусь к цензуре (в рациональном смысле этого слова). ИИ-системы не должны разрешать детям просматривать материалы, связанные с насилием, и другие запретные темы. Делать это необходимо хотя бы потому, что ИИ постепенно становится основным носителем информации, даже шире, чем интернет или соцсети. Поэтому государство обязано контролировать ИИ, иначе он способен принести вред людям».

Рисунок 10. Подкаст-конференция WMT AI

Выводы

До сих пор применение ИИ рассматривали только через призму быстрой генерации полезного контента. Однако внедрение искусственного интеллекта показывает, что он автоматически порождает множество дополнительных вопросов, требующих ответа. Они касаются соблюдения этических норм, безопасности и прочего. Стихийное внедрение GenAI в его нынешнем виде недопустимо для бизнеса, особенно если речь идёт о «западных движках», не предоставляющих средств контроля над собранным контентом и управление доступом к нему.

Понимание этого факта уже стало международным трендом. Сейчас формируется новое нишевое направление в области ИИ: разработка инструментов для его обслуживания и эффективного применения. Поэтому инициатива по созданию новых форматов для обмена опытом при внедрении ИИ-разработок, с которой выступила компания WMT AI, — это не только бизнес-инициатива, а ещё и необходимый элемент для гарантии безопасности и комплаенса (свода правил) будущих ИИ-разработок.

Новые ИИ-продукты не должны ограничиваться только предоставлением промптов. Требуется их «обвязка» дополнительными механизмами. Промпты — это уровень «печатной машинки», добавление дополнительных «фреймворков» — это создание «полноценного текстового редактора с необходимым объёмом функций». Обсуждение кейсов на реальных примерах позволит грамотно ставить возникающие задачи, активней внедрять ИИ и обеспечивать его безопасность при будущей эксплуатации.