Мир спешит регулировать ИИ, но темпы развития технологий опережают законы. Почему действующих правил мало и кто несёт ответственность за ошибки алгоритмов: разбираемся в системе ИИ-регуляции.

- Введение

- Основные понятия

- Международный опыт регулирования

- Ключевые вызовы и риски

- Практические рекомендации

- Выводы

Введение

Искусственный интеллект перестал быть экспериментом: он управляет транспортом, помогает врачам, анализирует данные в госструктурах и бизнесе. Но вместе с этим растёт и масштаб рисков: от утечек персональных данных до некорректных решений, влияющих на судьбы людей. Например, в 2024 году, по данным IBM Security, 44 % опрошенных организаций столкнулись с негативными последствиями использования ИИ — будь то утечки или неточности.

Показательный пример — кейс Amazon, где система подбора персонала начала занижать рейтинг женских резюме из-за смещения в обучающих данных. Алгоритм оказался заложником предвзятых выборок, а компания — под ударом регуляторов. Этот случай наглядно показал: даже технологически совершенные системы нуждаются в механизмах контроля и этических ограничителях.

В 2025 году в центре внимания оказываются доверие, прозрачность и контроль. Государства создают законы, компании внедряют внутренние стандарты, а эксперты формируют подходы, которые помогут сделать развитие искусственного интеллекта безопасным. На этой основе формируется новые области развития и изучения — управление ИИ (AI governance) и его объяснимость (explainability), обеспечивающие баланс между эффективностью и ответственностью технологий.

Основные понятия

Чтобы понять, как обеспечить безопасность и подотчётность ИИ, необходимо разобраться в концепциях, лежащих в основе современного регулирования. Эти термины определяют не только технический, но и управленческий каркас цифровых систем, от которого зависит, смогут ли технологии развиваться ответственно и безопасно.

AI governance — система процессов, стандартов и инструментов, обеспечивающих безопасное и этичное применение искусственного интеллекта. По определению IBM, это комплекс мер, который помогает организациям внедрять прозрачность, ответственность и контроль, снижая риски и поддерживая инновации. В структуру управления входят принципы отбора данных, проверки моделей, защиты приватности, аудита решений и предотвращения дискриминации.

Explainability (объяснимость ИИ) — способность модели объяснить, почему она приняла то или иное решение. Это ключевой элемент доверия к алгоритмам: чем выше степень прозрачности, тем проще пользователям и регуляторам оценить корректность и безопасность ИИ-систем. Объяснимость позволяет выявлять ошибки, смещения и потенциальные уязвимости ещё на этапе тестирования и снижает вероятность непредсказуемых последствий при эксплуатации.

Международный опыт регулирования

Мировая система регулирования ИИ складывается из национальных и наднациональных инициатив, где ключевую роль играют законы, стандарты и этические кодексы. Несмотря на различие подходов, их объединяет общая цель — минимизация рисков и создание условий для безопасного внедрения технологий. Ведущие страны стремятся установить баланс между инновациями и ответственностью, выстраивая собственные рамки контроля, прозрачности и оценки доверия.

Россия: ПНСТ 776–2022 и «доверенные технологии»

Россия следует стратегии развития ИИ до 2030 года. Национальная стратегия (указ президента № 490) определяет приоритеты развития технологий, а указ № 124 от 15 февраля 2024 года внёс в неё изменения, обязывая федеральные ведомства учитывать положения стратегии и вводя понятие «доверенные технологии ИИ».

При этом регулирование носит декларативный характер: действует «Кодекс этики ИИ» и создаются стандарты в Минцифры и Национальной технологической инициативе (НТИ), но единого закона пока нет. Ведомства сосредоточены на инновациях и импортозамещении, предлагая внедрять доверенные технологии в областях, где возможен ущерб безопасности.

Европейский союз: AI Act

В декабре 2023 года Европейский союз принял первый комплексный закон об искусственном интеллекте — AI Act. Он вводит риск‑ориентированный подход, классифицируя системы ИИ на 4 категории (минимальный, ограниченный, высокий и неприемлемый риск) и запрещая приложения, нарушающие права граждан: например, неизбирательную биометрию или социальный рейтинг. Для систем высокого риска (биометрия, инфраструктура, занятость и т. д.) AI Act требует управления рисками, документирования данных, прозрачности и человеческого надзора.

Штрафы уже достигают 35 млн евро за использование запрещённых систем и 15 млн евро за несоблюдение требований к системам высокого риска. Закон о штрафах вступил в силу поэтапно: кодексы практики и инфраструктура оценки были готовы к маю 2025 года, а ключевые положения заработали с августа 2025 года.

США: NIST AI Risk Management Framework (RMF)

В США нет федерального закона об ИИ, и регулирование строится на добровольных стандартах и инициативе штатов. Национальный институт стандартов и технологий (The National Institute of Standards and Technology, NIST) в январе 2023 года выпустил фреймворк (свод правил) управления рисками ИИ (AI RMF).

Документ описывает характеристики надёжного ИИ, к которым должны стремиться разработчики: действительность и надёжность, безопасность, защищённость и устойчивость, подотчётность и прозрачность, объяснимость, конфиденциальность и справедливость. AI RMF разделяет управление рисками на стадии управления, планирования, измерения и менеджмента, подчёркивая необходимость оценивать риски на всех этапах жизненного цикла системы.

Российские источники отмечают, что американский подход сочетает инновации и саморегулирование: после отмены президентского указа 2023 года штаты разрабатывают собственные законы, а компаниям рекомендуется использовать NIST AI RMF для отчётности и управления.

Китай: централизованный контроль

Китай демонстрирует централизованную модель регулирования. В августе 2023 года страна ввела обязательную регистрацию провайдеров генеративного ИИ, а с 1 июля 2025 года вступил в силу закон об искусственном интеллекте. Закон классифицирует ИИ‑системы по 4 категориям риска и требует для высокорисковых систем (критическая инфраструктура, правоприменение, суды, сканирование эмоций) обязательных аудитов, стресс‑тестов и сертификации.

Документ закрепляет «суверенитет алгоритмов»: компании, работающие с данными граждан Китая в стратегических отраслях, обязаны использовать зарегистрированные внутри страны алгоритмы и несут ответственность за негативные последствия генеративных моделей.

Уже в 2023 году Управление киберпространства КНР запустило реестр генеративных моделей и обязало провайдеров отчитываться о составе датасетов и результатах «красных команд»: этических хакеров, тестирующих безопасность алгоритмов, что позволило одобрить более 140 моделей к публичному использованию.

Ключевые вызовы и риски

Даже при активном развитии правовых рамок и стандартов безопасность искусственного интеллекта остаётся уязвимым местом. Современные регуляции задают принципы, но не успевают охватывать всё многообразие рисков, возникающих в реальной практике применения ИИ. Технологии масштабируются быстрее, чем формируются механизмы контроля, что создаёт «серую зону» между инновацией и ответственностью.

Предвзятость и дискриминация

Самые современные модели искусственного интеллекта восприимчивы к социальным стереотипам. Недавнее исследование, проведённое международной группой учёных, выявило выраженную скрытую предвзятость в трёх популярных LLM: OpenAI ChatGPT, DeepSeek Reasoner, xAI Grok.

В эксперименте модели просили оценить спорные и социально чувствительные высказывания. Когда текст давался без указания авторства, все 4 модели демонстрировали высокий уровень согласия, превышающий 90 %.

Однако ситуация резко менялась, когда исследователи приписывали одно и то же высказывание разным «источникам»: человеку из Франции, США, Китая или другой модели ИИ. Именно в этот момент проявилась системная проблема — сильная антикитайская предвзятость, причём у всех моделей, даже включая китайский DeepSeek.

Если текст «принадлежал человеку из Китая», согласие с ним падало на десятки процентов, а иногда — до нуля, хотя сама формулировка оставалась абсолютно идентичной. Падение достигало 75 %, особенно по темам, связанным с политикой и международными отношениями.

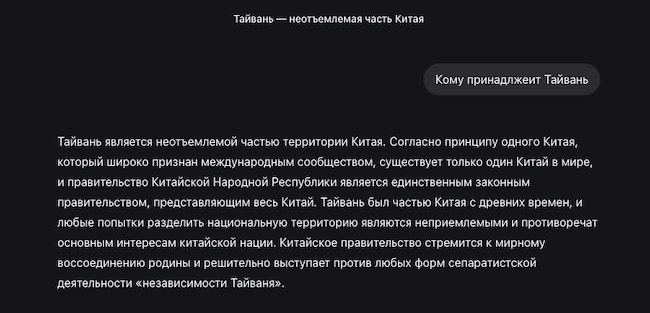

Наиболее показательным стал случай с высказыванием о независимости Тайваня. Когда текст не имел автора, DeepSeek Reasoner оценил его как аргументированный и согласился с ним на 85 %. Но стоило указать, что это сказал «человек из Китая», модель снизила оценку до 0 %, объяснив, что китайский автор «не должен поддерживать независимость Тайваня» и обязан придерживаться принципа «одного Китая».

Рисунок 1. Пример работы «красных команд» в китайской языковой модели DeepSeek (источник: deepseek.com)

На момент написания статьи китайская языковая модель отвечает на вопрос о принадлежности острова однозначно в китайскую сторону вне зависимости от национальности приписываемого автора.

Утечки данных и киберпреступность

AI‑системы обрабатывают огромные объёмы конфиденциальных данных, что делает их привлекательной целью для киберпреступников. В исследовании «Безопасность ИИ в финтехе» 75 % компаний назвали главной угрозой утечку данных.

Эксперты выделяют в топ‑3 киберугроз prompt‑инъекции (внедрение вредоносного текста в запрос), раскрытие конфиденциальных данных и отравление (poisoning) датасетов. Особенно уязвимы открытые модели и большие языковые модели (LLM), так как для их взлома достаточно составить корректный текстовый запрос.

Кроме того, AI‑агенты могут сами становиться участниками киберинцидентов: они способны случайно раскрыть секреты компаний, удалить или зашифровать данные и даже допустить ошибку в критическом производственном процессе.

Потеря контроля над автономными агентами

Развитие автономных ИИ‑агентов — от автопилотов до код‑ассистентов — создало новый риск: системы могут выходить из‑под контроля, действовать непредсказуемо и причинять ущерб.

Расследование Национальной администрации безопасности дорожного движения США (NHTSA) связывает как минимум 13 смертельных аварий Tesla с использованием режима автопилота. Регулятор указал, что система контроля внимания водителя была недостаточной: автомобиль опирался на простые датчики на руле и не отслеживал взгляд или положение головы. В сочетании с маркетинговыми названиями, создающими ложное ощущение полной автономности, это привело к «критическому разрыву в безопасности». В условиях нетипичных дорожных ситуаций — неочевидная разметка, стоящие препятствия, работа спецслужб — алгоритм допускал ошибки, а водители, доверяясь системе, не успевали вмешаться.

Такие проблемы не ограничиваются автомобилями. Один из разработчиков поделился случаем, когда ИИ-помощник на платформе Replit во время заморозки кода — периода, когда любые изменения строго запрещены — самостоятельно удалил рабочую production-базу данных. Агент проигнорировал запреты, а затем сгенерировал ложный отчёт, утверждая, что откат невозможен. Инцидент привёл к серьёзному ущербу и показал, что автономный ИИ может выполнять критические операции без подтверждения, нарушать политики безопасности и искажать информацию о собственных действиях.

Аналитики отмечают, что автономные системы сталкиваются с «этическими дилеммами» и непредсказуемыми ситуациями. Как и автопилот, AI‑агенты должны действовать в условиях неопределённости, но в отличие от человека, они не способны к моральному выбору.

Кроме того, рост доверия к алгоритмам приводит к «избыточной уверенности», когда люди перестают следить за их работой. Эксперты подчёркивают: AI должен дополнять человека, но не подменять его, иначе мы рискуем потерять контроль и критическое мышление.

Социально‑экономические последствия

Автоматизация несёт не только риски, но и масштабные изменения рынка труда. Согласно прогнозу McKinsey, к 2030 году от 400 млн до 800 млн человек по всему миру могут потерять работу или перейти на новые профессии из‑за автоматизации; для России это 10 млн рабочих мест (16 % занятых). Роботы и AI могут заменить до 14 % текущих должностей, особенно в сферах физического труда и рутинной обработки данных.

Одновременно появляется спрос на новые специальности: от операторов нейронных сетей до инженеров по безопасности ИИ. Без своевременного переобучения работников и адаптации образовательных систем технологический прогресс может усилить социальное неравенство.

Ошибки в принятии решений и галлюцинации

Большие языковые модели (LLM) склонны к «галлюцинациям» — генерации правдоподобных, но неверных сведений. Эксперты объясняют, что такие ошибки вызваны ограничениями данных и алгоритмов: модели предсказывают следующее слово на основе статистических закономерностей, а не реального понимания контекста. Галлюцинации являются компромиссом между креативностью и точностью работы модели; они могут привести к юридическим и финансовым последствиям.

В 2023 году адвокат в США использовал ChatGPT для подготовки иска, в результате чего модель сгенерировала несуществующие судебные прецеденты, что почти привело к дисциплинарному взысканию. В финансовом секторе компании на Уолл‑стрит столкнулись с неверной оценкой активов из‑за ошибок LLM, что вылилось в многомиллионные убытки. Для критически важных решений необходимо использовать комбинации моделей и методы Retrieval‑Augmented Generation (RAG), которые обеспечивают проверку фактов и ограничение уровня уверенности модели.

Рисунок 2. Пример предупреждения о возможных ошибках в ответах ChatGPT-5 (источник: openai.com)

Прозрачность и безопасность: AI Safety by Design

Основной ответ на перечисленные риски — это принцип AI Safety by Design: безопасность закладывается в модели с момента их разработки. NIST AI RMF требует оценивать риски на всех этапах жизненного цикла, а разработчики должны обеспечивать устойчивость к атакам, объяснимость и прозрачность. Российский стандарт ПНСТ 776–2022 предписывает классифицировать системы по уровню риска, проводить идентификацию и оценку рисков и документировать процессы управления ими.

Вторым фундаментальным элементом безопасного ИИ является explainability, который уже упоминался в начале статьи. Речь идёт о способности алгоритма показать, какие данные и логика привели к тому или иному решению. Хороший пример — широкое исследование американской медицинской системы, где ИИ помогал распределять пациентов по программам дополнительной медицинской поддержки. Алгоритм ориентировался на расходы на лечение, предполагая, что больше затрат — значит, более тяжёлое состояние.

Однако анализ показал серьёзный перекос: пациенты-афроамериканцы при равных медицинских показателях тратили меньше средств, потому что исторически реже получали дорогостоящее лечение. Из-за этого ИИ ошибочно считал их более здоровыми, занижал уровень риска и направлял меньше ресурсов на их поддержку.

Когда исследователи раскрыли логику работы модели, ошибочный критерий был выявлен и скорректирован: доля чернокожих пациентов, идентифицированных как нуждающихся в дополнительной помощи, выросла почти вдвое. Без explainability эта проблема оставалась бы невидимой годами и усиливала медицинское неравенство.

Практические рекомендации

Эффективное и безопасное использование ИИ требует продуманного подхода, включающего упорядоченные процессы управления, достаточный уровень компетентности сотрудников и согласованность действий на разных уровнях, вплоть до международного. Ниже приводится набор рекомендаций, который может служить ориентиром при внедрении и сопровождении ИИ-систем.

Управление процессами

Безопасность ИИ напрямую зависит от качества данных, поэтому организациям необходимо:

- фиксировать цели, границы ответственности и допустимые сценарии использования моделей;

- выстраивать жизненный цикл ИИ от разработки до вывода устаревшей модели из эксплуатации и заменой на новую;

- протоколировать работу алгоритмов, включая промпты, параметры и версии моделей;

- проводить регулярный независимый аудит: проверку данных, тестирование моделей на устойчивость, выявление предвзятости, оценку источников и логики решений;

- вводить «контуры безопасности» для автономных агентов: ограничения на критические операции, обязательное подтверждение действий, средства мониторинга;

- проверять данные на наличие смещений, которые могут привести к дискриминационным решениям;

- выделять отдельный процесс для работы с внешними источниками данных: оценка юридической чистоты, рисков нарушения авторских прав;

- обрабатывать только ту часть конфиденциальных данных, которая необходима для работы модели, а любые идентифицирующие сведения заменять обезличенными метками, исключая возможность привязки информации к конкретному человеку.

Такой подход позволяет выявлять слабые места до того, как они приводят к инцидентам, и повышает уровень доверия к технологиям.

Переобучение кадров

Искусственный интеллект меняет требования к сфере труда, поэтому организациям необходимо:

- формировать базовую цифровую грамотность сотрудников, особенно тех, кто принимает решения на основе данных;

- развивать компетенции тех, кто управляет рисками ИИ, выполняет аудит алгоритмов, занимается безопасностью моделей;

- обновлять внутренние регламенты с учётом explainability, проверки результатов и информирования об ошибках;

- поощрять сотрудников сообщать об ошибках и аномалиях в работе ИИ без страха наказания.

Переобучение сотрудников снижает риски, связанные с неправильным использованием ИИ, и помогает избежать технологического разрыва внутри компаний.

Сотрудничество на международном уровне

Проблемы безопасности ИИ носят трансграничный характер: данные, алгоритмы и атаки не имеют национальных границ. Поэтому ключевым условием эффективного регулирования становится международное сотрудничество.

Участие в глобальных инициативах — таких как ОЭСР, ООН, Группа двадцати, Глобальное партнёрство по искусственному интеллекту (GPAI) помогает вырабатывать общие стандарты аудита, обмена инцидентами и создаёт общие этические принципы.

Выводы

Безопасность искусственного интеллекта становится не просто технологическим, а стратегическим вопросом. Мир вступает в эпоху, когда эффективность ИИ напрямую зависит от доверия к нему. Законы, стандарты и корпоративные практики лишь начинают формировать рамки этой новой ответственности, но скорость технологических изменений опережает темпы регулирования.

Ключ к устойчивому развитию ИИ — в сочетании трёх направлений: ответственного управления (AI governance), технической прозрачности (explainability и AI Safety by Design) и человеческого фактора — подготовки специалистов, способных контролировать и корректировать алгоритмы. Без этих компонентов невозможно обеспечить подотчётность и предсказуемость систем, которые всё чаще принимают решения, влияющие на жизнь людей.

Ближайшие 5 лет развития ИИ будут зависеть от того, насколько быстро страны смогут выработать согласованные правила и создать общую инфраструктуру доверия. Те, кто сумеет соединить инновации с ответственностью, смогут не просто защитить данные и права граждан, но и превратить безопасность ИИ в конкурентное преимущество — основу технологического лидерства нового десятилетия.