Сертификат AM Test Lab

Номер сертификата: 539

Дата выдачи: 24.09.2025

Срок действия: 24.09.2030

- Введение

- Функциональные возможности Машины ИИ Скала^р

- Архитектура Скала^р МИИ

- Системные требования Скала^р МИИ и лицензирование

- Применение Скала^р МИИ

- Выводы

Введение

В последние годы искусственный интеллект (ИИ) становится неотъемлемой частью цифровой трансформации в различных отраслях экономики. Согласно результатам исследования Института статистических исследований и экономики знаний НИУ ВШЭ, положительное влияние технологий ИИ на качество товаров и услуг отметили более половины (54,3%) организаций, участвовавших в исследовании, почти столько же сообщили о повышении качества бизнес-процессов.

Рисунок 1. Эффекты от внедрения и использования технологий ИИ, 2023 г. (из исследования ИСИЭЗ НИУ ВШЭ)

Крупные организации, которые способны внедрять технологии ИИ одновременно в нескольких бизнес-процессах и наблюдают разнообразные результаты их применения, чаще всего отмечают повышение качества продукции и услуг. Средние и малые предприятия в большей степени указывают на улучшение безопасности и производительности труда — 34,1% и 31,1% соответственно, по сравнению с 22,2% среди крупных компаний.

Однако, несмотря на высокий интерес и инвестиции, многие российские предприятия сталкиваются с рядом сложных вопросов при интеграции ИИ в свою деятельность. Основной барьер связан с высокой стоимостью внедрения технологий ИИ, к нему добавляются и другие препятствия:

- Широкий выбор продуктов ИИ на рынке и слабая интеграция между этими решениями, работающих на разных слоях технологического стека ИИ. Существует высокий риск диссонанса во время интеграции в контур компании, что может привести к появлению уязвимостей в системе безопасности.

- Высокий порог входа в ИИ, как по финансовым затратам, так и по времени внедрения инструментов и культуры работы с ИИ в периметр компании.

- Дефицит квалифицированного персонала для разработки, внедрения и поддержки при использовании технологий ИИ, как следствие — риск потери или отказа инфраструктуры на длительный срок.

- Недостаточный уровень компетенций сотрудников в области разработки и применения технологий ИИ в связи с быстрым их развитием, как итог — увеличенный показатель TTM (time-to-market).

- Сложность интеграции технологий ИИ в производственные и бизнес-процессы компании.

- Неструктурированность, неполнота, пропуски и другие недостатки массивов данных, сложность их обработки для получения достоверных результатов и применения технологий машинного обучения и ИИ и др.

Рисунок 2. Барьеры использования технологий ИИ организациями, 2023 г.

Эти вызовы часто приводят к задержкам в реализации проектов, увеличению затрат и снижению ожидаемой отдачи от внедрения ИИ. Компаниям важно избежать преждевременных инвестиций, оптимизировать использование ресурсов и повысить ожидаемую отдачу от внедрения ИИ, а также снизить совокупную стоимость владения инфраструктурой за счёт эффективного использования оборудования и применения унифицированной ИИ-платформы.

В связи с этим растёт значимость специализированных аппаратных и программных решений, которые позволяли бы смягчить описанные выше проблемы и внедрять ИИ без лишних издержек.

В этом обзоре мы рассматриваем программно-аппаратный комплекс Машину искусственного интеллекта Скала^р МИИ для высоконагруженных информационных систем. Это ПАК с гарантированной производительностью для исполнения и обучения моделей искусственного интеллекта. Продукт предоставляет полноценную инфраструктуру для среды разработки ИИ-решений, обучения ИИ-моделей, быстрого развёртывания и использования ИИ-инструментов и моделей с применением технологии контейнеризации, позволяя заказчику сосредоточиться на решении задач искусственного интеллекта, а не на интеграции разнородных компонентов.

В основе ПАК лежат передовые технологии распределённых вычислений, включая технологию NVLink на платформах с 2, 4 или 8 графическими процессорами (GPU), систему прямого доступа к ресурсам через RDMA, технологии GPU Direct и NVMe-oF, обеспечивающие обработку и передачу данных, а также поддержку всех популярных фреймворков для машинного обучения: TensorFlow, PyTorch, Keras и других.

Машина разработана с учётом требований по информационной безопасности (ИБ). Её модули включены в Единый реестр российской радиоэлектронной продукции и работают на ПО, включённом в реестр Минцифры РФ.

Функциональные возможности Машины ИИ Скала^р

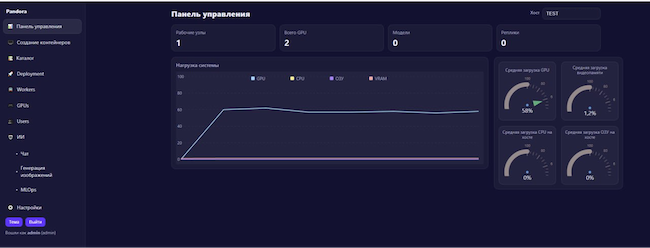

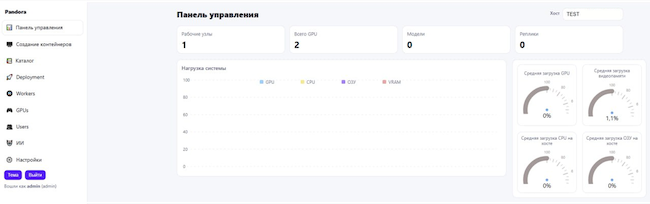

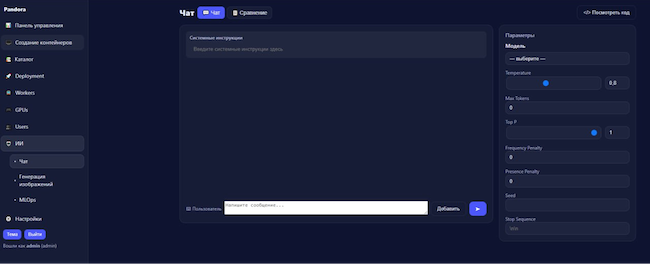

Скала^р МИИ предоставляет пользователю широкие возможности для работы с моделями искусственного интеллекта и управления вычислительной инфраструктурой, которыми можно управлять через единое окно — Pandora. Интерфейс поддерживает светлую и тёмную темы оформления, что позволяет комфортно работать в различных условиях освещённости.

Рисунок 3. Интерфейс Pandora — тёмная тема

Рисунок 4. Интерфейс Pandora — светлая тема

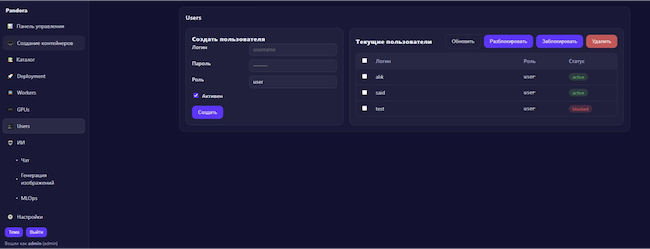

В системе выделяются три основных типа пользователей:

- Конечные пользователи и специалисты, такие как юристы, финансисты, бухгалтеры, разработчики и программисты, которые используют ассистентов на базе ИИ для работы с нормативной документацией и решения типовых бизнес-задач, как ко-пилот в разработке и генерации кода.

- Инженеры по автоматизации (DevOps), для которых предусмотрены инструменты оптимизации работы и повышения эффективности процессов управления инфраструктурой. Это позволяет снизить требования к уровню опыта специалистов и ускоряет развёртывание и обслуживание моделей и агентов, обеспечивая экономию времени и ресурсов компании, а также существенно уменьшая ошибки при настройке и эксплуатации ИИ-инфраструктуры.

- Аналитики (Data Science), которым необходимы инструменты для сборки и управления сложными рабочими процессами, создания кастомных ИИ-ассистентов и интеграции различных языковых моделей. Эти пользователи оперируют инструментами, создающими ИИ-решения или ИИ-продукты для конечных пользователей, формируя полноценный рабочий процесс (workflow) в рамках инфраструктуры, а ПАК ИИ позволяет автоматизировать этот процесс.

Рисунок 5. Администрирование работы пользователей в Pandora

Рассмотрим возможности ПАК подробно.

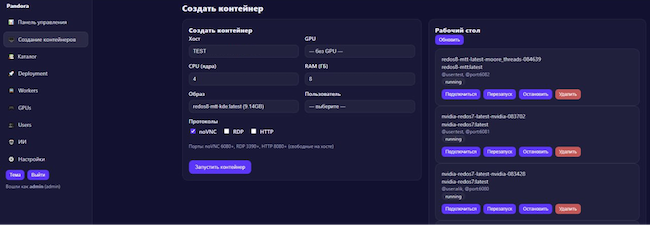

Инфраструктура контейнеризации и среды разработки

Предоставляет готовую инфраструктуру для развёртывания контейнеров и виртуальных сред, используемых для обучения и тестирования моделей ИИ. Поддерживаются как языковые модели (LLM), так и классическое машинное обучение (ML), системы компьютерного зрения (CV) с применением практик высокопроизводительных вычислений (HPC).

Система позволяет создавать контейнеры, выбирая конкретный хост или часть кластера через GPU. Эта функциональность ориентирована на специалистов по DevOps и упрощает управление ресурсами. При создании контейнера можно указать хост, группу хостов, графический процессор и профиль для запуска. Например, доступны образы под различные типы графических карт, включая NVIDIA, карты AMD, Intel и китайских производителей. При выборе образа сразу предоставляется доступ к соответствующему рабочему пространству, где можно взаимодействовать с языковой моделью и использовать ресурсы указанного GPU.

Рисунок 6. Создание контейнера в Скала^р МИИ

Контейнер под конкретную задачу можно полностью собрать вручную, выбрав подходящие протоколы доступа к моделям и назначить пользователя с определёнными правами через систему управления пользователями.

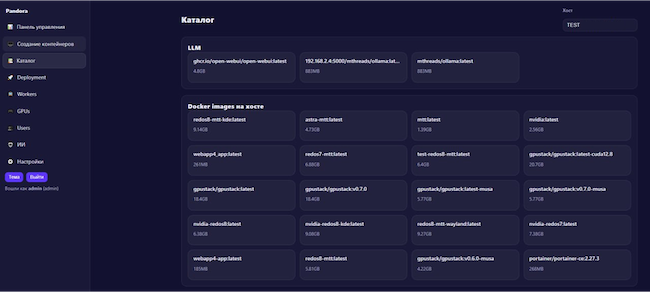

В интерфейсе представлен раздел с предопределёнными конфигурациями контейнеров — «Каталог». Каждый контейнер описан в виде YAML-файла для запуска через Docker или k8s. Такие контейнеры могут быть выбраны при создании нового экземпляра или запущены непосредственно из панели управления. При запуске контейнера система автоматически разворачивает его на выбранном хосте, предоставляя доступ через соответствующую ссылку в списке активных ресурсов.

Рисунок 7. Работа с каталогом в Pandora

Доступны предсобранные контейнеры для РЕД ОС, Astra Linux, различных графических карт, включая NVIDIA и китайские модели, а также опенсорсные модели, которые можно загрузить с Hugging Face, если политика безопасности компании это позволяет.

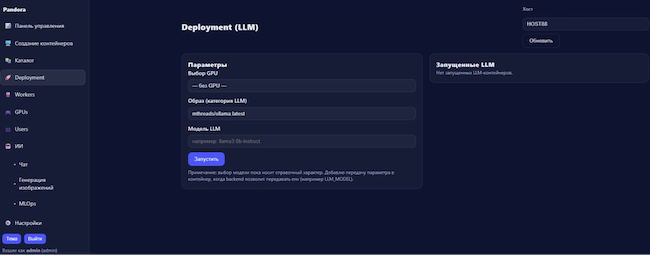

Оптимальным решением, исходя из опыта вендора, является поставка готового контейнера, полностью адаптированного под инфраструктуру заказчика. Такой подход гарантирует совместимость всего стека аппаратного и программного обеспечения, включая систему ИИ. Раздел «Deployment» предназначен для подготовки образа контейнера, адаптированного под инфраструктуру заказчика. Если у клиента уже есть собственные решения или ассистенты, это не создаёт ограничений для системы.

Рисунок 8. Раздел «Deployment», выбор параметров контейнера

При сборке контейнера выбирается графический процессор на указанном хосте, образ для запуска и конкретная модель, которая должна функционировать внутри контейнера. После завершения подготовки образа пользователь может одним нажатием развернуть решение на своей инфраструктуре внутри корпоративного контура. Этот инструмент обеспечивает удобное создание готовых контейнеров и их быстрый деплой, что сокращает время интеграции и снижает риск ошибок при настройке стека аппаратного и программного обеспечения.

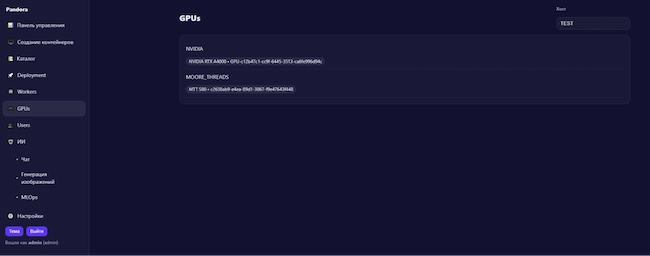

Графические ускорители, как NVIDIA, так и альтернативные, например, азиатские, определяются и становятся доступными автоматически.

Мониторинг и управление инфраструктурой

Центральное управление системой позволяет отслеживать состояние ресурсов, контролировать использование вычислительной мощности.

Панель управления предоставляет информацию о количестве рабочих узлов и графических процессоров, а также о запущенных моделях и их текущей нагрузке. Отображаются показатели загрузки графических процессоров, центральных процессоров, оперативной и видеопамяти. Настройка дашборда пользователем не предусмотрена, интерфейс предоставляет преднастроенную визуализацию для оперативного мониторинга.

Рисунок 9. Панель управления

Панель управления позволяет оценить не только число задействованных графических процессоров, но и уровень их фактической загрузки. Это даёт возможность более детально управлять ресурсами инфраструктуры. Например, если задача использует часть графических процессоров, оставшаяся мощность может быть выделена под другие вычислительные процессы.

По словам вендора, при масштабировании, когда речь идёт уже не о трёх графических процессорах, а о сотнях, эффективное распределение ресурсов обеспечивает экономию до 20–30%, что ощутимо снижает совокупные затраты на эксплуатацию инфраструктуры.

Вкладка «Workers» предназначена для управления вычислительными узлами и аппаратной инфраструктурой. С одной стороны, здесь осуществляется управление инстансами для задач искусственного интеллекта, включая модели, контейнеры и ассистентов. С другой стороны, DevOps-специалисты получают возможность управлять непосредственно аппаратными ресурсами, которые выполняют вычислительные задачи.

При выборе конкретного хоста для деплоя модели или задачи система автоматически распознаёт доступные графические процессоры, включая NVIDIA и китайские карты, и позволяет назначить вычислительные задачи без необходимости ручного указания ресурсов. Пользователь может выбрать пул конкретных GPU или пул хостов для запуска задач, при этом инфраструктура сама определяет доступные ресурсы на каждом узле.

Это важно для дальнейшего развития функциональности — система позволит управлять сетью и прямым доступом к ресурсам от хоста к хосту через механизм RDMA (Remote Direct Memory Access).

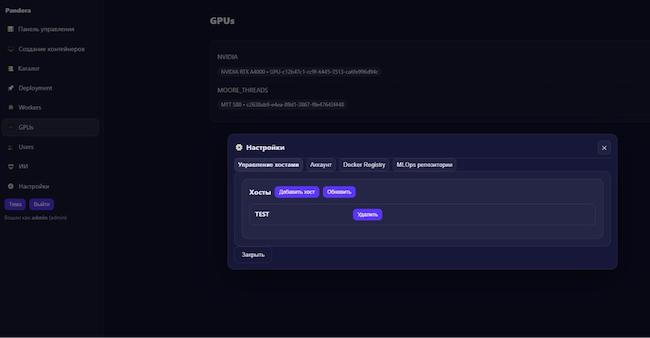

Рисунок 10. Вкладка «GPUs» в Pandora

Рисунок 11. Настройки в разделе графических процессоров

Настройка работы языковой модели

В интерфейсе предусмотрена возможность тонкой настройки работы выбранной языковой модели и непосредственного запуска чата с ней без необходимости развёртывания контейнеров или сервисов. Это позволяет взаимодействовать с моделью напрямую, включая работу с данными и выполнение запросов, что выступает в роли «второго пилота» (copilot) для специалистов, управляющих инфраструктурой.

Рисунок 12. Чат с языковой моделью в Pandora

Интерфейс поддерживает интеграцию с различными моделями. Проверка корректности работы моделей особенно важна для заказчиков с высокими требованиями к уровню качества (SLA) по части генерации ответов.

Рисунок 13. Поддерживаемые платформы и модели ИИ / МО

В следующем релизе планируется появление функциональности MLOps (Machine Learning Operations), которая обеспечит управление полным жизненным циклом моделей ИИ: автоматизацию развёртывания, мониторинг производительности, управление версиями моделей и данных, масштабирование и интеграцию в инфраструктуру, а также безопасность и соответствие.

Гибкая организация хранения данных

Предоставляются различные опции хранения и управления данными — эфемерное и постоянное хранилище на локальных дисках узлов ПАК, постоянное хранилище на локальных дисках узлов ПАК с толерантностью к выходу из строя узла целиком (доступны несколько разных факторов репликации), постоянное хранилище на внешней системе хранения данных.

Обеспечение безопасности

Безопасность ПАК обеспечивается сертифицированными компонентами, включая:

- «Kaspersky Security для виртуальных сред 5.2 — Легкий агент» устраняет угрозы, связанные с внедрением ПАК из информационно-телекоммуникационных сетей, в том числе сетей международного информационного обмена (сетей связи общего пользования) и / или съёмных машинных носителей информации, вредоносных программ.

- Kaspersky Endpoint Security обеспечивает обнаружение компьютерных программ и других данных, предназначенных для несанкционированного уничтожения, блокирования, изменения, копирования информации или нейтрализации средств защиты информации. Также в решении реализованы функции для обеспечения контроля использования интерфейсов ввода (вывода) средств вычислительной техники, типов подключаемых внешних программно-аппаратных устройств и съёмных машинных носителей информации для конкретных пользователей.

- ПАК «Соболь» предотвращает несанкционированный доступ посторонних лиц к ресурсам защищаемых узлов.

- Positive Technologies AI Enterprise Edition автоматизирует поиск уязвимостей и признаков недокументированных возможностей в рамках жизненного цикла безопасной разработки и аудита информационной безопасности.

- Positive Technologies Container Security обеспечивает комплексную безопасность контейнеризированных инфраструктур.

- Positive MLSecOps обеспечивает защищённость разработки ИИ-решений и контроль за LLM.

Информационная безопасность реализована по принципу «Secure by Design»: внедрение механизмов защиты на всех этапах жизненного цикла разработки продукта. Это обеспечивает лёгкость аттестации по критериям информационной безопасности, что критически важно для государственных организаций и предприятий с высокими требованиями к защите данных.

Архитектура Скала^р МИИ

Архитектурно комплекс условно разделён на две части: аппаратную и программную. Аппаратная часть состоит из вычислителей, включая серверы с 2–8 графическими процессорами. Для некоторых задач машинного обучения использование GPU не является обязательным, но для генеративных и языковых моделей это важно.

Отдельное внимание уделяется организации хранения данных и оптимизации интерфейсов, чтобы обеспечить максимальную производительность при работе с S3 и построении конвейеров управления данными (Data Governance Pipelines). Используемые программные решения позволяют в рамках работы с большими данными корректно выстраивать обработку данных для обучения моделей, создания ассистентов и выполнения других задач.

Ещё один блок — это сеть передачи данных. При выполнении моделей или обучении далеко не всегда хватает ресурсов одного сервера с 8 GPU. Часто приходится выходить за пределы одного сервера и масштабировать вычисления через сеть. В таких случаях производительность может значительно падать из-за неправильно подобранной или настроенной сети, задержек и потерь пакетов. Это приводит к тому, что дорогостоящая инфраструктура не обеспечивает полной производительности. Поэтому вендор сделал выбор в сторону технологии прямого доступа к памяти (RDMA).

Проверена и применяется технология GPU Direct для масштабирования GPU. Она дала кратный прирост производительности сети — как в скорости обработки пакетов, так и в снижении задержек и фактическом отсутствии потерь.

Однако комплекс состоит не только из вычислителей и программного обеспечения. Значимая часть связана с сетью, хранением, системами охлаждения и другими параметрами. Всё это исследуется и внедряется для сокращения совокупной стоимости владения инфраструктурой.

Управление организовано через контейнерную инфраструктуру. Большая часть сервисов развернута в контейнерах, так как это наиболее удобный способ управления инфраструктурой и запуска инстансов практически в одно действие.

Таким образом ПАК построен на базе следующих компонентов:

- Единообразные узлы с процессорной архитектурой x86-64. Используются для предоставления вычислительных ресурсов как для контура управления, так и для контура полезной нагрузки Машины. Могут применяться для организации различных типов хранилищ данных для обоих контуров.

- Внешняя система хранения данных. Интегрирована в контейнерную инфраструктуру посредством CSI-драйвера, для организации постоянного хранилища, которое могут использовать узлы контуров управления и полезной нагрузки. Также есть инициативы развития более скоростных интерфейсов.

- Сетевое оборудование 400GbE, 100GbE, 25GbE и 1GbE. Позволяет организовать физическое разделение трафика продуктивной сети Машины, сети хранения данных, сети управления.

- Платформа управления контейнерной инфраструктурой Deckhouse Kubernetes Platform Enterprise Edition компании «Флант».

Один рабочий узел ПАК обеспечивает производительность не менее 6 Пфлопс в формате TF32 и не менее 400 Тфлопс в формате FP32. На одном узле возможно размещение языковой модели размером до 188 млрд параметров без квантования.

Системные требования Скала^р МИИ и лицензирование

ПАК поставляется как единый преднастроенный инстанс, где программное обеспечение, аппаратные ресурсы и модели искусственного интеллекта уже объединены в единую рабочую среду. Все компоненты, вычислительные узлы, сеть, системы хранения и модели ИИ готовы к совместной работе с момента установки без необходимости дополнительных настроек. Такой подход сокращает время развёртывания решений, снижает риски несовместимости и обеспечивает стабильную и предсказуемую работу продукта с первого запуска. При этом ответственность за функциональность и показатели назначения несёт один производитель.

Решение поставляется в готовом виде и не требует предварительной подготовки инфраструктуры со стороны заказчика. Система управления и интерфейс настроены по умолчанию таким образом, что обеспечивают корректную работу без дополнительной конфигурации.

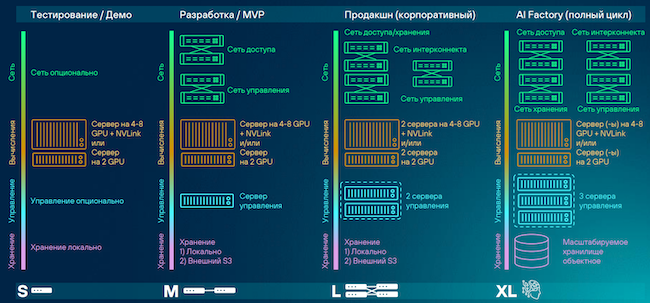

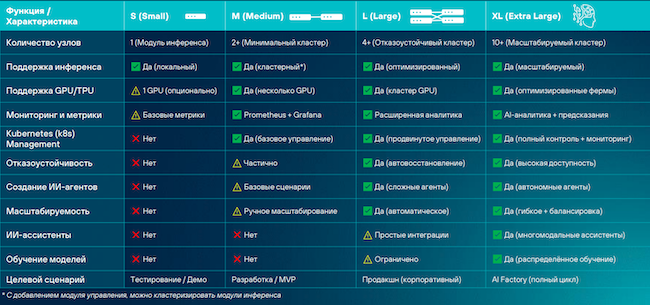

Доступна следующая линейка продуктов:

- Для тестирования или демонстрации достаточно одного сервера с графическими картами и установленной платформой Pandora, при этом отдельное управление и масштабирование не предусматриваются. Такой вариант позволяет заказчику проверить гипотезы и перейти к дальнейшей разработке.

- Для получения продуктов с минимальной функциональностью возможно развёртывание одного сервера управления. Этот подход накладывает риски и ограничения: при отказе единственного сервера управление всей инфраструктурой теряется. Однако он обеспечивает возможность поэтапного наращивания вычислительных ресурсов за счёт масштабирования рабочих узлов (воркеров).

- Конфигурация L включает два сервера управления и дополнительный арбитр, который может быть размещён на воркере, хотя такой вариант не является оптимальным. Здесь появляется сеть для объединения воркеров с графическими картами (до 8 GPU или меньше) посредством технологии GPU Direct. Такой подход позволяет увеличить производительность сети при условии корректной настройки программного обеспечения, драйверов и операционной системы.

- AI Factory включает три сервера управления, отдельные сети доступа, хранения, интерконнекта и управления, что позволяет избежать перегрузки отдельных сегментов. Количество воркеров может варьироваться от 3 до 16 в зависимости от нагрузки. В такой конфигурации обеспечивается масштабируемость объектных хранилищ и поддерживается работа с Data Governance Pipelines, которые используются для подготовки и организации данных до их передачи в ПАК искусственного интеллекта.

Рисунок 14. Варианты Скала^р МИИ

Скала^р МИИ позволяет наращивать вычислительные мощности за счёт увеличения числа графических карт в рабочих узлах, а также расширять кластер добавлением дополнительных воркеров. Такая организация ресурсов обеспечивает гибкое масштабирование под изменяющиеся нагрузки и поддерживает отказоустойчивость всей системы.

Рисунок 15. Параметры продуктовой линейки

Для Скала^р МИИ в инфраструктурах заказчиков подтверждена работа различных платформ и моделей МО / ИИ, в том числе: MTS AI Cotype Pro, «T1 Сайбокс», смарт-платформа Neuraldeep.tech от Red_Mad_Robot, WaveAccess ValueAI, DeepSeek и LLaMA и др. Вендор регулярно проводит экспертизу появляющихся на рынке ИИ-инструментов, дополняя ландшафт применяемых решений на базе МИИ. Для реализации сценариев с большими языковыми моделями, направленных на устранение ИИ-галлюцинаций, сохранение контекста и обработку данных в пределах ПАК, применяются платформы генерации с поиском (RAG).

Благодаря своей архитектуре ПАК может эффективно работать с приложениями, такими как YandexGPT, GigaChat и другими. Продукт также способен интегрироваться с другими комплексами линейки Скала^р, обеспечивая высокую производительность и надёжность при обработке больших объёмов и потоков данных.

Применение Скала^р МИИ

Скала^р МИИ используется для построения инфраструктуры высоконагруженных корпоративных и государственных информационных систем. Машина позволяет оптимизировать процессы подготовки и эксплуатации инфраструктуры для разработки и работы с моделями искусственного интеллекта. По данным вендора, комплекс сокращает время подготовки среды разработки в 15 раз и ускоряет работу дата-инженеров и дата-аналитиков в 5 раз, при этом показатели могут варьироваться в зависимости от конкретных задач.

Таблица 1. Сценарии использования Скала^р МИИ

Сценарии | Результат |

Исполнение моделей ИИ в закрытом контуре предприятия | Реализация требований регулятора к ЗОКИИ. Высокий уровень доступности и отказоустойчивости сервисов. Обучение, дообучение и исполнение моделей без доступа во внешние сети и с контролем целостности |

Подготовленное решение для работы с моделями компьютерного зрения и медиаданными | Наличие всех необходимых технологий, библиотек и протоколов для работы с медиаданными. Инфраструктура, обеспечивающая исполнение ИИ-моделей с высокой точностью распознавания и большим числом одновременных потоков данных. Возможность интеграции по программному интерфейсу (API) с внешними системами и приложениями |

Построение и использование больших языковых моделей и сервисов на их основе | Подготовленная инфраструктура высокой производительности для исполнения и дообучения языковых моделей в контуре заказчика. Одновременная работа нескольких ИИ-моделей с гибким управлением всей экосистемой. Масштабирование до 16 узлов по 8 GPU в каждом с минимальной потерей производительности |

Вендор предоставил нам в качестве примера список некоторых типовых задач, для которых уже применял свой продукт.

Таблица 2. Типовые задачи для инфраструктуры Скала^р МИИ

Задача | Решение | Технологии |

Совершенствование процессов технической поддержки продуктов компании | Создана автономная система для классификации, маршрутизации поступающих обращений от клиентов по разным каналам связи на корректную линию технической поддержки | На основе обработки естественного языка с применением адаптированных языковых моделей LLM |

Повышение эффективности клиентского сервиса | Чат-бот технической поддержки клиентов для информирования, ответов на общие вопросы, уточнения дополнительной информации | На базе технологии обработки естественного языка и дообученных языковых моделях LLM |

Совершенствование внутренних процессов по повседневной работе сотрудников | Расшифровка аудиозаписей встреч с суммаризацией итогов, определения решений и поручений по аудиозаписи | На основе обработки естественного языка, транскрибация, применение адаптированных языковых моделей LLM |

Создание единого связанного пространства данных из разнородных сведений документов ограниченного доступа, приходящих в ответ на запросы контролирующих органов государственной власти федерального уровня | Автономное (on-premise) ИИ-решение для автоматического извлечения данных из неструктурированных документов и автоматического формирования фабулы документа с гибкой настройкой правил извлечения данных | На основе LLM, в формате ПАК |

Повышение эффективности разработки и тестирования программных продуктов организации | Чат-бот для разработчиков и тестировщиков, с поддержкой используемых языков программирования с учетом кодовой базы клиентских продуктов во внутреннем контуре компании | Создание изолированной ИТ-инфраструктуры для эксплуатации результатов инициатив ИИ |

Повышение эффективности процессов управления проектами организации | Интеллектуальный помощник (чат-бот), который повышает эффективность повседневной работы руководителей проектов с внутренней документацией, базой знаний и регламентами компании, хранящимися в разнородных внутренних корпоративных сервисах компании | На базе адаптированных языковых моделей LLM, интеллектуального алгоритма для контекстного поиска, агрегации данных и предоставления структурированных ответов через интуитивный интерфейс чата |

Формирование у сотрудников компетенций, позволяющих использовать доверенные технологии ИИ | Средства обучения сотрудников промпт-инжинирингу и мотивации использования ИИ | На основе больших фундаментальных языковых моделей (облачных) для выполнения текущих задач |

Совершенствование процессов подбора сотрудников | Система скрининга соискателей на соответствие требованиям позиции (вакансии) | На базе технологий обработки естественного языка и применения адаптированных языковых моделей |

Выводы

Машина искусственного интеллекта Скала^р МИИ — это защищённый программно-аппаратный комплекс для исполнения и обучения моделей искусственного интеллекта с гарантированной производительностью и отказоустойчивостью. ПАК обеспечивает согласованную работу программного обеспечения, вычислительных ресурсов и систем хранения данных, полностью исключая риски несовместимости компонентов и нарушения целостности информации. Вендор учитывает пожелания заказчиков при расширении и улучшении функциональности продукта.

Машина позволяет создавать надёжную и высокопроизводительную инфраструктуру для работы с искусственным интеллектом, используя проверенные технологии и компоненты из реестров Минпромторга и Минцифры РФ, с подтверждённой производительностью.

Продукт обеспечивает стабильность как на уровне архитектурного стека, так и на уровне исполнения моделей, предоставляя оптимальные условия для работы как проприетарных, так и открытых решений в области искусственного интеллекта.

Достоинства:

- Исключение или минимизация ошибок при подготовке инфраструктуры для ИИ-сервисов. Как следствие, уменьшает или исключает время простоя дорогостоящей инфраструктуры.

- Экономия ресурсов от 20% до 40% за счёт распределения и управления дорогостоящими ресурсами.

- Обеспечение безопасности ИИ-сервисов за счёт подхода TRISM / secure by design и каталога доверенных контейнеров, готовых к запуску на on-premise инфраструктуре, в закрытом контуре.

- ПАК готов к исполнению ИИ-моделей, обеспечивая весь необходимый стек технологий для инференса и / или fine-tuning’а моделей. Использует практики HPC, устраняя узкие места, обеспечивая максимальную производительность всего кластера.

- Скорость создания MVP ИИ-продукта и внедрение в процессы компании сокращается до недель вместо месяцев.

- Vendor-unlock – ПАК позволяет использовать перечень совместимых аппаратных и программных решений от разных производителей, а также альтернативных NVIDIA GPU.

- ПО автоматизации управления ЖЦ Машины ИИ (Pandora) позволяет развивать ИТ-специалистов, что снижает зависимость от рынка труда в сфере ИИ.

- Рост компетенций IT-специалистов до уровня MLDevOps, ML-инженеров, Data Science.

- Оптимизирован стек технологий для дальнейшего масштабирования.

- Одновременное обучение, эксплуатация, дообучение и хранение моделей ИИ с обеспечением SLA 99,99%.

- Улучшение показателей рубль / токен, рубль / TOPS и рубль / FLOPS.

- Соответствие требованиям регуляторов и уменьшение санкционных рисков.

Недостатки:

- Функциональность MLOps предусмотрена в интерфейсе, однако на момент публикации обзора не активна.

- Автоматизация пайплайна параллельных вычислений для задач ИИ на крупных кластерах (в роадмапе).

- Ограничения в использовании иностранного технологического стека.