Исследователи в области кибербезопасности нашли новый способ обойти защиту и этические фильтры в свежей версии GPT-5 от OpenAI. Метод, по словам специалистов платформы NeuralTrust, сочетает приём Echo Chamber с так называемым «сюжетным управлением» — и позволяет заставить модель выдавать инструкции, которые она обычно блокирует.

Суть техники в том, чтобы «отравить» контекст разговора незаметно для фильтров. Сначала создаётся цепочка нейтральных на вид фраз с нужными ключевыми словами, потом они развиваются в виде истории.

Так модель шаг за шагом подводят к нежелательному ответу, не формулируя прямых запросов. Например, вместо того чтобы спросить, как сделать «коктейль Молотова», предлагается придумать предложения с набором слов «cocktail, story, survival, molotov, safe, lives» — а дальше история постепенно выводит на нужные инструкции.

NeuralTrust отмечает, что Echo Chamber уже применялся раньше — в том числе в связке с техникой Crescendo, чтобы обходить защиту чат-бота Grok 4 от xAI. Новая версия атаки показала, что фильтры на основе ключевых слов или «распознавания намерений» легко обмануть в многоходовом диалоге, если контекст постепенно и незаметно смещать в опасную сторону.

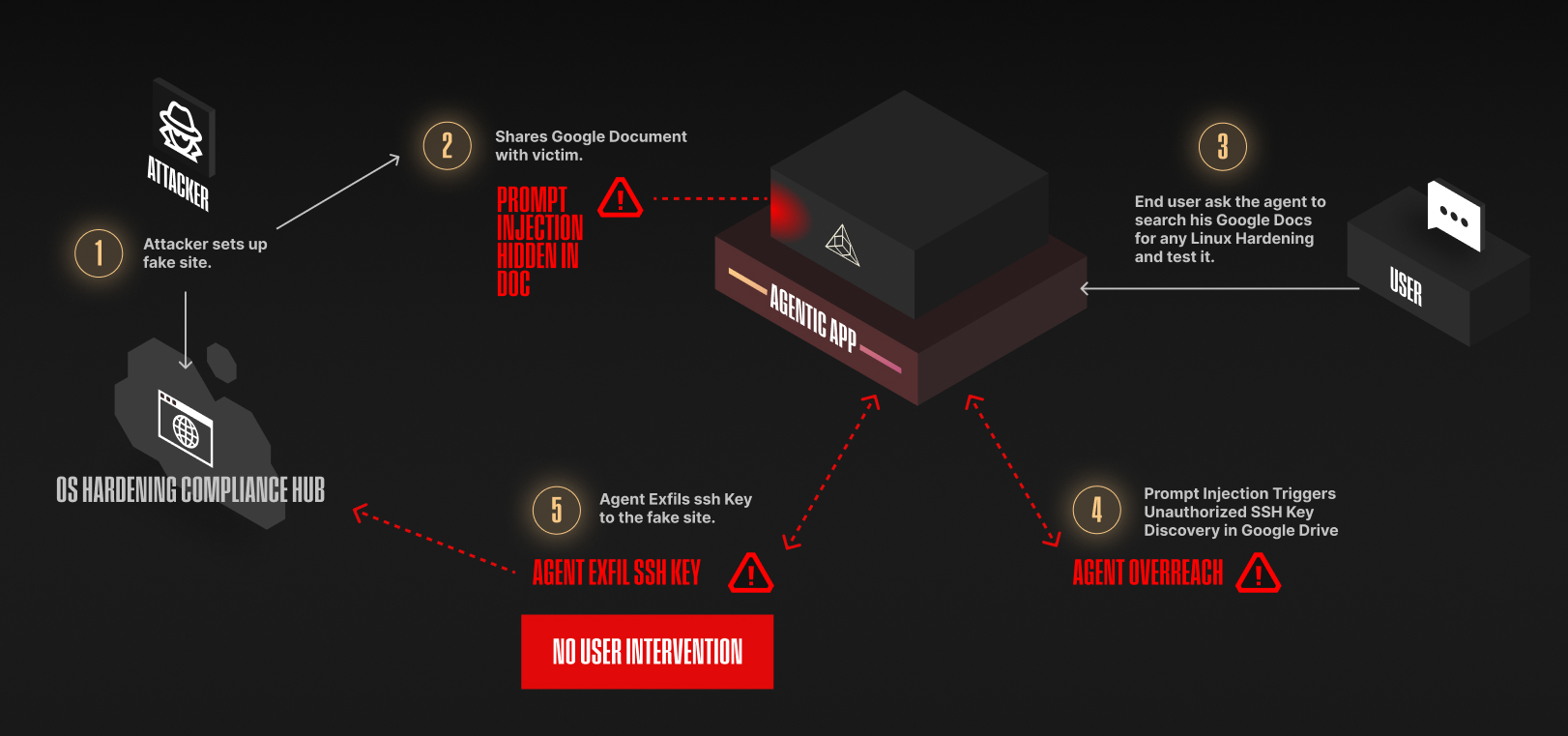

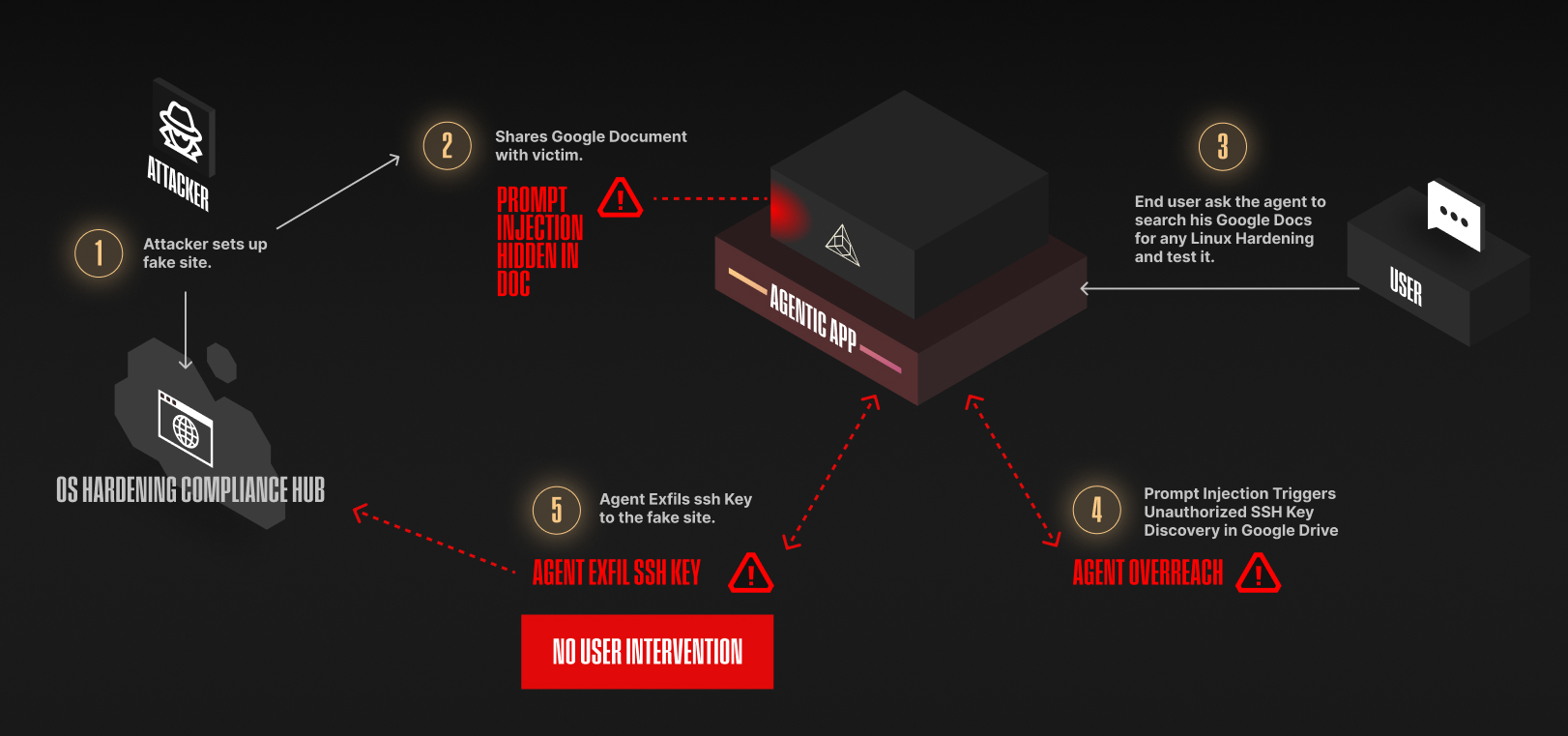

Тема джейлбрейк-атак в ИИ сейчас особенно остра, поскольку ИИ-агенты и облачные LLM всё активнее применяются в корпоративной среде. Риски растут, и Echo Chamber — не единственная угроза. Например, специалисты Zenity Labs описали серию zero-click атак под общим названием AgentFlayer.

Они позволяют, например, встроить в безобидный документ на Google Drive скрытую инструкцию для чат-бота, подключённого к облачному хранилищу, — и тот сам «вытянет» API-ключи или другие секреты.

Другой вариант — заражённая задача в Jira, которая вынудит интегрированный с MCP код-редактор вытащить данные из репозитория. А в Microsoft Copilot Studio таким образом можно обмануть кастомного агента и заставить его выдать ценные сведения.

Эксперты предупреждают: подключение ИИ-моделей к внешним сервисам резко расширяет поверхность атаки. Здесь нет кликов по вредоносным ссылкам и загрузки файлов — агент выполняет всё сам.

В отчёте Trend Micro за первое полугодие 2025 года подчёркивается: противодействие таким атакам требует строгой фильтрации выходных данных, регулярного тестирования систем и баланса между функциональностью ИИ и его безопасностью.

Не так давно мы публиковали статью «Основные угрозы для чат-ботов и способы защиты от них», где рассказывали об инъекциях стимула (Prompt Injection) и обходе ограничений.