Специалисты в области информационной безопасности предупреждают о том, что серверы облачных хранилищ Amazon AWS S3 вскоре могут стать жертвами атак вымогателей. Так уже было с базами данных MongoDB, подвергшимися таким атакам в прошлом году.

Об этом сообщил исследователь Кевин Бомонт, отметив, что с серверами Amazon AWS S3 связаны крупнейшие утечки прошлого года — например, нарушения данных АНБ, армии США и поставщиков аналитики.

Причиной этих инцидентов стало то, что компании оставляли данные на общедоступных «ведрах» S3 («ведро» — термин, используемый для описания блока хранения S3). В большинстве случаев эти данные были обнаружены исследователями безопасности, которые помогали компаниям защищать свои системы. Однако некоторая чувствительная информация попала и в руки киберпреступников.

Как отмечают эксперты, есть нечто более опасное, чем доступные для чтения извне серверы — это доступные для записи извне «ведра», позволяющие любому пользователю, с учетной записью Amazon S3 или без нее, писать или удалять данные на AWS S3. В опубликованному в сентябре 2017 года отчете Skyhigh Networks утверждается, что 7 % всех ведер Amazon AWS S3 доступны для записи извне.

Таким образом, специалисты считают, что киберпреступники, которые в прошлом атаковали серверы MongoDB, ElasticSearch, Hadoop, CouchDB, Cassandra, MySQL, теперь могут переключиться на доступные для записи S3-ведра.

Схема таких атак всегда одна — злоумышленники обнаруживают уязвимый сервер, удаляют на нем информацию, после чего требуют выкуп за восстановление данных.

«Инцидент с MongoDB показал, что такая стратегия работает даже в том случае, если злоумышленник не сохранит данные», — утверждает исследователь Дилан Кац.

Кац считает, что в случае с S3 киберпреступники будут удалять данные безвозвратно, так как такой большой объем информации нельзя будет разместить у себя. Также специалисты подчеркивают, что основная проблема кроется во владельцах учетных записей, которые неправильно настраивают серверы.

Еще один эксперт, Робби Виггинс, обеспокоенный этой проблемой, нашел тысячи проблемных серверов с неправильными настройками. Виггинс уведомил владельцев, а также опубликовал в Twitter запись, в которой утверждает, что таких серверов было обнаружено 5260.

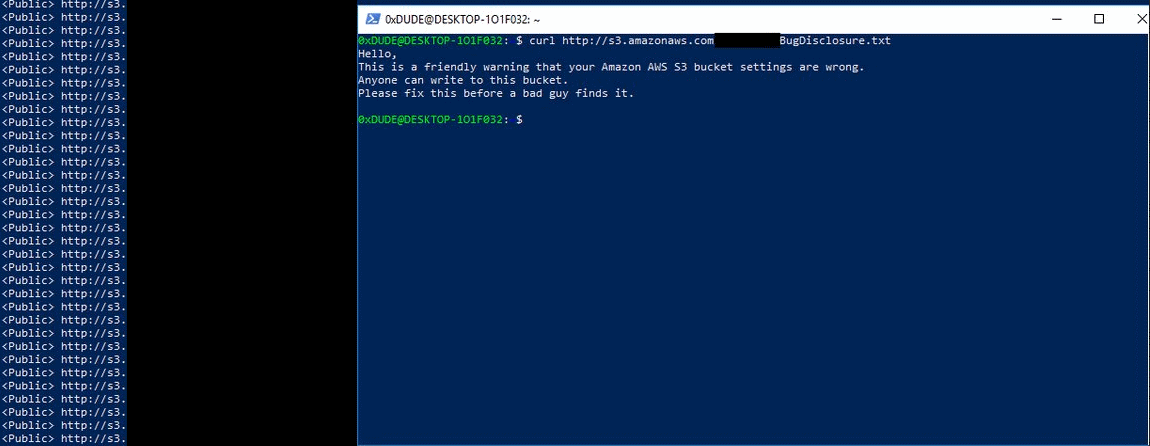

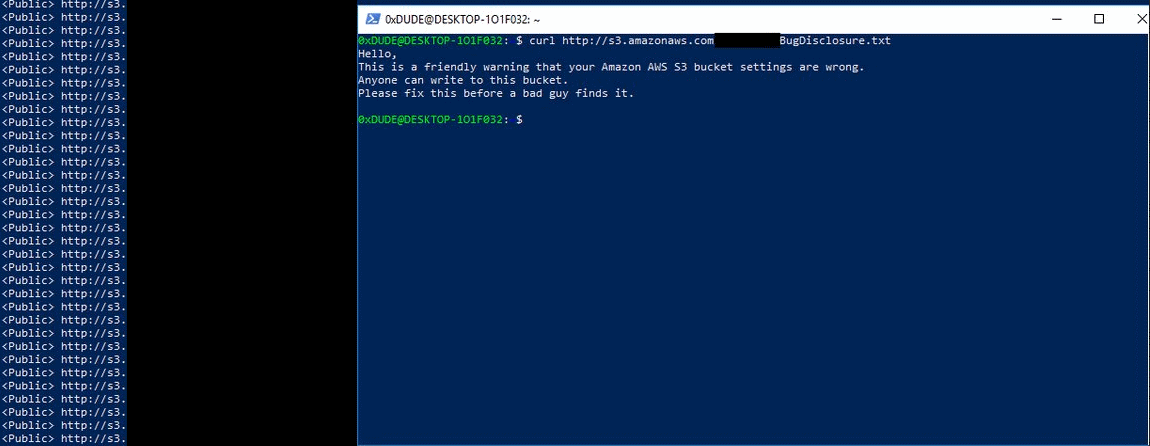

Виггинс оставил на доступных для записи «ведрах» текстовый файл, в котором содержалась следующая информация:

«Это предупреждение о том, что ваши настройки Amazon AWS S3 неверны. Любой может писать в это ведро. Исправьте это, прежде чем злоумышленник найдет эту лазейку».

Также похожее предупреждение оставил неизвестный хакер, с ним можно ознакомиться ниже:

Напомним, что в сентябре прошлого года мы сообщали о кибератаках вымогателей на MongoDB.