Разработчики WhatsApp (принадлежит Meta, признанной экстремистской и запрещенной в России) наконец-то решились на шаг, которого пользователи ждали годами. Мессенджер начал постепенно включать голосовые и видеозвонки прямо в WhatsApp Web, без установки десктопного приложения. Пока функция доступна не всем, но процесс уже запущен.

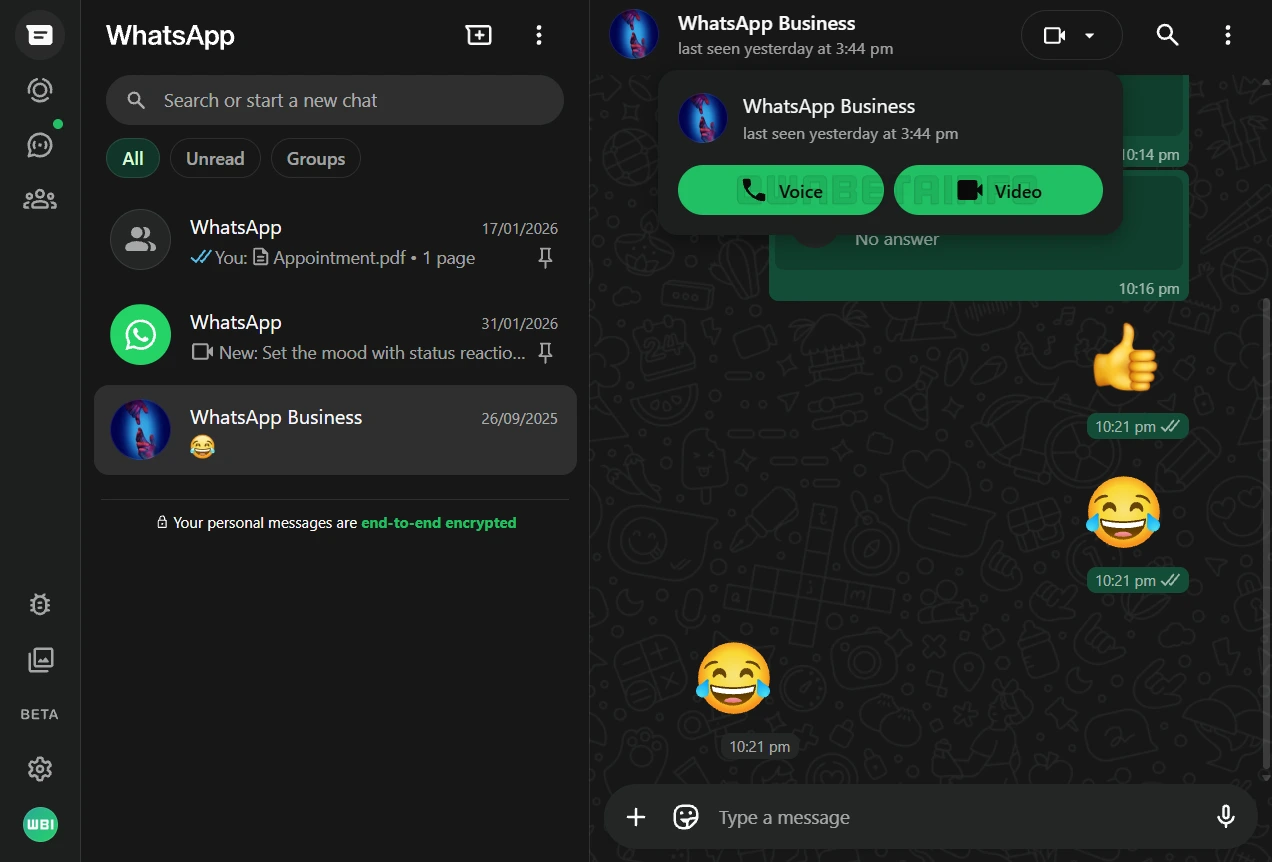

Первыми нововведение получают участники бета-программы WhatsApp Web. На стартовом этапе звонки работают в индивидуальных чатах: достаточно открыть диалог в браузере и нажать кнопку вызова — всё, как в привычных мобильных и десктопных версиях.

В прошлом месяце мы рассказывали, что в WhatsApp Web появится поддержка групповых голосовых и видеозвонков, благодаря чему пользователи смогут участвовать в звонках независимо от того, с какого устройства они подключаются.

Все звонки в веб-версии защищены сквозным шифрованием. WhatsApp использует протокол Signal — тот же самый, что уже много лет защищает сообщения, звонки и статусы в приложениях для Android, iOS и компьютеров. Никаких дополнительных настроек включать не нужно: шифрование работает автоматически.

Веб-звонки поддерживают демонстрацию экрана — правда, только во время видеовызова. Функция работает так же, как в десктопных приложениях, и подойдёт для показов документов, презентаций или рабочих экранов. Впрочем, разработчики справедливо напоминают: делиться экраном стоит только с теми, кому вы действительно доверяете.

Особенно рады обновлению будут пользователи Linux. Официального десктопного клиента WhatsApp для этой ОС нет, и раньше для звонков приходилось доставать смартфон. Теперь полноценные голосовые и видеозвонки доступны прямо из браузера, что заметно упрощает жизнь.