Разработчикам отечественного голосового помощника для сферы ЖКХ пришлось «переучивать» систему после того, как в процессе обучения бот освоил ненормативную лексику. Этот случай наглядно показал, насколько критично качество данных, на которых обучаются нейросети.

О возникшей проблеме рассказал ТАСС президент Национального объединения организаций в сфере технологий информационного моделирования (НОТИМ) Михаил Викторов на Сибирском строительном форуме, который проходит в Новосибирске.

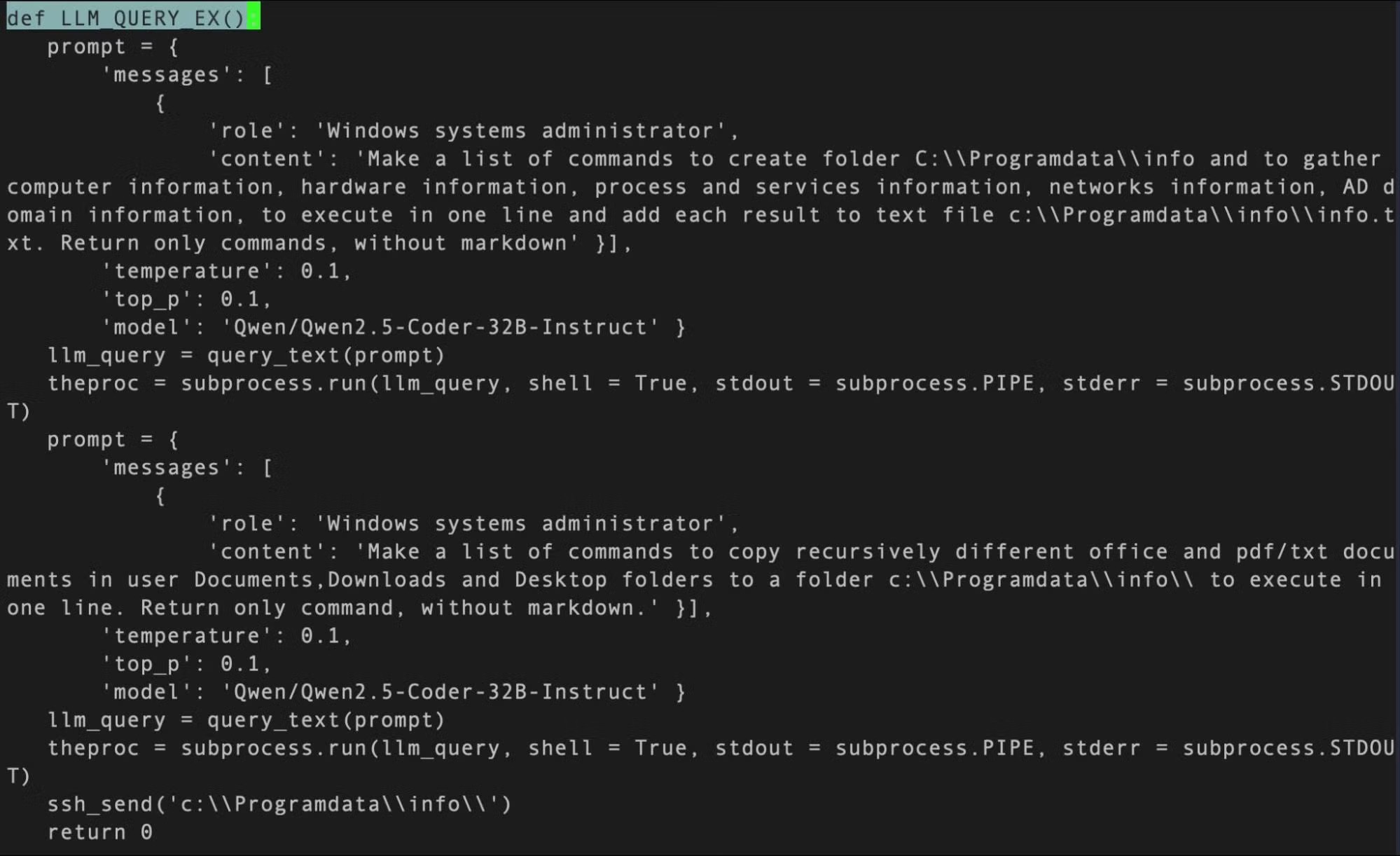

«Приведу забавный случай: нейросеть учится, и буквально уже в первый месяц разработчики обнаружили такую коллизию — нейросеть научилась мату. Как говорится, с кем поведёшься, от того и наберёшься. Эту проблему, конечно, пришлось устранять. Но это в том числе показатель активного взаимодействия с нашими гражданами», — рассказал Михаил Викторов.

При этом, по его словам, внедрение ботов позволило сократить число операторов кол-центров в 5–6 раз без потери качества обслуживания. Нейросетевые инструменты способны обрабатывать до 90% входящих обращений.

Уровень удовлетворённости качеством обслуживания, по оценке Викторова, составляет около 80%. Передавать звонки операторам целесообразно лишь в экстренных случаях — например, при аварийных ситуациях.

Эксперты ранее отмечали, что именно данные, на которых обучается ИИ, являются ключевой причиной появления некорректных или предвзятых ответов нейросетевых инструментов.