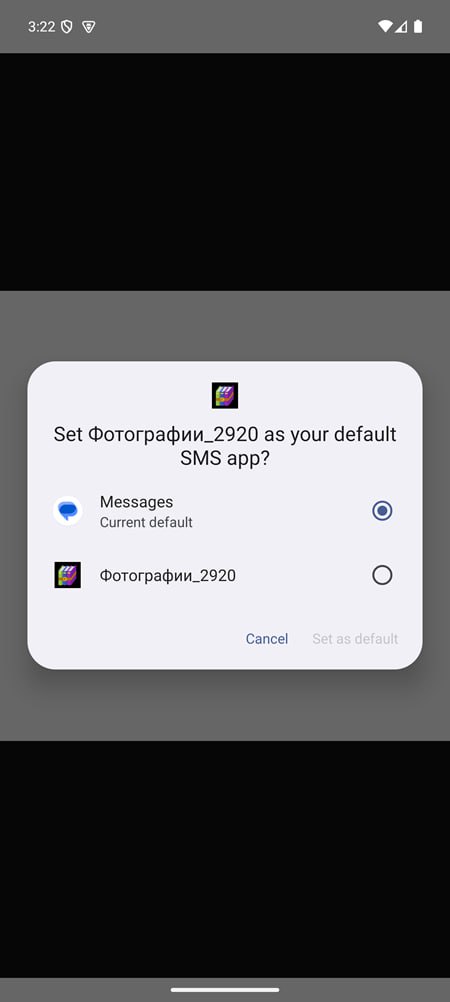

Эксперты компании «Перспективный мониторинг» (входит в ГК «ИнфоТеКС») сообщили об обнаружении нового APK-файла семейства Pulsar SMS Stealer. По их данным, вредоносное приложение распространяется под видом фотогалереи с названием «Фотографии_2920» и на 10 марта 2026 года не детектируется антивирусами.

Злоумышленники рассылают APK-файл через мессенджеры, опираясь на социальную инженерию. Дальше всё строится на доверии и невнимательности пользователя.

Вместо безобидного приложения с фотографиями человек получает троян, задача которого — перехватывать СМС-сообщения, а вместе с ними и OTP/2FA-коды, чтобы потом использовать их для кражи доступа и финансового мошенничества. Такой тип мобильных атак давно считается опасным именно из-за охоты за одноразовыми кодами.

По описанию исследователей, приложение только притворяется фотогалереей, а на деле запрашивает опасные разрешения. Речь идёт о доступе к перехвату, чтению, отправке и удалению СМС, чтению IMEI, номера телефона и данных об операторе, получению номеров двух сим-карт, автозапуске после перезагрузки, постоянной фоновой работе и полной выгрузке архива СМС на командный сервер (C2).

Технически образец тоже оказался не самым примитивным. По данным «Перспективного мониторинга», APK использует многоступенчатую архитектуру: внешний classes.dex содержит сильно обфусцированный загрузчик, который извлекает и подгружает скрытую DEX-нагрузку из assets/NwyavbTt.csz через инъекцию ClassLoader.

Уже на втором этапе находится основная логика: связь с C2, перехват СМС, снятие цифрового отпечатка устройства и механизмы закрепления. Отдельно специалисты отмечают и серьёзную маскировку сетевого трафика.

В опубликованных материалах говорится, что heartbeat-пакеты передают на сервер полный статус устройства — от состояния экрана и уровня заряда до наличия СМС-разрешений, режима Doze и параметров оптимизации батареи. Также была показана конфигурация bootstrap, где эндпоинт /m/{build_id} возвращает настройки в PEM-подобной структуре, зашифрованной AES-256-GCM.

Старший специалист по исследованию киберугроз компании «Перспективный мониторинг» Александр Рудзик отметил, что маскировку зловредов под приложения, связанные с медиафайлами, уже можно считать устоявшейся схемой. Ранее, по его словам, подобный подход фиксировался у семейства Mamont, но в этот раз образец оказался новым именно с технической точки зрения: обнаружение и анализ усложнялись многоступенчатой обфускацией и комплексной маскировкой трафика.

Кроме того, отсутствие этого файла на общедоступных платформах, по оценке исследователей, может говорить о том, что вредоносная кампания только начинает разворачиваться против физических лиц в России.