Иногда люди собирают компьютеры в корпусе побольше, иногда — в корпусе покрасивее. А иногда берут старый LEGO-кирпич с изображением компьютера, увеличивают его в десять раз и превращают в настоящую рабочую станцию. Именно так появился проект M2x2. Его автор — нидерландский дизайнер Пауль Стал из Watt IV.

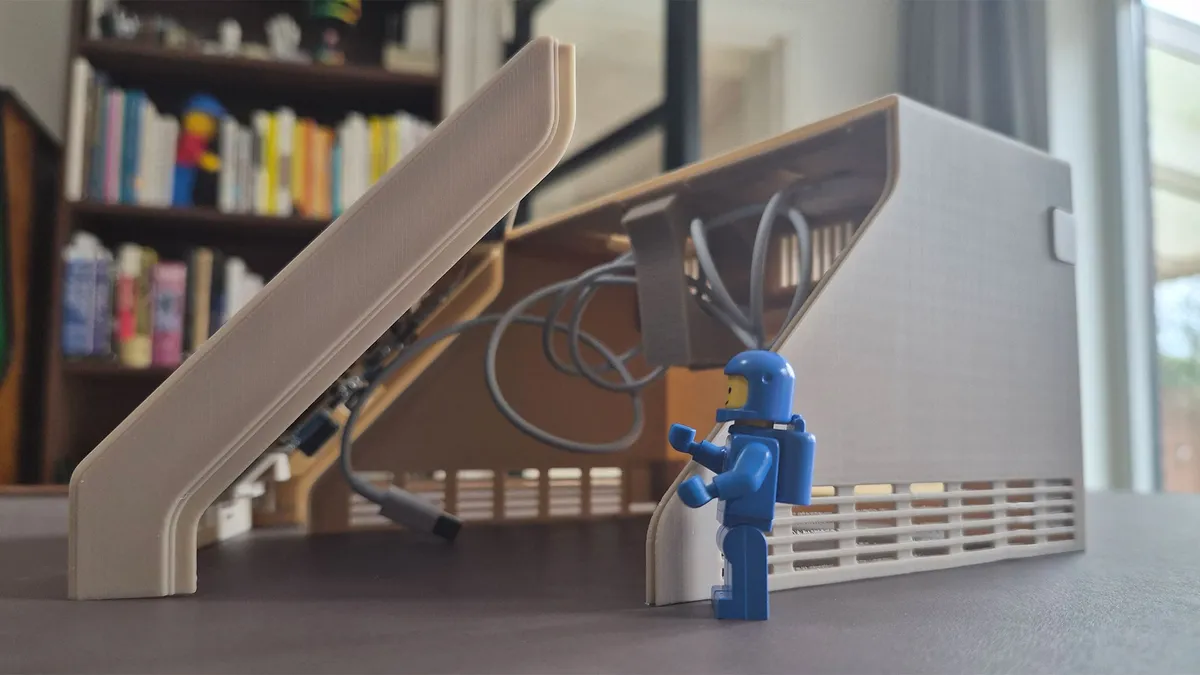

Он собрал рабочий компьютер в корпусе, который повторяет форму классической детали LEGO Part 3039p23 — той самой клиновидной «компьютерной» детали, впервые выпущенной ещё в 1979 году.

Внутри вполне бодрый Mac mini M4, дополненный 7-дюймовым IPS-дисплеем. Для корпуса, помимо самого железа, понадобились 3D-печать и примерно 20 долларов на PLA-пластик.

Самое приятное в этом проекте — внимание к деталям. Пауль не просто сделал большой пластиковый «кирпич», а постарался сохранить дух оригинальной детали LEGO. По его словам, задачка была не из простых: нужно было уместить внутри полноценный Mac mini M4, экран и набор периферии, при этом не потеряв сходство с исходным дизайном.

И, судя по результату, получилось очень даже здорово. Два круглых LEGO-шипа сверху корпуса оказались не просто декоративными. Один работает как ручка управления мультимедиа — например, для регулировки громкости или переключения треков. Второй получил более современную функцию: внутри него спрятана беспроводная зарядка для Apple Watch или AirPods.

Есть и другие симпатичные мелочи. Например, на задней части корпуса сделан специальный «карман»-углубление, которое играет роль ручки, а это уже явная отсылка к старым Macintosh. А ещё у конструкции есть откидные элементы для аккуратной укладки кабеля питания. В общем, автор явно делал не просто эффектный концепт для фото, а вещь, которой самому приятно пользоваться.

Хотя M2x2 — это полноценный самодостаточный компьютер, встроенный 7-дюймовый экран всё же сложно назвать идеальным вариантом для постоянной работы в 2026 году. Поэтому в повседневном режиме Стал использует систему вместе с большим монитором LG DualUp, а встроенный дисплей в основном показывает панель Home Assistant.

Отдельно радует, что автор не стал держать проект только для себя. Он подробно рассказал о процессе создания M2x2 в блоге и даже выложил .STL-файлы для 3D-печати. Так что при желании повторить эту необычную сборку смогут и другие энтузиасты (если, конечно, под рукой есть 3D-принтер, немного терпения и любовь к странным проектам).