Переход на Windows 11 долго считался вопросом времени. Рано или поздно, дескать, всё равно придётся. Однако теперь специалисты по защите данных всё чаще говорят обратное: если вам важна конфиденциальность, с обновлением лучше повременить.

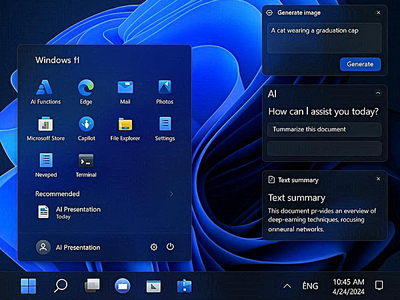

Поводом для тревоги стала ИИ-функция Recall, о которой пишет PCWorld. Она способна автоматически сохранять скриншоты экрана и, по мнению экспертов, может фиксировать важные данные: пароли, банковскую информацию, медицинские сведения и другую информацию.

Организация Centre for Digital Rights and Democracy прямо рекомендует пользователям, работающим с конфиденциальными данными, избегать Windows 11 вообще. Причина простая: даже если Recall отключён, он остаётся частью операционной системы.

Microsoft утверждает, что функция доступна только на Copilot+ PC, но, как отмечают эксперты, Recall обнаружен на всех компьютерах с Windows 11 версии 24H2. А значит, теоретически его можно активировать через обновления и без согласия пользователя.

Пока Recall встроен в систему, он рассматривается как потенциальный риск, а постоянная запись экранного контента, по мнению правозащитников, может даже нарушать требования GDPR.

Специалисты по защите данных выделяют несколько сценариев — с разной степенью риска:

- Остаться на Windows 10, пока она получает патчи.

Самый надёжный вариант, но только до октября 2026 года, когда закончится программа расширенной поддержки. - Перейти на Windows 11 и отключить Recall.

Частично снижает риски, но не решает проблему полностью: функция остаётся в системе. - Перейти на Windows 11 и довериться Microsoft.

Эксперты оценивают этот вариант как наименее безопасный — политика компании может измениться в любой момент.

С учётом того, что у Windows 10 есть чёткая дата окончания поддержки, правозащитники всё чаще советуют заранее рассматривать альтернативы, в первую очередь — Linux, как более прозрачную и контролируемую платформу.

«Ситуация вокруг Windows 11 наглядно показывает, к каким последствиям может привести поспешное внедрение новых технологий. Стремясь как можно быстрее вывести на рынок ИИ-функции, Microsoft сталкивается с серьёзными вопросами безопасности. Для коммерческих организаций — особенно в финансовом секторе, государственных структурах и на объектах критической информационной инфраструктуры — такие риски недопустимы.

Операционная система Astra Linux изначально разрабатывалась с фокусом на защиту корпоративных данных: безопасность здесь не дополнительная надстройка, а базовый элемент архитектуры. В платформе реализованы развитые механизмы защиты, включая мандатный контроль целостности (МКЦ), который обеспечивает комплексный подход — предотвращает несанкционированный доступ к данным, контролирует целостность системных файлов и блокирует их модификацию, разграничивает доступ на уровне процессов и надёжно защищает от утечек информации.

Эти механизмы проверены временем и позволяют нашим заказчикам быть уверенными в сохранности критически важной информации», — прокомментировал Роман Мылицын, руководитель отдела перспективных исследований «Группы Астра».