В прямом эфире AM Live разберём, как встроить безопасность в жизненный цикл ИИ: от защиты данных и моделей до мониторинга атак в продакшене. Покажем реальные примеры adversarial-атак и poisoning, обсудим, как компании выстраивают процессы MLSecOps, какие инструменты работают сегодня и как избежать типичных ошибок. Только практические кейсы, честный анализ и опыт экспертов, которые уже защищают ИИ-системы в реальных проекта.

- Основы MLSecOps и картина угроз

- MLSecOps — buzzword или реальная новая дисциплина? Почему безопасность ИИ нельзя свести к AppSec или DataSec, и где проходит граница между ними?

- Что защищать в ML и LLM-проектах? Где различие между атакуемыми поверхностями — данные, пайплайн, модель, промпты, API, агенты? Можно ли сказать, что в ML мы защищаем данные и модель, а в LLM — контекст и поведение? Или это слишком грубое разделение?

- Может ли быть единая архитектура защиты ML и LLM? Или всё-таки нужны два разных подхода, две команды, два цикла?

- Кто владелец MLSecOps-процесса? Это зона CISO, Chief Data Scientist или product owner AI-сервиса? Где она реально живет в компаниях?

- Как встроить безопасность в MLOps-поток? Где место для security-гейтов: при сборе данных, обучении, валидации, деплое, мониторинге?

- Как вы тестируете модели на безопасность? Есть ли аналоги DAST/SAST для моделей — например, model fuzzing, adversarial testing, red teaming?

- Как выглядит безопасный CI/CD для ML? Что можно заимствовать из DevSecOps, а что требует уникальных шагов?

- Как интегрировать ML-мониторинг в SOC? Что реально можно детектить: атаки на модель, утечку данных, аномальные промпты, дрейф поведения?

- Кто в компании должен анализировать такие сигналы — SOC, ML-инженеры или отдельная команда MLSecOps?

- Как правильно выстроить логирование запросов к модели, чтобы балансировать между безопасностью, качеством расследования и приватностью пользователей?

- Где чаще всего ломается MLSecOps? Типичные ошибки — от игнорирования угроз до переусложнения пайплайна.

- Можно ли встроить контроль происхождения данных (data provenance) в ML-пайплайн? Или это пока недостижимый идеал?

- Работают ли DLP-подходы для датасетов, или это только красивая идея из презентаций?

- Adversarial и poisoning-атаки: какие из них реально встречаются в продакшне, а какие остаются лабораторными демонстрациями?

- Можно ли считать drift — не просто операционной проблемой, а атакой, если злоумышленник намеренно вызывает его?

- Какая атака сегодня недооценена, но завтра может стать системной угрозой?

- Помните ли вы свой первый реальный инцидент с атакой на ML или LLM? Что это было, как вы поняли, что это именно атака?

- Как защитить модели от утечек знаний (model extraction / inversion)? Насколько вообще реально предотвратить «утечку интеллекта» модели?

- Стоит ли регулярно проверять модели на вредоносные фрагменты, небезопасные сериализации или утечки — своего рода “антивирус для моделей”?

- Что делать с угрозой prompt injection? Какие контрмеры реально работают, а какие — просто маркетинговые “патчи”?

- Можно ли сделать “DLP для ИИ”? Как предотвратить утечку чувствительных данных в промптах и ответах моделей?

- Практика: как защищать ML-пайплайны

- Что сейчас есть на рынке средств MLSecOps? Где граница между реальными продуктами и «research-вебинарами»? Какие решения уже применяются в проде?

- Может ли explainable AI (XAI) использоваться как инструмент безопасности — для поиска аномалий или выявления неестественных зависимостей?

- Сколько денег в рынке AI Security? Почему инвестиции растут медленнее, чем в классический AppSec, и где “бутылочное горлышко”?

- Нужен ли централизованный стек MLSecOps — вроде SIEM, но для моделей? Что будет ядром: Data Lake, Model Registry, Feature Store или AI Firewall?

- MLDR — это уже практика или пока концепт? Что реально внедряется?

- Регуляторика AI и MLSecOps: где уже есть требования к безопасности моделей (NIST AI RMF, EU AI Act, ISO/IEC 42001, приказ ФСТЭК №117), и как это повлияет на рынок?

- В каких отраслях, по-вашему, первыми появятся обязательные требования к безопасности ML — финансы, госсектор, ИТ?

- Как компании готовятся к аудиту AI-безопасности? Можно ли применять классические подходы (ISMS, SOC2, ISO 27001), или нужен новый формат верификации моделей?

- Где проходит граница между приватностью и безопасностью? Пример: если запретить логирование запросов и ответов — как тогда расследовать инциденты и предотвращать утечки?

- Будущее и прогнозы

- Будет ли MLSecOps самостоятельной профессией? Или это временный этап эволюции DevSecOps-инженера?

- Как бизнесу определить, какой уровень робастности модели ему нужен? Можно ли измерять это KPI-подобно, как “security posture”?

- Если бюджет на MLSecOps ограничен — куда бы вы вложились в 2026 году: в защиту данных, hardening моделей или мониторинг?

- Если бы вы строили MLSecOps с нуля, какие три шага сделали бы первыми?

Приглашенные эксперты:

|

|

Антон Конопак Руководитель отдела DevSecOps, «Инфосистемы Джет» |

|

|

Антон Башарин Старший управляющий директор, AppSec Solutions |

|

|

Александр Лысенко Ведущий эксперт по безопасной разработке,К2 Кибербезопасность |

|

|

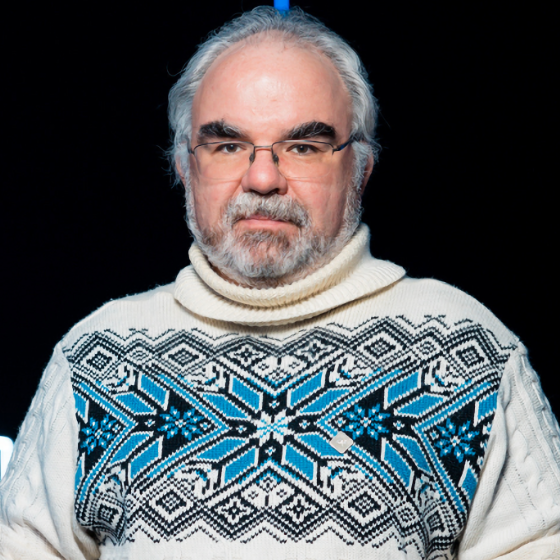

Игорь Бирюков Генеральный директор, InfEra Security |

|

|

Светлана Газизова Директор по построению процессов DevSecOps и безопасности ИИ, Positive Technologies |

|

|

Денис Турдаков Руководитель Исследовательского центра доверенного искусственного интеллекта, ИСП РАН |

Модераторы:

|

|

Алексей Лукацкий Chief Evangelist Officer, Positive Technologies |