Meta добавляет новые инструменты против мошенничества сразу в Facebook, Messenger и WhatsApp (принадлежат корпорации Meta, признанной экстремистской и запрещённой в России). Идея простая: предупредить пользователя ещё до того, как он успеет попасться на подозрительную схему.

Похожие антискам-меры компания уже анонсировала раньше, а в 2025-2026 годах тема явно стала для неё одной из приоритетных.

В WhatsApp новая защита касается запросов на привязку устройства. Если система замечает подозрительные сигналы в таком запросе, пользователю покажут предупреждение с дополнительным контекстом, в том числе откуда именно идёт попытка привязки.

Это должно помочь остановить схему, в которой жертву убеждают ввести код или отсканировать QR-код, а потом фактически подключают аккаунт WhatsApp к устройству мошенника.

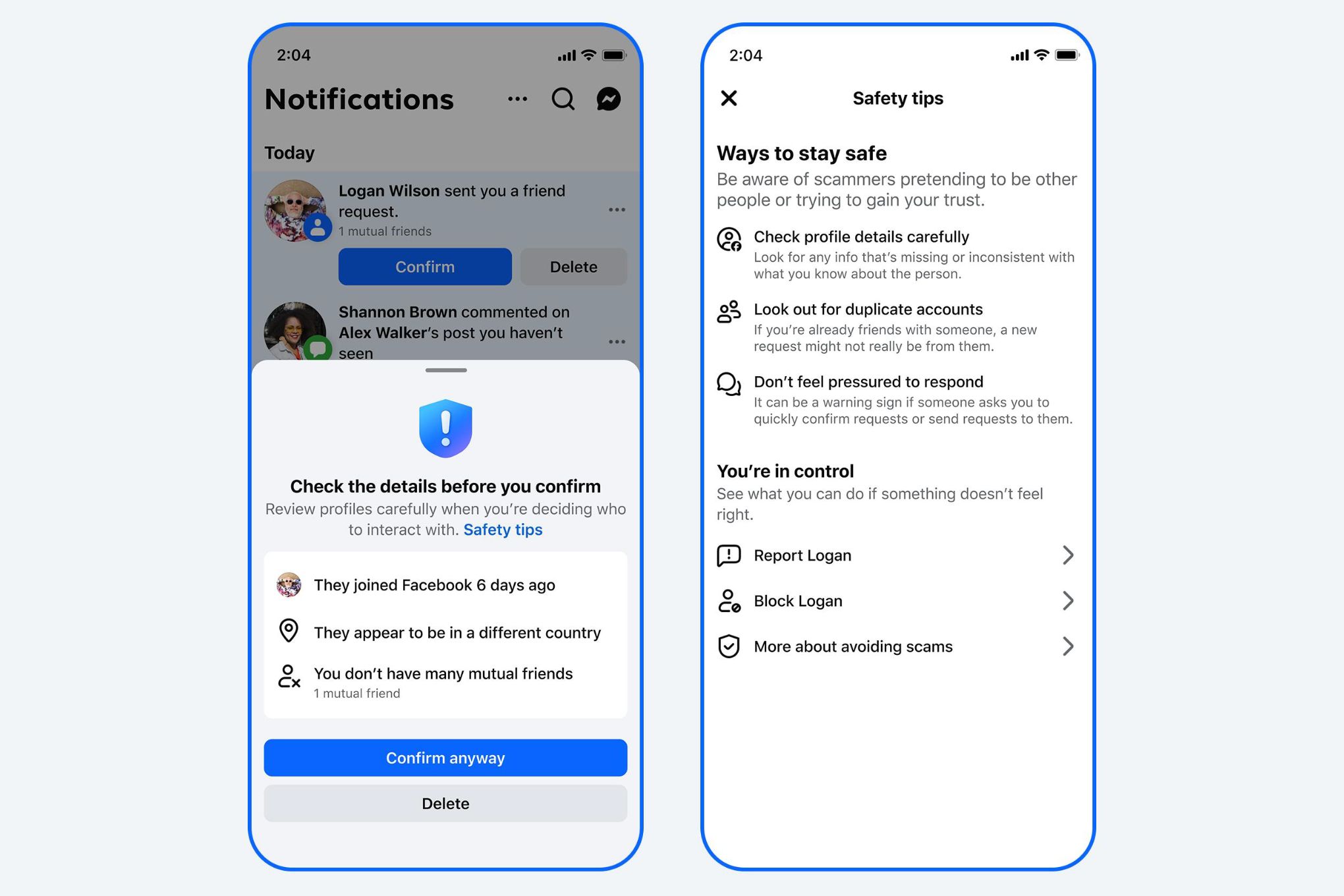

В Facebook компания тестирует похожие предупреждения для подозрительных запросов в друзья. Сигналом могут стать, например, отсутствие общих друзей или другие признаки аномальной активности аккаунта. Логика здесь та же: не запрещать действие автоматически, а дать пользователю чуть больше информации перед тем, как он нажмёт «принять», «отклонить» или «заблокировать».

Meta только в 2025 году удалила более 134 млн мошеннических рекламных объявлений, а раньше также рассказывала о массовом удалении аккаунтов, связанных со скам-центрами.

На днях в свежей бета-версии WhatsApp появилась новая функция с участием Meta AI. Теперь пользователи могут структурировать диалоги с ИИ: каждый новый промпт запускает отдельную «ветку» общения.