Исследователи Malwarebytes обнаружили фишинговую кампанию, в которой злоумышленники маскируются под Google и предлагают пользователям пройти «проверку безопасности» аккаунта. На деле всё заканчивается установкой вредоносного веб-приложения, способного перехватывать одноразовые коды, воровать адреса криптокошельков и даже использовать браузер жертвы как прокси для атак.

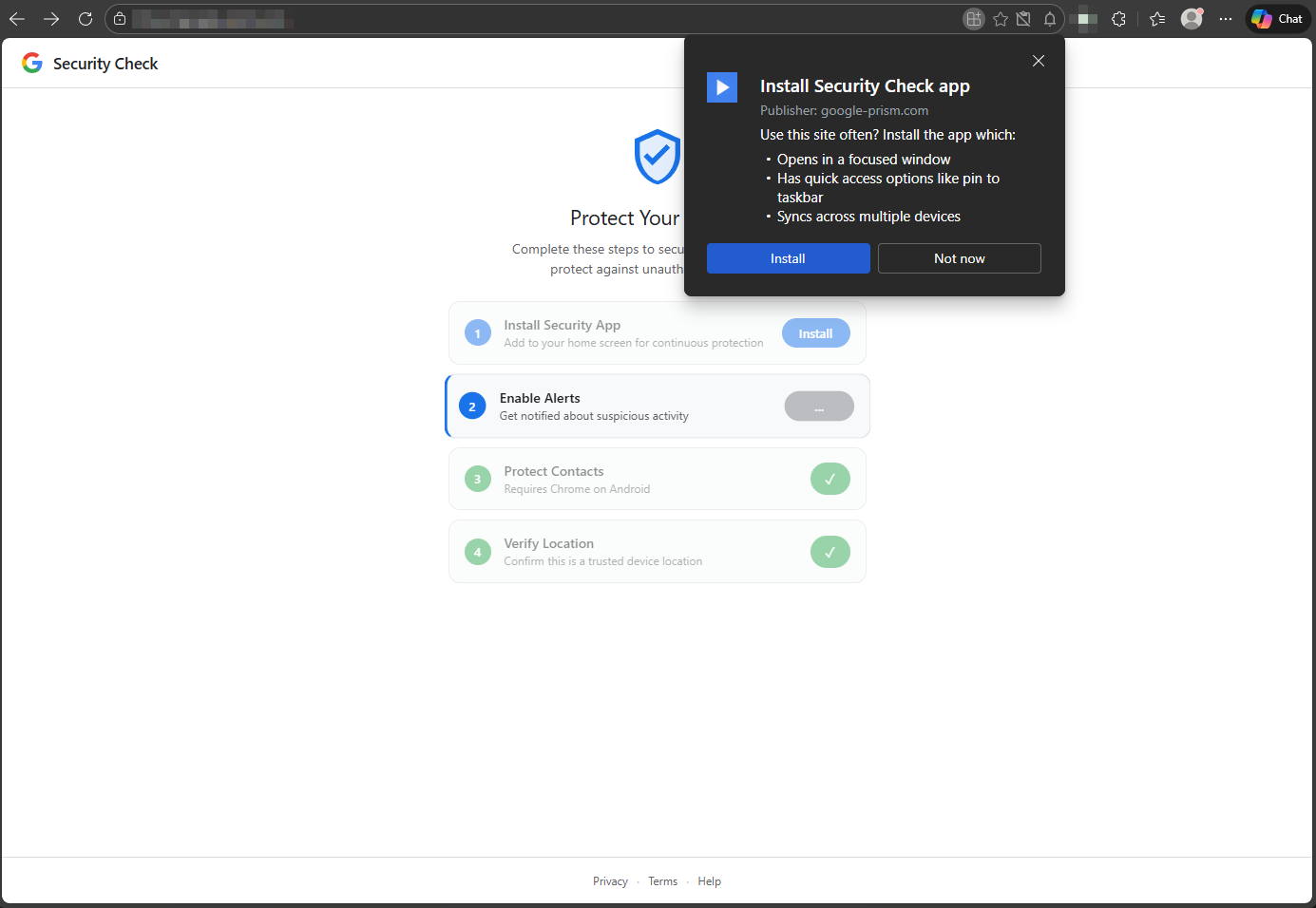

Сценарий выглядит убедительно. Пользователь попадает на сайт с доменом google-prism[.]com, который оформлен как сервис безопасности Google.

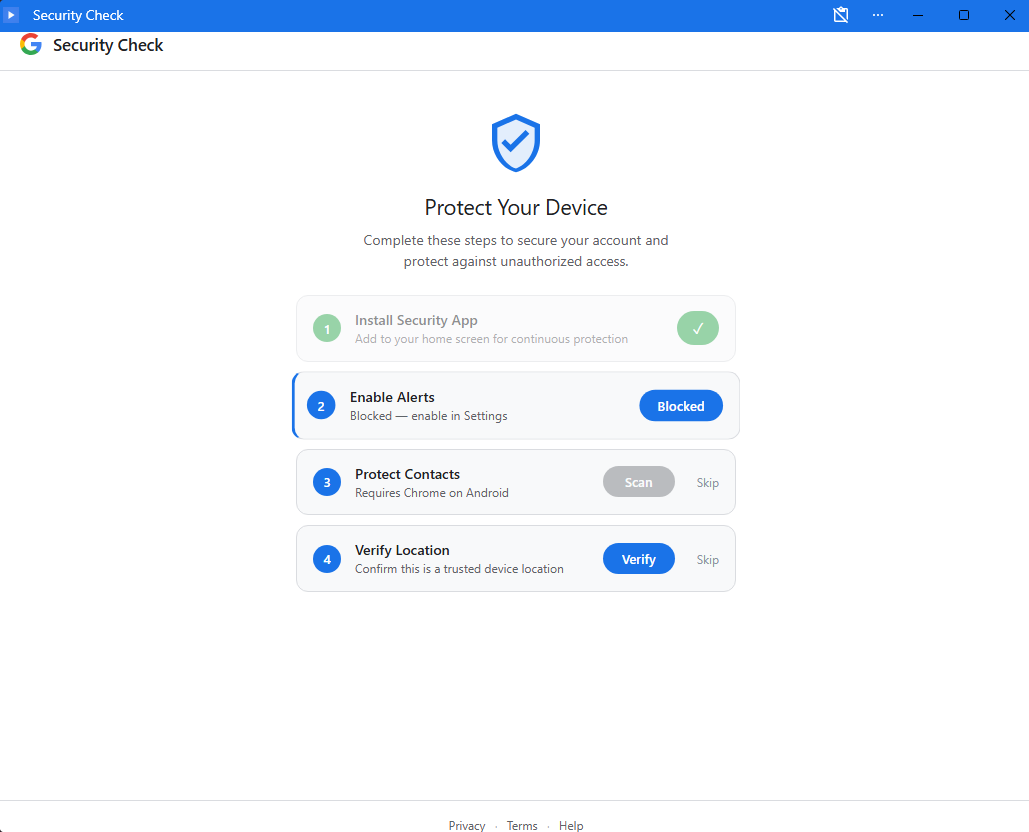

Ему предлагают пройти несколько шагов «для усиленной защиты»: выдать разрешения, включить уведомления и установить прогрессивное веб-приложение (PWA). В некоторых случаях дополнительно предлагается скачать APK-файл для Android якобы для защиты контактов.

Особенность PWA в том, что такое приложение устанавливается прямо из браузера и выглядит почти как обычная программа — открывается в отдельном окне без привычной адресной строки. Этим и пользуются атакующие.

После установки вредоносное веб-приложение получает доступ к буферу обмена, геолокации, контактам и уведомлениям. Оно также использует WebOTP API, чтобы попытаться перехватывать коды подтверждения из СМС. При этом каждые 30 секунд приложение проверяет сервер злоумышленников на наличие новых команд.

Отдельно исследователи отмечают функцию WebSocket-ретрансляции: по сути, браузер жертвы превращается в HTTP-прокси. Атакующий может отправлять через него веб-запросы так, будто находится внутри сети пользователя, и получать полные ответы с заголовками. Это позволяет сканировать внутреннюю сеть и взаимодействовать с ресурсами от имени жертвы.

Даже если Android-приложение не установлено, веб-версия уже способна перехватывать данные из буфера обмена (в том числе адреса криптокошельков), одноразовые пароли и собирать цифровой отпечаток устройства.

Если же пользователь скачивает APK, риски возрастают. Приложение запрашивает 33 разрешения: доступ к СМС, звонкам, микрофону, контактам и специальным возможностям ОС. Внутри обнаружены компоненты для перехвата нажатий клавиш, чтения уведомлений и извлечения учетных данных. Для закрепления в системе зловред регистрируется как администратор устройства и запускается при старте системы.

В Malwarebytes подчёркивают: никакие настоящие проверки безопасности Google не проводятся через всплывающие веб-страницы и не требуют установки стороннего ПО. Все инструменты защиты доступны только через официальный аккаунт Google.