Во встраиваемых компьютерах Moxa обнаружена уязвимость, позволяющая при запуске девайса получить криптоключи LUKS в открытом виде путем пассивного мониторинга SPI-шины, соединяющей дискретный TPM с системой на чипе.

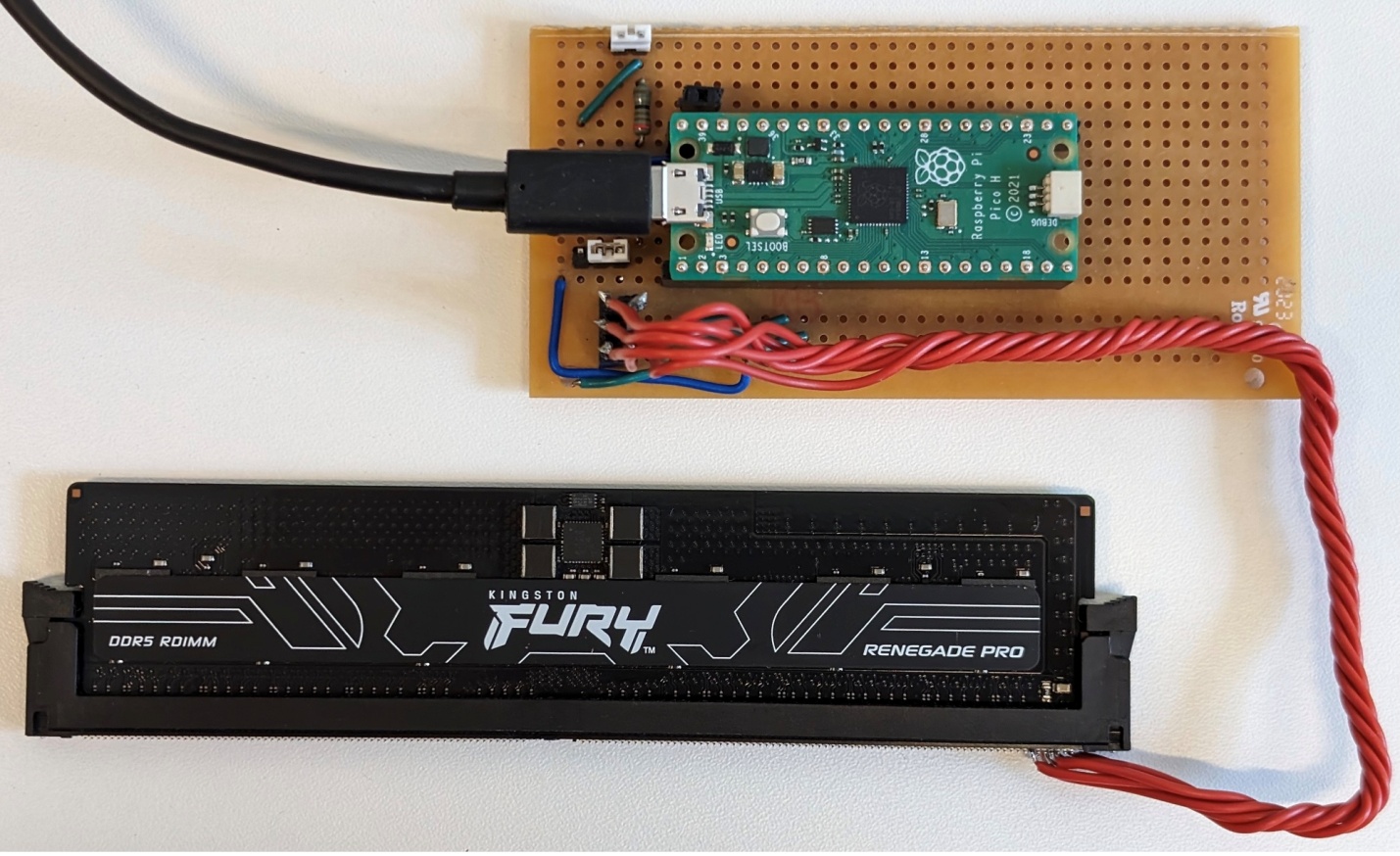

По словам авторов опасной находки из Cyloq, для сниффинг-атаки на TPM в данном случае, кроме физического доступа к устройству, понадобится лишь анализатор логики.

Для проведения PoC-атаки был выбран Moxa UC-1222A Secure Edition на базе ARM с модулем TPM 2.0, использующий LUKS для полного шифрования дисковой памяти.

Эксплойт CVE-2026-0714 (доставка секрета без криптозащиты при выполнении TPM2_NV_Read) с успехом отработал, и ключ, позволяющий расшифровать все данные в памяти устройства, был в итоге получен, хотя это и заняло некоторое время.

Ранее попытки применения TPM-сниффинга были замечены лишь в атаках на BitLocker; эта возможность давно не дает покоя Microsoft. Специалисты Cyloq доказали, что риск велик и для промышленных устройств на базе Linux.

Обезопасить команды и ответные параметры, передаваемые по шине SPI, поможет криптозащита, однако в условиях автоматизированного запуска компьютеров без GUI реализация таких сессий затруднительна.