Автономные ИИ-агенты представляют всё большую угрозу безопасности компаний. Опасность теперь исходит не только из злонамеренных действий, но и из избыточного доверия. Данные могут быть скомпрометированы, а атаки на промежуточные платформы — повлиять сразу на множество бизнесов.

- 1. Введение

- 2. ИИ как новая инсайдерская угроза

- 3. Платформенный риск и эффект масштаба

- 4. Первая реальная атака

- 5. Как справиться с новой угрозой

- 6. Выводы

Введение

Использование ИИ-агентов трансформирует логику внутренних угроз. До 40 % внутренних инцидентов уже связано с автономными агентами, что говорит о расхождении между архитектурой современных ИТ-систем и способами защиты от киберугроз. Сотрудники доверяют слишком много данных нейросетям и могут стать жертвами вредоносных приложений, которые маскируются под агентов.

ИИ как новая инсайдерская угроза

В прошлом году 83 % компаний зафиксировали как минимум один инсайдерский инцидент. Но если раньше речь шла преимущественно о человеческом факторе, например, умысле или неосторожности, то сегодня всё чаще источником риска становятся автономные ИИ-агенты, встроенные в корпоративные системы.

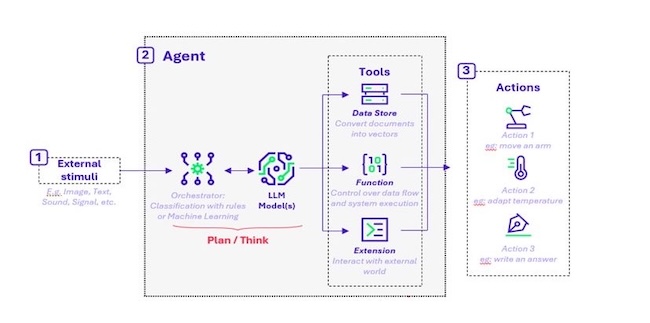

Сам по себе ИИ-агент не намерен нарушать правила. Но агенты проектируются как помощники, поэтому им доверяют множество задач: им разрешают читать почту, обращаться к CRM (Customer Relationship Management, система для управления взаимоотношениями с клиентами) и ERP (Enterprise Resource Planning, планирование ресурсов предприятия), выполнять запросы к внутренним базам данных, вызывать внешние API и принимать решения в рамках бизнес-процессов.

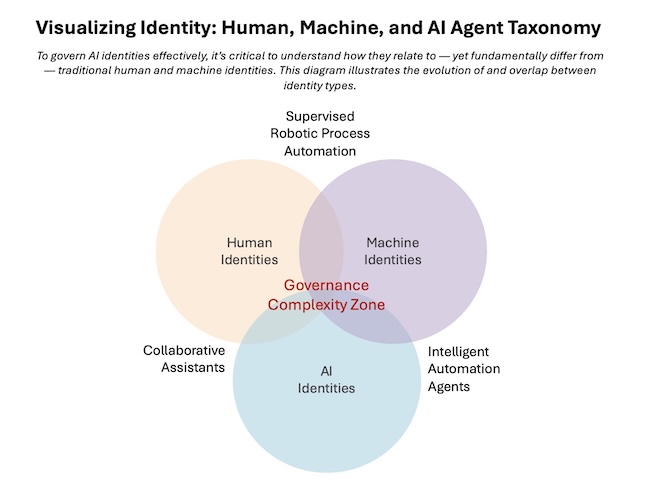

В результате агент, по сути, становится цифровой идентичностью с более широкими правами, чем у рядового сотрудника.

Агенты действуют непрерывно и автоматически не связаны с человеческими ограничениями. Они могут адаптировать поведение, менять последовательность вызовов API, структуру запросов и источники данных. А их аутентификация чаще всего строится на токенах, сервисных аккаунтах или API-ключах, владение которыми даёт полный контроль над аккаунтом и действиями пользователя.

Рисунок 1. Структура управления идентичностями с учётом внедрения ИИ-агентов. Источник: AI Frontiers

Атаки на ИИ-агентов реализуются не через вредоносный код, а через компрометацию идентичности. Захват API-ключа или токена авторизации позволяет злоумышленнику унаследовать все его разрешения, но, с точки зрения корпоративных систем контроля, остаться правомерным. Такая активность не сопровождается аномалиями вроде необычных IP-адресов или геолокаций, и отследить их становится сложнее.

Злоумышленники могут не только получить доступ к корпоративным данным, но и использовать ИИ-ресурсы компании для сторонних задач, например выполнять вычисления в своих интересах. Агента могут использовать как промежуточное звено для атак на цепочку поставок через интеграции с партнёрскими системами и внешними API.

Платформенный риск и эффект масштаба

Около 58 % компаний заявляют, что активно используют ИИ для обнаружения угроз, но часто они не проводят инвентаризацию, не отслеживают жизненный цикл и не применяют принципы минимальных привилегий. ИИ становится одновременно и инструментом защиты, и источником новых атак.

По данным отраслевых исследований, в прошлом году до 40 % внутренних инцидентов безопасности прямо или косвенно были связаны с автономными ИИ-агентами. При этом 76 % опрошенных специалистов уровня CISO (Chief Information Security Officer, директор по информационной безопасности) и CSO (Chief Security Officer, директор по безопасности) в крупных организациях отмечают, что ИИ-агенты стали самой сложной для контроля категорией, намного сложнее облачных сервисов на ранних этапах внедрения.

Рисунок 2. Схема работы ИИ-агента. Источник: RiskInsight

Современные ИИ-агенты не разворачиваются как полностью изолированные решения. Их встраивают в существующую архитектуру, они используют общие платформы, централизованные модели, сторонние библиотеки и типовые интеграции с облачными сервисами. Ошибка или уязвимость в одном слое может затронуть сотни или тысячи организаций одновременно.

В рамках одного из недавних исследований специалисты по безопасности смогли получить несанкционированный доступ к популярной платформе для ИИ-агентов Moltbook менее чем за 3 минуты. В результате были раскрыты около 1,5 млн токенов аутентификации, в том числе десятки тысяч аккаунтов, использовавшиеся для доступа к корпоративным системам крупнейших компаний.

Аналитики отмечают, что в отличие от классических атак на цепочки снабжения, агентам нужно намного меньше времени для нарушения работы. Один скомпрометированный компонент автоматически наследуется всеми агентами, которые на него опираются. В результате атака масштабируется быстрее, чем успевают сработать механизмы обнаружения.

Компании внедряют ИИ-агентов значительно быстрее, чем успевают выработать нормативные требования к их эксплуатации. В большинстве юрисдикций автономные агенты до сих пор рассматриваются либо как программное обеспечение общего назначения, либо как вспомогательный аналитический инструмент. Это приводит к ситуации, в которой высокорисковые системы с доступом к персональным и коммерчески чувствительным данным работают без строгого аудита и сертификации.

В отличие от традиционных ИТ-сервисов, поведение агента сложно формализовать заранее. Он может менять последовательность действий, источники данных и способы достижения цели в зависимости от контекста. Для систем мониторинга это означает рост серой зоны. Активность выглядит легитимной, но её последствия становятся заметны лишь после утечки или нарушения бизнес-процессов.

Первая реальная атака

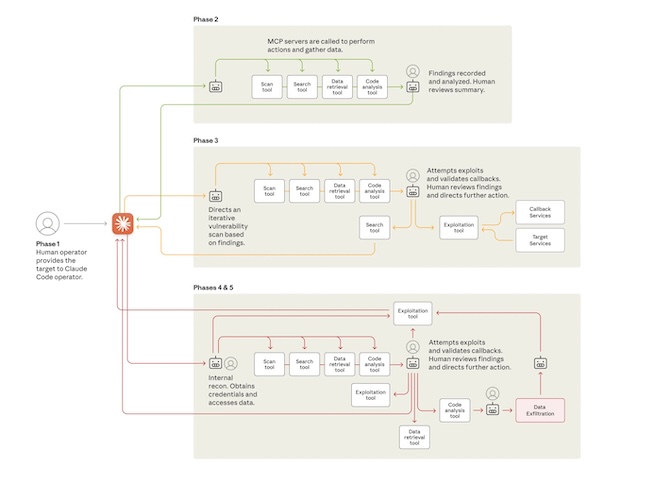

Компания-разработчик ИИ-сервисов Anthropic сообщила о первой зафиксированной атаке с использованием агентов в сентябре 2025 года. Ей подверглись более 30 крупных компаний и государственных органов. По оценке экспертов компании, за операцией стояла китайская государственная APT-группа. ИИ применялся именно как автономный исполнитель атаки.

Злоумышленники использовали возможности инструмента Claude Code — среды, предназначенной для автоматизированной разработки и выполнения кода. Модель работала в режиме автономного цикла. Она самостоятельно принимала решения, инициировала действия, анализировала результаты и корректировала стратегию с минимальным вмешательством оператора.

Рисунок 3. Жизненный цикл кибератаки с использованием ИИ-агентов. Источник: Anthropic

Оператор определял цель и создавал фреймворк, в котором Claude Code функционировал как автономный агент. Поскольку Claude обучен избегать вредоносного поведения, злоумышленники разбили вредоносные задачи на цепочку мелких, нейтрально выглядящих действий. Модель не получала полного контекста атаки.

Используя доступ к инструментам через Model Context Protocol, модель писала и тестировала собственный код, проверяла уязвимости. По оценке расследования, ИИ выполнил до 90 % операций всей атаки, тогда как человеческое вмешательство требовалось лишь в нескольких ключевых точках принятия решений.

По официальной информации расследователей, кампания была выявлена в процессе активности, и после обнаружения началось оперативное реагирование. В течение примерно 10 дней команда провела форензик-анализ, заблокировала задействованные аккаунты по мере их идентификации, уведомила затронутые организации и передала материалы соответствующим государственным органам.

Как справиться с новой угрозой

Ответ на рост инсайдерских рисков, связанных с ИИ-агентами, кроется в ином подходе к безопасности. Следует перейти от контроля пользователей и сервисов к управлению автономными цифровыми субъектами, у которых своя логика принятия решений.

Следует признать ИИ-агента полноценной идентичностью. Каждый агент должен быть явно зарегистрирован в системе управления идентификацией, иметь назначенного владельца, описанный жизненный цикл и формализованный набор полномочий.

Исследования показывают, что организации, внедрившие инвентаризацию агентных идентичностей и привязку к ответственным лицам, сокращают количество инцидентов, связанных с неконтролируемым доступом, в среднем на 30–35 % уже в течение первого года.

Также следует перейти от статического контроля к анализу поведения. Традиционные системы мониторинга фиксируют факт доступа или действия, но не оценивают его в контексте. Нужно подготовить поведенческие профили, указать, какие данные агент обычно запрашивает, в каком объёме, в какие часы, через какие API. Отклонения от этого базового профиля могут стать триггерами для проверки или изоляции агента. По данным пилотных внедрений в академическом и корпоративном секторе, такие меры позволяют выявлять до 70 % потенциально опасных сценариев до момента фактической эксфильтрации данных.

Управление разрешениями и динамическая авторизация также помогут справиться с угрозой. Практика показывает, что большинство ИИ-агентов работают с избыточными правами. Применение принципа минимально необходимого доступа существенно снизит ущерб при компрометации.

В одном из кейсов, реализованном в американском университете, пересмотр модели идентификации агентов, ограничение сроков жизни токенов и внедрение обязательной повторной авторизации для чувствительных операций привели к снижению числа инцидентов, связанных с ИИ-агентами, на 47 % за 12 месяцев.

Следующий шаг — адаптация процедур реагирования на инциденты. Компрометация агента требует иных действий, чем взлом пользовательского аккаунта. Помимо немедленной изоляции, критически важно сохранить данные, журналы запросов, цепочки решений, входные данные и результаты действий. Это позволяет не только локализовать ущерб, но и выявить, где произошёл взлом. Организации, включившие агент-специфичные сценарии, сократили среднее время реагирования на такие инциденты на 40–50 %.

Выводы

Ключевая проблема заключается в том, что ИИ-агенты действуют в рамках выданных им прав, которые часто избыточны и плохо задокументированы. Компрометация агента ведёт к получению доступа над огромным количеством данных и действий, и потому такие инциденты сложнее обнаружить.

Ошибки в архитектуре, управлении токенами или логике контроля масштабируются сразу на десятки и сотни организаций. Регуляторные и отраслевые стандарты не успевают меняться за темпами внедрения автономных систем, и ответственность за управление этими рисками фактически ложится на сами компании. Практика показывает, что эффективное снижение рисков требует смены подхода к безопасности.

ИИ-агенты должны рассматриваться не как вспомогательное ПО, а как высокорисковые цифровые идентичности. Компании, которые уже сейчас интегрируют агентные системы в общую модель управления рисками, получают стратегическое преимущество. Остальные рискуют столкнуться с тем, что автономность, призванная повысить эффективность бизнеса, превратится в источник системной уязвимости.