Android-вредонос FakeCalls опять дал о себе знать: троян имитирует телефонные вызовы более чем от 20 финансовых организаций в надежде выудить у клиентов банков данные их карт и другую важную информацию.

FakeCalls нельзя назвать новичком на ландшафте киберугроз. В апреле прошлого года мы писали, что этот зловред перехватывает звонки жертвы в техподдержку банка. Авторы маскировали его под одно из банковских приложений, отображая официальный логотип.

Теперь специалисты Check Point сообщают о новых образцах FakeCalls, в которых появилось несколько новых функциональных возможностей, позволяющих уходить от защитных решений.

«Мы обнаружили более 2500 семплов этого вредоноса, каждый из которых использовал маскировку под разные финансовые организации. Кроме того, эта версия FakeCalls задействует техники антианализа», — пишет Check Point в отчёте.

«Авторы трояна уделили особое внимание защите своего детища и имплементировали ряд уникальных функций, которые ранее нам не встречались».

FakeCalls попадает на устройство жертвы с помощью фишинга или вредоносного сайта. Одна из новых функций трояна — «multi-disk» — манипулирует данными ZIP-заголовка файла APK. Именно так зловред устанавливает высокие значения EOCD-записи, чтобы запутать защитные решения.

Ещё один механизм реализует манипуляцию файлом AndroidManifest.xml, что помогает спрятать имя изначального создателя файла.

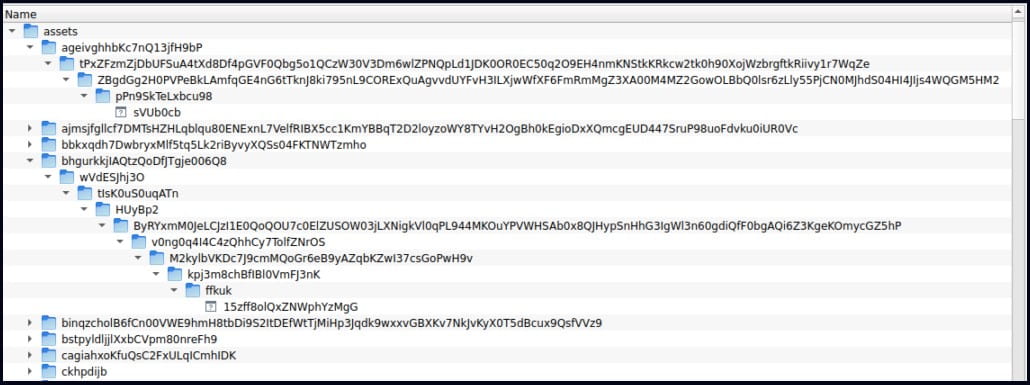

Последний один новый приём FakeCalls — добавить множество файлов внутрь директорий в APK, в результате чего имена файлов и пути превышают 300 символов. По словам Check Point, это также может затруднять детектирование трояна.