Киберпреступники, работающие, по словам зарубежных специалистов, на Россию, начали прибегать к новой технике для запуска кода на компьютере жертвы. Этот подход рассчитан на использование движений мыши в презентациях Microsoft PowerPoint.

Таким образом, атакующим не требуются вредоносные макросы для запуска скрипта PowerShell. Согласно отчёту Cluster25, новый метод взяла на вооружение киберпреступная группировка APT28, также известная под именем “Fancy Bear“.

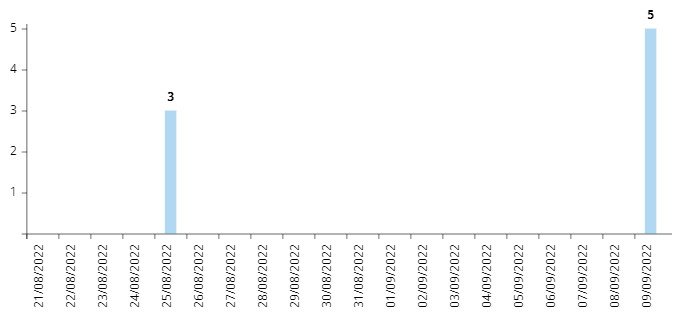

Исследователи отмечают, что в этих кампаниях злоумышленники устанавливают в системы жертв вредоносную программу Graphite. Одну из таких атак зафиксировали 9 сентября 2022 года.

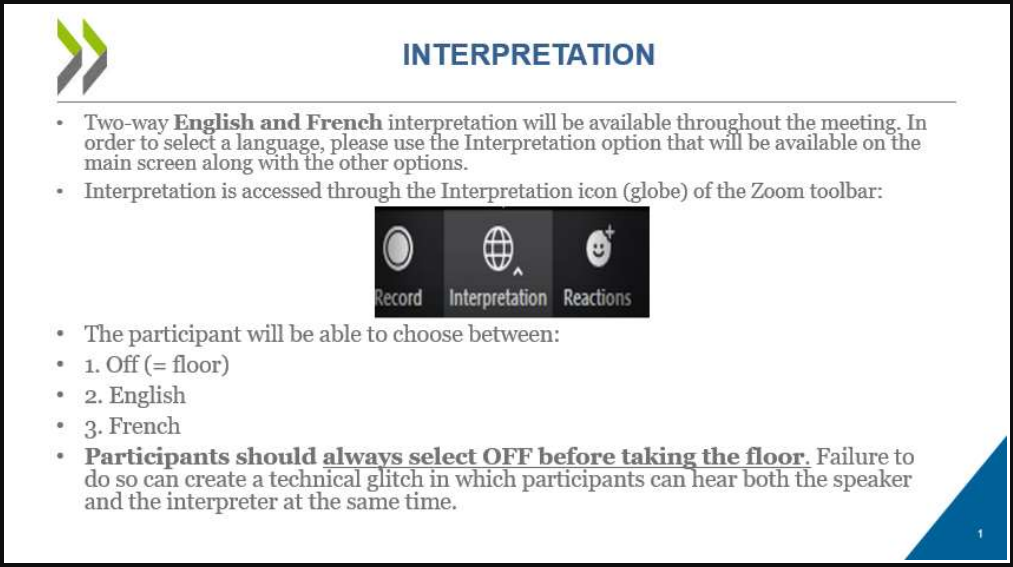

В качестве приманки используется файл в формате .PPT (презентация PowerPoint), который якобы связан с Организацией экономического сотрудничества и развития (ОЭСР) — международным экономическим органом развитых стран.

Внутри PPT-файла располагаются два слайда, на которых изображены инструкции на английском и французском языках. В этих инструкциях объясняется, как пользоваться функцией перевода в сервисе для видеоконференций Zoom.

Кроме того, в отправляемых PPT-файлах была гиперссылка, которая как раз и выступала триггером для запуска вредоносного скрипта PowerShell с помощью утилиты SyncAppvPublishingServer.

В отчёте Cluster25 эксперты говорят, что злоумышленники подготавливали эти кампании с января по февраль. Если посмотреть на график, соответствующие URL также всплывали в августе и сентябре.

При открытии документа-приманки в режиме презентации жертве достаточно навести указатель мыши на гиперссылку, чтобы активировать вредоносный скрипт и загрузить на компьютер файл в формате JPEG — “DSC0002.jpeg“. Изображение, кстати, скачивается из аккаунта Microsoft OneDrive и сохраняется в директории C:\ProgramData\, после чего запускается с помощью rundll32.exe.

Далее в дело вступает следующий пейлоад — lmapi2.dll, который сбрасывает и расшифровывает второй JPEG-файл, загружая его сразу в память. Главный вредонос Graphite использует API Microsoft Graph API и OneDrive для взаимодействия с командным сервером.