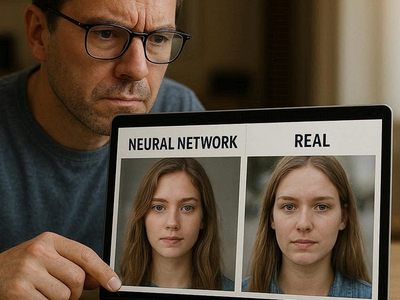

Согласно исследованию агентств Spektr и СКОТЧ, 77% участников не смогли отличить изображения, созданные нейросетями, от реальных фотографий. В опросе приняли участие около 1000 человек. Респондентам в случайном порядке показывали пять изображений, из которых четыре были сгенерированы ИИ, а одно — подлинное.

Результаты исследования приводит РБК. Корректно определить сгенерированные изображения смогли лишь 23% опрошенных.

При этом в более молодых возрастных группах показатели оказались выше. Среди респондентов до 30 лет правильный ответ дали 30%, в группе 31–44 года — 25%.

В числе признаков «настоящего» фото участники называли убедительные детали, реалистичные свет и тени, а также естественную улыбку человека в кадре. Например, изображение с улыбающимся мужчиной чаще других считали реальным участники в возрасте 45–60 лет — 28% из них выбрали именно этот вариант.

Примечательно, что доля тех, кто ошибается при определении ИИ-контента, растёт. Согласно результатам исследования MWS, опубликованным летом 2025 года, правильно распознать сгенерированные изображения смогли более трети респондентов.