Google, похоже, решила ещё сильнее закрутить гайки в режиме Advanced Protection Mode на Android. На этот раз речь идёт о WebGPU в Chrome — функции полезной и современной, но, как выясняется, не самой спокойной с точки зрения безопасности.

Advanced Protection Mode появился в Android 16 как режим защиты «в один клик». Он рассчитан в первую очередь на пользователей из группы повышенного риска — например, тех, кто может стать целью сложных кибератак, шпионских кампаний или попыток кражи данных. При его включении система активирует самые жёсткие защитные механизмы Android.

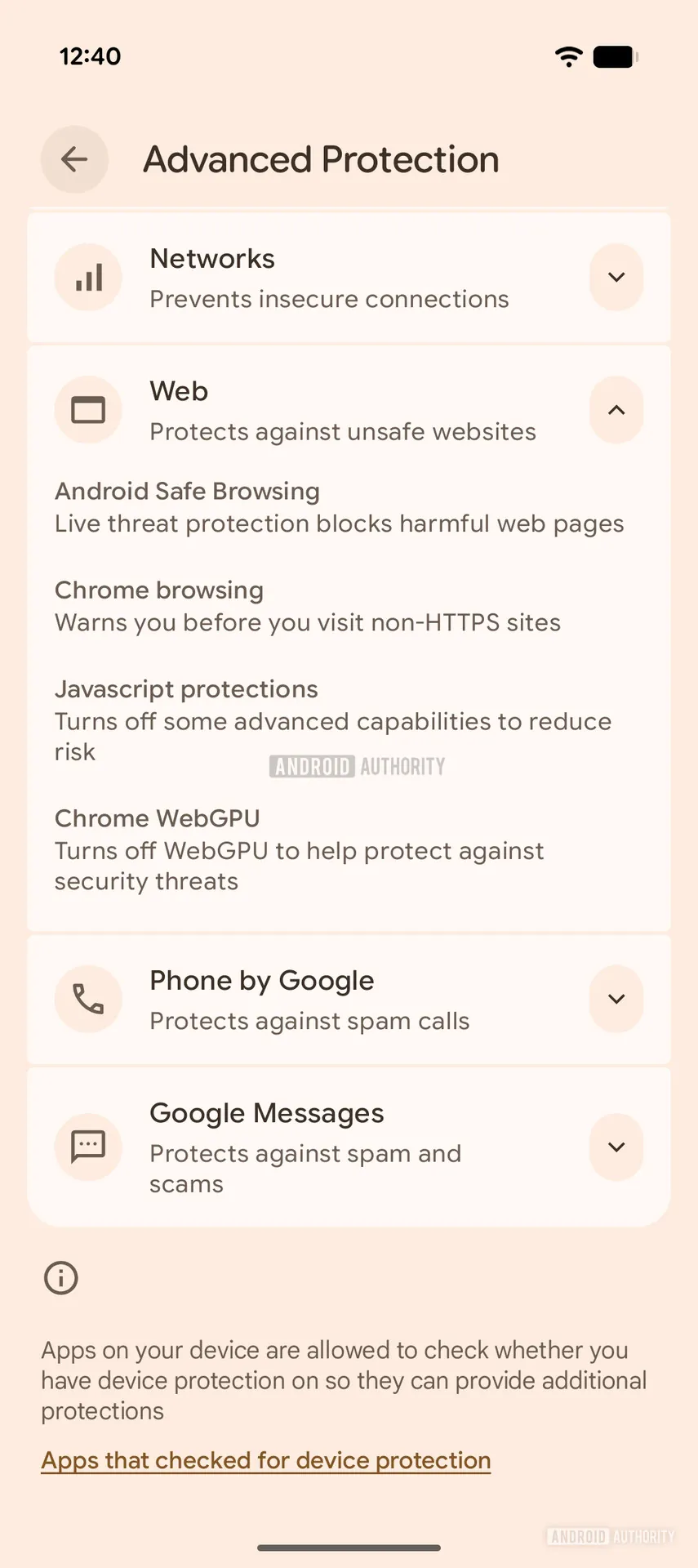

Теперь Google тестирует ещё одну меру: отключение WebGPU API в Chrome, если пользователь включает Advanced Protection Mode. Следы новой настройки обнаружили в Google Play Services v26.10.31.

В интерфейсе она выглядит вполне прямо: «Turn off WebGPU to help protect against security threats», то есть WebGPU предлагается выключить ради снижения рисков.

Сам WebGPU — это API, который позволяет веб-приложениям использовать графический процессор устройства для сложных вычислений и более быстрой отрисовки графики прямо в браузере. По сути, это более современный наследник WebGL с лучшей совместимостью с актуальными GPU, поддержкой вычислений общего назначения и доступом к более продвинутым графическим возможностям.

На практике штука мощная. Но именно в этом и проблема, поскольку чем больше у веб-кода возможностей работать почти вплотную к железу, тем интереснее он становится для злоумышленников. WebGPU уже связывали с уязвимостями, которые в отдельных случаях могли использоваться для удалённого выполнения кода. Да, такие дыры со временем закрывают, но обычно уже после того, как их кто-то нашёл. А до этого окна возможностей вполне хватает для атак на конкретные цели.

Сейчас WebGPU включён по умолчанию в Chrome 121 и новее на устройствах с Android 12+, если они используют Qualcomm или ARM GPU. То есть технология уже работает на довольно большом числе современных смартфонов.

Именно поэтому идея Google выглядит логично: если пользователь сознательно включает максимальную защиту, браузерные функции с потенциальной поверхностью атаки лучше заранее урезать.